一、介绍

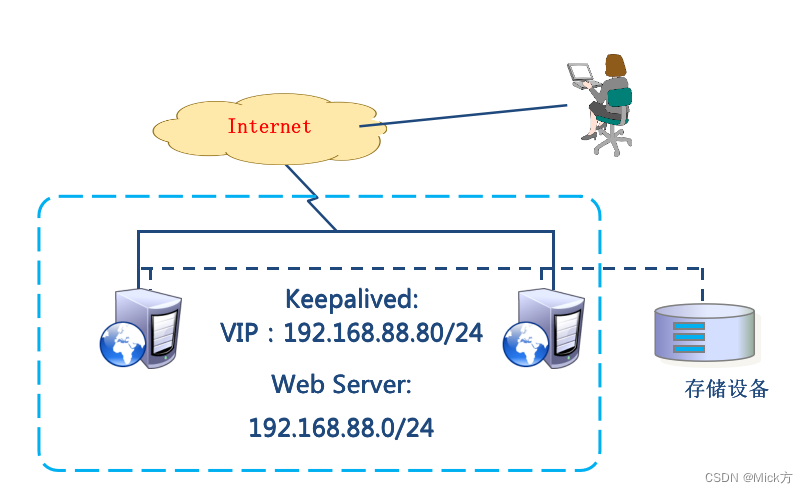

Keepalived 是一个用于 Linux 平台的高可用性软件。它实现了虚拟路由器冗余协议 (VRRP) 和健康检查功能,可以用于确保在多台服务器之间提供服务的高可用性。Keepalived 可以检测服务器的故障,并在主服务器宕机时,自动将备份服务器提升为主服务器,确保服务的持续性和可用性。

Keepalived 可以在主备服务器之间动态分配虚拟 IP 地址,使客户端能够在主备服务器之间无缝切换,提高服务的可用性。此外,Keepalived 还支持基于文本文件的配置和基于 SNMP 的监控。它可以与常用的负载均衡器配合使用,如 HAProxy、Nginx 等。

总的来说,Keepalived 是一个功能强大的工具,可用于提供高可用性服务。它是一个免费的开源软件,广泛应用于企业和个人服务器环境中。

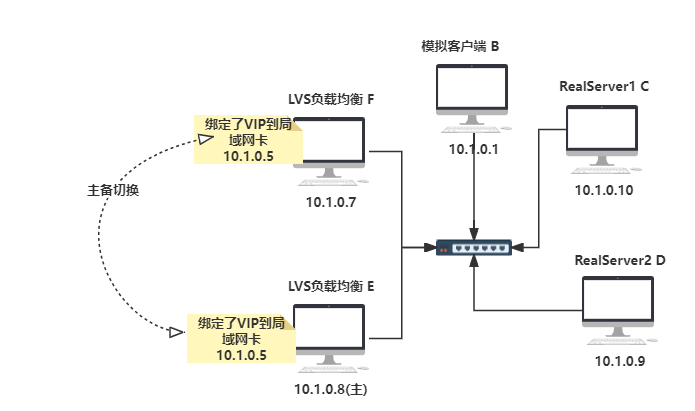

| IP | 名称 | 备注 |

|---|---|---|

| 10.1.0.7 | LVS负载均衡器(备) | VIP->10.1.0.5 |

| 10.1.0.8 | LVS负载均衡器(主) | VIP->10.1.0.5 |

| 10.1.0.9 | Web01节点 | |

| 10.1.0.10 | Web02节点 | |

| 10.1.0.1 | 内网客户端 |

二、软件安装

2.1 LVS负载均衡器主和备安装LVS软件

systemctl stop firewalld

yum -y install ipvsadm

2.2 两台Web服务器安装Web服务

yum install httpd -y

cd /var/www/html

echo "from ooxxip" > index.html

service httpd start

2.3 LVS负载均衡器主和备安装Keepalived软件

[root@lvs01 ~]# yum -y install keepalived

# 安装

yum install keepalived -y

# 启动

service keepalived start

# 配置文件位置

/etc/keepalived/keepalived.conf

三、RS准备工作

3.1 手工在RS端绑定lo网卡及抑制ARP

在RS上配置VIP,切记(DR模式)不要忘了在RS配置VIP,要不然数据包会被丢弃

[root@localhost ~]# ifconfig lo:0 10.1.0.5/32 up

[root@localhost ~]# ifconfig lo:0

3.2 添加路由

[root@localhost ~]# route add -host 10.1.0.5 dev lo

[root@localhost ~]# route -n | grep 10.1.0.5

10.1.0.5 0.0.0.0 255.255.255.255 UH 0 0 0 lo

3.3 手工在RS端抑制ARP响应

echo "1" > /proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2" > /proc/sys/net/ipv4/conf/lo/arp_announce

echo "1" > /proc/sys/net/ipv4/conf/all/arp_ignore

echo "2" > /proc/sys/net/ipv4/conf/all/arp_announce

四、配置Keepalived主备

4.1 仅实现LVS负载均衡器主和备的keepalived高可用功能

配置文件位置: /etc/keepalived/keepalived.conf

LVS负载均衡器主的keepalived配置文件内容如下

主节点配置:

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 192.168.200.1

smtp_connect_timeout 30

router_id LVS_DEVEL

vrrp_skip_check_adv_addr

vrrp_garp_interval 0

vrrp_gna_interval 0

}

vrrp_instance VI_1 {

state MASTER

interface enp0s8

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

10.1.0.5/32 dev enp0s8 label enp0s8:0

}

}

virtual_server 10.1.0.5 80 {

delay_loop 6

lb_algo rr

lb_kind DR

persistence_timeout 50

protocol TCP

real_server 10.1.0.9 80 {

weight 1

TCP_CHECK {

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

real_server 10.1.0.10 80 {

weight 1

TCP_CHECK {

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

}

从节点配置: 复制一份修改好的配置到从主机,修改 1、state BACKUP,2、priority 50

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 192.168.200.1

smtp_connect_timeout 30

router_id LVS_DEVEL

vrrp_skip_check_adv_addr

vrrp_garp_interval 0

vrrp_gna_interval 0

}

vrrp_instance VI_1 {

state BACKUP

interface enp0s8

virtual_router_id 51

priority 50

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

10.1.0.5/32 dev enp0s8 label enp0s8:0

}

}

virtual_server 10.1.0.5 80 {

delay_loop 6

lb_algo rr

lb_kind DR

persistence_timeout 50

protocol TCP

real_server 10.1.0.9 80 {

weight 1

TCP_CHECK {

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

real_server 10.1.0.10 80 {

weight 1

TCP_CHECK {

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

}

五、 启动LVS主和备的keepalived服务

在LVS主上启动keepalived

[root@lvs01 ~]# systemctl restart keepalived.service

[root@lvs01 ~]# ifconfig

enp0s8: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 10.1.0.8 netmask 255.255.0.0 broadcast 10.1.255.255

inet6 fe80::f11:ab84:820d:2dcb prefixlen 64 scopeid 0x20<link>

inet6 fe80::db6e:9a5d:7349:6075 prefixlen 64 scopeid 0x20<link>

inet6 fe80::3d8e:d53:d823:a85c prefixlen 64 scopeid 0x20<link>

ether 08:00:27:b8:e6:5d txqueuelen 1000 (Ethernet)

RX packets 2043 bytes 234694 (229.1 KiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 1724 bytes 177199 (173.0 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

enp0s8:0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 10.1.0.5 netmask 255.255.255.255 broadcast 0.0.0.0

ether 08:00:27:b8:e6:5d txqueuelen 1000 (Ethernet)

# 启动keepalived就自动配置好了

[root@localhost ~]# ipvsadm -Ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.1.0.5:80 rr persistent 50

-> 10.1.0.9:80 Route 1 0 0

-> 10.1.0.10:80 Route 1 0 0

可以看到,主LVS上,enp0s8:0网卡,自动绑定了一个虚拟IP,10.1.0.5

在LVS副上启动keepalived

enp0s8: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 10.1.0.7 netmask 255.255.0.0 broadcast 10.1.255.255

inet6 fe80::3d8e:d53:d823:a85c prefixlen 64 scopeid 0x20<link>

inet6 fe80::f11:ab84:820d:2dcb prefixlen 64 scopeid 0x20<link>

inet6 fe80::db6e:9a5d:7349:6075 prefixlen 64 scopeid 0x20<link>

ether 08:00:27:00:ea:f9 txqueuelen 1000 (Ethernet)

RX packets 2168 bytes 255588 (249.5 KiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 2242 bytes 214656 (209.6 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

可以看到,在LVS副上,并没有新建enp0s8:0的虚拟IP

如果LVS副上没有VIP就对了。如果主副都有,那么请检查防火墙是否开启状态

如果主副两台机器网络不通的情况,就会有两个VIP都绑定了,这是有问题的,就是“脑裂”

六、 内网客户端进行访问测试

在内网客户端上进行访问测试,可以发现请求到了后端

[root@localhost ~]# curl -X GET http://10.1.0.5

<!DOCTYPE html>

<html>

<head>

<title>Welcome to nginx!</title>

<style>

html { color-scheme: light dark; }

body { width: 35em; margin: 0 auto;

font-family: Tahoma, Verdana, Arial, sans-serif; }

</style>

</head>

<body>

<h1>10.1.0.9 </h1>

</body>

</html>

在LVS主上停掉keepalived服务,LVS副,自动升级为主

LVS主

[root@localhost ~]# systemctl stop keepalived.service

[root@localhost ~]# ifconfig | grep enp0s8:0

#这时候没有VIP了

[root@localhost ~]# ip a | grep enp0s8:0

enp0s8:0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 10.1.0.5 netmask 255.255.255.255 broadcast 0.0.0.0

ether 08:00:27:00:ea:f9 txqueuelen 1000 (Ethernet)

curl -X GET http://10.1.0.5:80

[root@localhost ~]# ipvsadm -Lnc

IPVS connection entries

pro expire state source virtual destination

TCP 01:38 FIN_WAIT 10.1.0.1:50297 10.1.0.5:80 10.1.0.10:80

TCP 00:28 NONE 10.1.0.1:0 10.1.0.5:80 10.1.0.10:80

[root@lvs01 ~]# systemctl start keepalived.service

[root@lvs01 ~]# ip a | grep eth0:240

inet 192.168.0.240/24 scope global secondary eth0:240

[root@localhost ~]# ifconfig

# 启动LVS主,但是主并没有升级,还是作为副存在,这是什么原因

综上,至此基于LVS的keepalived高可用功能实验完毕

七、 通过Keepalived对LVS进行管理的功能实现

[root@lvs01 ~]# cat /etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

notification_email {

215379068@qq.com

}

notification_email_from yunjisuan

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id LVS01

}

vrrp_instance VI_1 {

state MASTER

interface eth0

virtual_router_id 55

priority 150

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.0.240/24 dev eth0 label eth0:240

}

}

virtual_server 192.168.0.240 80 { #虚拟主机VIP

delay_loop 6 #

lb_algo rr #算法

lb_kind DR #模式

nat_mask 255.255.255.0 #掩码

# persistence_timeout 50 #会话保持

protocol TCP #协议

real_server 192.168.0.223 80 { #RS节点

weight 1 #权重

TCP_CHECK { #节点健康检查

connect_timeout 8 #延迟超时时间

nb_get_retry 3 #重试次数

delay_before_retry 3 #延迟重试次数

connect_port 80 #利用80端口检查

}

}

real_server 192.168.0.224 80 { #RS节点

weight 1

TCP_CHECK {

connect_timeout 8

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

}

以上keepalived配置文件在LVS主和备上都进行修改。

然后在lvs服务器上通过ipvsadm -C清除之前设置的规则

[root@lvs01 ~]# /etc/init.d/keepalived stop #关闭主LVS的keepalived服务

Stopping keepalived: [ OK ]

[root@lvs01 ~]# ipvsadm -Ln #没有ipvs规则

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

[root@lvs01 ~]# ip a | grep 240 #没有VIP

[root@lvs01 ~]# /etc/init.d/keepalived start #启动keepalived服务

Starting keepalived: [ OK ]

[root@lvs01 ~]# ipvsadm -Ln #出现ipvs规则

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.0.240:80 rr

-> 192.168.0.223:80 Route 1 0 0

-> 192.168.0.224:80 Route 1 0 0

[root@lvs01 ~]# ip a | grep 240 #出现VIP

inet 192.168.0.240/24 scope global secondary eth0:240

附录:LVS集群分发请求RS不均衡生产环境实战解决

生产环境中ipvsadm -L -n 发现两台RS的负载不均衡,一台有很多请求,一台没有。并且没有请求的那台RS经测试服务正常,lo:VIP也有。但是就是没有请求。

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.0.240:80 rr persistent 10

-> 192.168.0.223:80 Route 1 0 0

-> 192.168.0.224:80 Route 1 8 12758

问题原因:

persistent 10的原因,persistent会话保持,当clientA访问网站的时候,LVS把请求分发给了52,那么以后clientA再点击的其他操作其他请求,也会发送给52这台机器。

解决办法:

到keepalived中注释掉persistent 10 然后/etc/init.d/keepalived reload,然后可以看到以后负载均衡两边都均衡了。

其他导致负载不均衡的原因可能有:

- LVS自身的会话保持参数设置(-p 300,persistent 300)。优化:大公司尽量用cookies替代session

- LVS调度算法设置,例如:rr,wrr,wlc,lc算法

- 后端RS节点的会话保持参数,例如:apache的keepalive参数

- 访问量较少的情况,不均衡的现象更加明显

- 用户发送得请求时间长短,和请求资源多少大小。

LVS配置文件说明

! Configuration File for keepalived

global_defs { #全局定义部分

notification_email { #设置报警邮件地址,可设置多个

acassen@firewall.loc #接收通知的邮件地址

}

notification_email_from test0@163.com #设置 发送邮件通知的地址

smtp_server smtp.163.com #设置 smtp server 地址,可是ip或域名.可选端口号 (默认25)

smtp_connect_timeout 30 #设置 连接 smtp server的超时时间

router_id LVS_DEVEL #主机标识,用于邮件通知

vrrp_skip_check_adv_addr

vrrp_strict #严格执行VRRP协议规范,此模式不支持节点单播

vrrp_garp_interval 0

vrrp_gna_interval 0

script_user keepalived_script #指定运行脚本的用户名和组。默认使用用户的默认组。如未指定,默认为keepalived_script 用户,如无此用户,则使用root

enable_script_security #如过路径为非root可写,不要配置脚本为root用户执行。

}

vrrp_script chk_nginx_service { #VRRP 脚本声明

script "/etc/keepalived/chk_nginx.sh" #周期性执行的脚本

interval 3 #运行脚本的间隔时间,秒

weight -20 #权重,priority值减去此值要小于备服务的priority值

fall 3 #检测几次失败才为失败,整数

rise 2 #检测几次状态为正常的,才确认正常,整数

user keepalived_script #执行脚本的用户或组

}

vrrp_instance VI_1 { #vrrp 实例部分定义,VI_1自定义名称

state MASTER #指定 keepalived 的角色,必须大写 可选值:MASTER|BACKUP

interface ens33 #网卡设置,lvs需要绑定在网卡上,realserver绑定在回环口。区别:lvs对访问为外,realserver为内不易暴露本机信息

virtual_router_id 51 #虚拟路由标识,是一个数字,同一个vrrp 实例使用唯一的标识,MASTER和BACKUP 的 同一个 vrrp_instance 下 这个标识必须保持一致

priority 100 #定义优先级,数字越大,优先级越高。

advert_int 1 #设定 MASTER 与 BACKUP 负载均衡之间同步检查的时间间隔,单位为秒,两个节点设置必须一样

authentication { #设置验证类型和密码,两个节点必须一致

auth_type PASS

auth_pass 1111

}

virtual_ipaddress { #设置虚拟IP地址,可以设置多个虚拟IP地址,每行一个

192.168.119.130

}

track_script { #脚本监控状态

chk_nginx_service #可加权重,但会覆盖声明的脚本权重值。chk_nginx_service weight -20

}

notify_master "/etc/keepalived/start_haproxy.sh start" #当前节点成为master时,通知脚本执行任务

notify_backup "/etc/keepalived/start_haproxy.sh stop" #当前节点成为backup时,通知脚本执行任务

notify_fault "/etc/keepalived/start_haproxy.sh stop" #当当前节点出现故障,执行的任务;

}

virtual_server 192.168.119.130 80 { #定义RealServer对应的VIP及服务端口,IP和端口之间用空格隔开

delay_loop 6 #每隔6秒查询realserver状态

lb_algo rr #后端调试算法(load balancing algorithm)

lb_kind DR #LVS调度类型NAT/DR/TUN

#persistence_timeout 60 同一IP的连接60秒内被分配到同一台realserver

protocol TCP #用TCP协议检查realserver状态

real_server 192.168.119.120 80 {

weight 1 #权重,最大越高,lvs就越优先访问

TCP_CHECK { #keepalived的健康检查方式HTTP_GET | SSL_GET | TCP_CHECK | SMTP_CHECK | MISC

connect_timeout 10 #10秒无响应超时

retry 3 #重连次数3次

delay_before_retry 3 #重连间隔时间

connect_port 80 #健康检查realserver的端口

}

}

real_server 192.168.119.121 80 {

weight 1 #权重,最大越高,lvs就越优先访问

TCP_CHECK { #keepalived的健康检查方式HTTP_GET | SSL_GET | TCP_CHECK | SMTP_CHECK | MISC

connect_timeout 10 #10秒无响应超时

retry 3 #重连次数3次

delay_before_retry 3 #重连间隔时间

connect_port 80 #健康检查realserver的端口

}

}

}

vrrp_instance VI_2 { #vrrp 实例部分定义,VI_1自定义名称

state BACKUP #指定 keepalived 的角色,必须大写 可选值:MASTER|BACKUP 分别表示(主|备)

interface ens33 #网卡设置,绑定vip的子接口,lvs需要绑定在网卡上,realserver绑定在回环口。区别:lvs对访问为外,realserver为内不易暴露本机信息

virtual_router_id 52 #虚拟路由标识,是一个数字,同一个vrrp 实例使用唯一的标识,MASTER和BACKUP 的 同一个 vrrp_instance 下 这个标识必须保持一致

priority 90 #定义优先级,数字越大,优先级越高。

advert_int 1 #设定 MASTER 与 BACKUP 负载均衡之间同步检查的时间间隔,单位为秒,两个节点设置必须一样

authentication { #设置验证类型和密码,两个节点必须一致

auth_type PASS

auth_pass 1111

}

virtual_ipaddress { #设置虚拟IP地址,可以设置多个虚拟IP地址,每行一个

192.168.119.131

}

}

virtual_server 192.168.119.131 80 { #定义RealServer对应的VIP及服务端口,IP和端口之间用空格隔开

delay_loop 6 #每隔6秒查询realserver状态

lb_algo rr #后端调试算法(load balancing algorithm)

lb_kind DR #LVS调度类型NAT/DR/TUN

#persistence_timeout 60 #同一IP的连接60秒内被分配到同一台realserver

protocol TCP #用TCP协议检查realserver状态

real_server 192.168.119.120 80 {

weight 1 #权重,最大越高,lvs就越优先访问

TCP_CHECK { #keepalived的健康检查方式HTTP_GET | SSL_GET | TCP_CHECK | SMTP_CHECK | MISC

connect_timeout 10 #10秒无响应超时

retry 3 #重连次数3次

delay_before_retry 3 #重连间隔时间

connect_port 80 #健康检查realserver的端口

}

}

real_server 192.168.119.121 80 {

weight 1 #权重,最大越高,lvs就越优先访问

TCP_CHECK { #keepalived的健康检查方式HTTP_GET | SSL_GET | TCP_CHECK | SMTP_CHECK | MISC

connect_timeout 10 #10秒无响应超时

retry 3 #重连次数3次

delay_before_retry 3 #重连间隔时间

connect_port 80 #健康检查realserver的端口

}

}

}

原文地址:https://blog.csdn.net/suyuaidan/article/details/134253104

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_48846.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!