本文介绍: CART回归树算法详解+最优划分点选择例题详解

1、介绍

(1)简介

CART(Classification and Regression Trees)回归树是一种基于决策树的机器学习算法,用于预

测连续型目标变量而不是离散型类别变量。

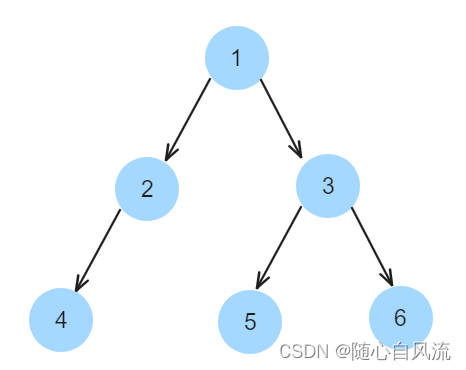

(2)生成过程

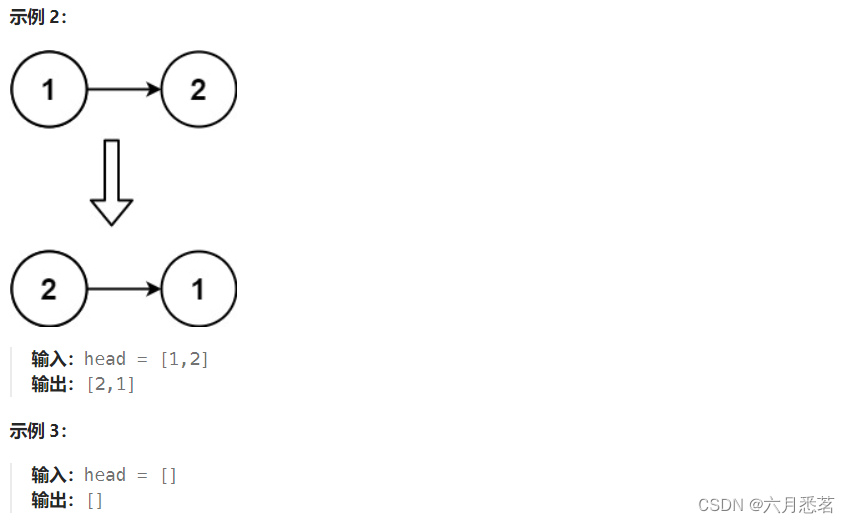

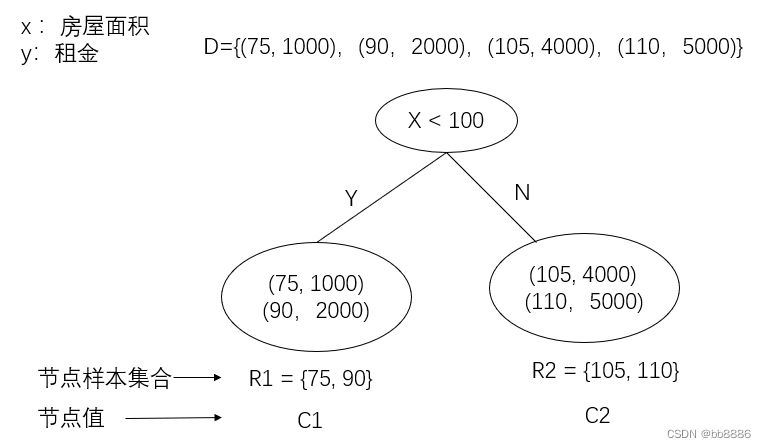

① 选择一个特征和相应的切分点,将数据集分为两个子集。

② 对每个子集递归地重复步骤1,直到满足停止条件。

③ 当达到停止条件时,叶节点的值可以是子集中目标变量的均值或其他统计量。

(3)示意图

(4)特点

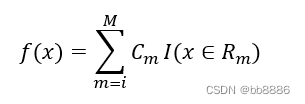

(5)回归树模型可表示为:

2、树如何构建?

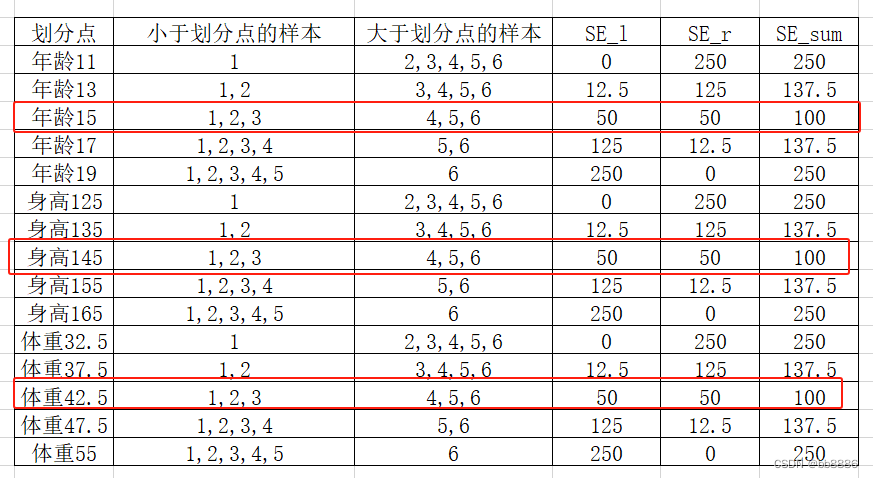

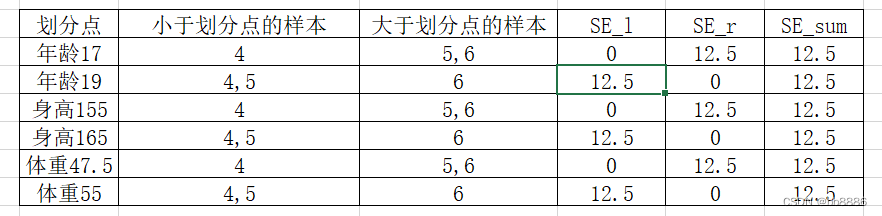

(1)划分节点如何选取–平方误差最小

(2)树的深度如何决定

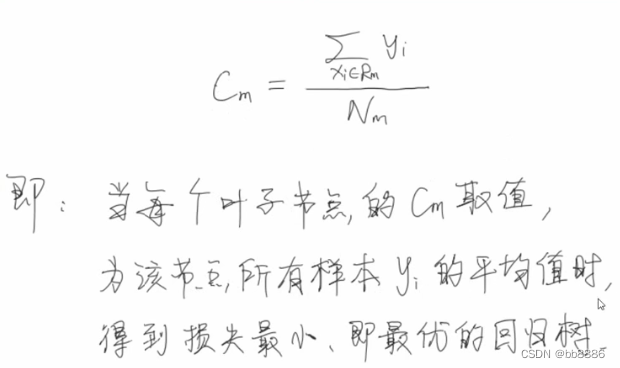

(3)叶子节点的值Cm如何定–取该节点所有样本yi的平均值。

3、损失函数

4、优化求解

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。