一、实验目的

掌握使用算能平台进行视频编码的流程,包括开发主机环境与云平台的配置,视频编码程序的编写与理解,代码的编译、运行以及学习使用码流分析工具分析视频压缩码流等。

二、实验内容

搭建实验开发环境,编译并运行编码程序,对视频文件进行编码。并学习利用ffprobe程序分析详细的封装格式和视频流信息,进一步学习利用码流软件Elecard StreamEye查看编码后视频码流文件。

三、开发环境

硬件:算能SE5

四、实验器材

五、实验过程与结论

FFMPEG编码原理与流程

FFMPEG是目前最为流行的视频编解码开源软件,大部分的音视频领域的开发者都会采用FFMPEG进行编解码。FFMPEG编解码软件不仅支持H264和H265编解码,还支持包括视频RTSP拉流、视频格式转换等功能。目前的OPENCV其内部的编解码部分也是采用FFMPEG进行视频编解码。算能平台也支持FFMPEG编解码接口,提供了和标准FFMPEG一样相对统一的编解码接口,只是在内部进行了硬件加速处理,相比开源FFMPEG实现更高效的视频编解码能力。以BM1684为例,支持最大支持1080P@960fps的H264解码和最大支持1080P@1000fps的H265解码。算能平台的FFMPEG简称BM-FFMPEG,在标准的FFMPEG上做了二次封装,其代码也实现开源,具体请参考https://gitee.com/sophon-ai/bm_ffmpeg

https://doc.sophgo.com/docs/2.7.0/docs_latest_release/multimedia_guide/Multimedia_User_Guide_zh.pdf

算能平台的bmnnsdk2中提供了相关的代码实例。具体见网址如下:

https://github.com/sophon-ai-algo/examples/tree/3.0.0/multimedia

下面,本实例以算能平台FFMPEG编码为例,介绍其使用方法。算能平台的FFMPEG编码流程和标准的FFMPEG编码流程一致,如下图所示:

根据上述流程,下面介绍本实例的关键代码如下:

包含相关头文件

由于涉及到ffmpeg相关编程,因此需要在工程中添加ffmpeg相关的头文件,具体如下:

#include <iostream>

extern "C" {

#include "libavcodec/avcodec.h"

#include "libswscale/swscale.h"

#include "libavutil/imgutils.h"

#include "libavformat/avformat.h"

#include "libavfilter/buffersink.h"

#include "libavfilter/buffersrc.h"

#include "libavutil/opt.h"

#include "libavutil/pixdesc.h"

}

#define STEP_ALIGNMENT 32主函数

为了使整个程序模块更为清晰,本实例在将ffmpeg编码器初始化与开启相关内容和编码写文件相关内容分别封装为2个独立的函数。然后在主线程中进行调用,具体如下:

int main(int argc, char **argv)

{

int soc_idx = 0;

int enc_id = AV_CODEC_ID_H264; //AV_CODEC_ID_H265

int inputformat = AV_PIX_FMT_YUV420P;

int framerate = 30;

int width = 1920;

int height = 1080;

int bitrate = 1000000; //bits per sencond

char *input_file = "1080p.yuv"; //input yuv file name

char *output_file= "test.mp4"; //output yuv file name

int ret;

av_log_set_level(AV_LOG_DEBUG); //set debug level

int stride = (width + STEP_ALIGNMENT - 1) & ~(STEP_ALIGNMENT - 1);

int aligned_input_size = stride * height*3/2;

// TODO

uint8_t *aligned_input = (uint8_t*)av_mallocz(aligned_input_size);

if (aligned_input==NULL) {

av_log(NULL, AV_LOG_ERROR, "av_mallocz failedn");

return -1;

}

FILE *in_file = fopen(input_file, "rb"); //Input raw YUV data

if (in_file == NULL) {

fprintf(stderr, "Failed to open input filen");

return -1;

}

bool isFileEnd = false;

VideoEnc_FFMPEG writer;

ret = writer.openEnc(output_file, soc_idx, enc_id, framerate , width, height, inputformat, bitrate);

if (ret !=0 ) {

av_log(NULL, AV_LOG_ERROR,"writer.openEnc failedn");

return -1;

}

//read raw data

while(1) {

for (int y = 0; y < height*3/2; y++) {

ret = fread(aligned_input + y*stride, 1, width, in_file);

if (ret < width) {

if (ferror(in_file))

av_log(NULL, AV_LOG_ERROR, "Failed to read raw data!n");

else if (feof(in_file))

av_log(NULL, AV_LOG_INFO, "The end of file!n");

isFileEnd = true;

break;

}

}

if (isFileEnd)

break;

writer.writeFrame(aligned_input, stride, width, height);

}

writer.closeEnc();

av_free(aligned_input);

fclose(in_file);

av_log(NULL, AV_LOG_INFO, "encode finish! n");

return 0;

}从上面代码可以发现,本实例创建了VideoEnc_FFMPEG类,然后在该结构体里进一步封装了openEnc方法和writeFrame方法,分别用于FFMPEG初始化和编码写文件操作。

VideoEnc_FFMPEG类定义如下:

class VideoEnc_FFMPEG

{

public:

VideoEnc_FFMPEG();

~VideoEnc_FFMPEG();

int openEnc(const char* filename, int soc_idx, int codecId, int framerate,

int width, int height,int inputformat,int bitrate);

void closeEnc();

int writeFrame(const uint8_t* data, int step, int width, int height);

int flush_encoder();

private:

AVFormatContext * ofmt_ctx;

AVCodecContext * enc_ctx;

AVFrame * picture;

AVFrame * input_picture;

AVStream * out_stream;

uint8_t * aligned_input;

int frame_width;

int frame_height;

int frame_idx;

AVCodec* find_hw_video_encoder(int codecId)

{

AVCodec *encoder = NULL;

switch (codecId)

{

case AV_CODEC_ID_H264:

encoder = avcodec_find_encoder_by_name("h264_bm");

break;

case AV_CODEC_ID_H265:

encoder = avcodec_find_encoder_by_name("h265_bm");

break;

default:

break;

}

return encoder;

}

};可以发现,这里面还定义了find_hw_video_encoder方法用于查找编码器。该方法调用了FFMPEG的avcodec_find_encoder_by_name函数,具体见上代码。

FFMPEG初始化

OpenEnc函数实现流程参考上图流程实现,用于完成FFMPEG编码器的初始化等操作:

int VideoEnc_FFMPEG::openEnc(const char* filename, int soc_idx, int codecId, int framerate, int width, int height, int inputformat, int bitrate)

{

int ret = 0;

AVCodec *encoder;

AVDictionary *dict = NULL;

frame_idx = 0;

frame_width = width;

frame_height = height;

avformat_alloc_output_context2(&ofmt_ctx, NULL, NULL, filename);

if (!ofmt_ctx) {

av_log(NULL, AV_LOG_ERROR, "Could not create output contextn");

return AVERROR_UNKNOWN;

}

encoder = find_hw_video_encoder(codecId);

if (!encoder) {

av_log(NULL, AV_LOG_FATAL, "hardware video encoder not foundn");

return AVERROR_INVALIDDATA;

}

enc_ctx = avcodec_alloc_context3(encoder);

if (!enc_ctx) {

av_log(NULL, AV_LOG_FATAL, "Failed to allocate the encoder contextn");

return AVERROR(ENOMEM);

}

//参数初始化

enc_ctx->codec_id = (AVCodecID)codecId;

enc_ctx->width = width;

enc_ctx->height = height;

enc_ctx->pix_fmt = (AVPixelFormat)inputformat;

enc_ctx->bit_rate_tolerance = bitrate;

enc_ctx->bit_rate = (int64_t)bitrate;

enc_ctx->gop_size = 32;

enc_ctx->time_base.num = 1;

enc_ctx->time_base.den = framerate;

enc_ctx->framerate.num = framerate;

enc_ctx->framerate.den = 1;

av_log(NULL, AV_LOG_DEBUG, "enc_ctx->bit_rate = %ldn", enc_ctx->bit_rate);

out_stream = avformat_new_stream(ofmt_ctx, encoder);

out_stream->time_base = enc_ctx->time_base;

out_stream->avg_frame_rate = enc_ctx->framerate;

out_stream->r_frame_rate = out_stream->avg_frame_rate;

av_dict_set_int(&dict, "sophon_idx", soc_idx, 0);

av_dict_set_int(&dict, "gop_preset", 8, 0);

/* Use system memory */

av_dict_set_int(&dict, "is_dma_buffer", 0, 0);

av_dict_set_int(&dict, "qp", 25, 0);

/* Third parameter can be used to pass settings to encoder */

ret = avcodec_open2(enc_ctx, encoder, &dict);

if (ret < 0) {

av_log(NULL, AV_LOG_ERROR, "Cannot open video encoder ");

return ret;

}

ret = avcodec_parameters_from_context(out_stream->codecpar, enc_ctx);

if (ret < 0) {

av_log(NULL, AV_LOG_ERROR, "Failed to copy encoder paras to output stream ");

return ret;

}

if (!(ofmt_ctx->oformat->flags & AVFMT_NOFILE)) {

ret = avio_open(&ofmt_ctx->pb, filename, AVIO_FLAG_WRITE);

if (ret < 0) {

av_log(NULL, AV_LOG_ERROR, "Could not open output file '%s'", filename);

return ret;

}

}

/* init muxer, write output file header */

ret = avformat_write_header(ofmt_ctx, NULL);

if (ret < 0) {

av_log(NULL, AV_LOG_ERROR, "Error occurred when opening output filen");

return ret;

}

picture = av_frame_alloc();

picture->format = enc_ctx->pix_fmt;

picture->width = width;

picture->height = height;

return 0;

}编码与写文件

writeFrame函数用于实现将读取的YUV数据进行编码后写入文件,参考如下:

int VideoEnc_FFMPEG::writeFrame(const uint8_t* data, int step, int width, int height)

{

int ret = 0 ;

int got_output = 0;

if (step % STEP_ALIGNMENT != 0) {

av_log(NULL, AV_LOG_ERROR, "input step must align with STEP_ALIGNMENTn");

return -1;

}

static unsigned int frame_nums = 0;

frame_nums++;

av_image_fill_arrays(picture->data, picture->linesize, (uint8_t *) data, enc_ctx->pix_fmt, width, height, 1);

picture->linesize[0] = step;

picture->pts = frame_idx;

frame_idx++;

av_log(NULL, AV_LOG_DEBUG, "Encoding framen");

/* encode filtered frame */

AVPacket enc_pkt;

enc_pkt.data = NULL;

enc_pkt.size = 0;

av_init_packet(&enc_pkt);

ret = avcodec_encode_video2(enc_ctx, &enc_pkt, picture, &got_output);

if (ret < 0)

return ret;

if (got_output == 0) {

av_log(NULL, AV_LOG_WARNING, "No output from encodern");

return -1;

}

/* prepare packet for muxing */

av_log(NULL, AV_LOG_DEBUG, "enc_pkt.pts=%ld, enc_pkt.dts=%ldn",

enc_pkt.pts, enc_pkt.dts);

av_packet_rescale_ts(&enc_pkt, enc_ctx->time_base,out_stream->time_base);

av_log(NULL, AV_LOG_DEBUG, "rescaled enc_pkt.pts=%ld, enc_pkt.dts=%ldn",

enc_pkt.pts,enc_pkt.dts);

av_log(NULL, AV_LOG_DEBUG, "Muxing framen");

/* mux encoded frame */

ret = av_interleaved_write_frame(ofmt_ctx, &enc_pkt);

return ret;

}释放资源结束编码

void VideoEnc_FFMPEG::closeEnc()

{

flush_encoder();

av_write_trailer(ofmt_ctx);

av_frame_free(&picture);

if (input_picture)

av_free(input_picture);

avcodec_free_context(&enc_ctx);

if (ofmt_ctx && !(ofmt_ctx->oformat->flags & AVFMT_NOFILE))

avio_closep(&ofmt_ctx->pb);

avformat_free_context(ofmt_ctx);

} 从上述代码可以发现,结束编码前需要执行flush_encoder()函数,该函数用于向文件中写入最后一帧:

int VideoEnc_FFMPEG::flush_encoder()

{

int ret;

int got_frame = 0;

if (!(enc_ctx->codec->capabilities & AV_CODEC_CAP_DELAY))

return 0;

while (1) {

av_log(NULL, AV_LOG_INFO, "Flushing video encodern");

AVPacket enc_pkt;

enc_pkt.data = NULL;

enc_pkt.size = 0;

av_init_packet(&enc_pkt);

ret = avcodec_encode_video2(enc_ctx, &enc_pkt, NULL, &got_frame);

if (ret < 0)

return ret;

if (!got_frame)

break;

/* prepare packet for muxing */

av_log(NULL, AV_LOG_DEBUG, "enc_pkt.pts=%ld, enc_pkt.dts=%ldn",

enc_pkt.pts,enc_pkt.dts);

av_packet_rescale_ts(&enc_pkt, enc_ctx->time_base,out_stream->time_base);

av_log(NULL, AV_LOG_DEBUG, "rescaled enc_pkt.pts=%ld, enc_pkt.dts=%ldn",

enc_pkt.pts,enc_pkt.dts);

/* mux encoded frame */

av_log(NULL, AV_LOG_DEBUG, "Muxing framen");

ret = av_interleaved_write_frame(ofmt_ctx, &enc_pkt);

if (ret < 0)

break;

}

return ret;

}编码实验过程

makefile的写法与前面的例程基本相同,如果是在云平台上测试,则可将编译好的执行文件通过云空间文件系统上传。

运行指令

生成并上传编译文件后,根据如下指令在目标开发机终端运行,其中具体的指令参数设置将在下面详细介绍。

root@d11ae417e206:/tmp/test# ./ffmpeg_encode 1080.yuv output.h264

运行结果如下

[88a79010] src/enc.c:262 (vpu_EncInit) SOC index 0, VPU core index 4

[7f88a79010] src/vdi.c:137 (bm_vdi_init) [VDI] Open device /dev/vpu, fd=5

[7f88a79010] src/vdi.c:229 (bm_vdi_init) [VDI] success to init driver

[88a79010] src/common.c:108 (find_firmware_path) vpu firmware path: /system/lib/vpu_firmware/chagall.bin

[7f88a79010] src/vdi.c:137 (bm_vdi_init) [VDI] Open device /dev/vpu, fd=5

[7f88a79010] src/vdi.c:229 (bm_vdi_init) [VDI] success to init driver

[88a79010] src/enc.c:1326 (vpu_InitWithBitcode) reload firmware…

[88a79010] src/enc.c:2461 (Wave5VpuInit)

VPU INIT Start!!!

[88a79010] src/enc.c:306 (vpu_EncInit) VPU Firmware is successfully loaded!

[88a79010] src/enc.c:310 (vpu_EncInit) VPU FW VERSION=0x0,

REVISION=250327

[h265_bm @ 0x42aa90] width : 1920

[h265_bm @ 0x42aa90] height : 1080

[h265_bm @ 0x42aa90] pix_fmt : yuv420p

[h265_bm @ 0x42aa90] sophon device: 0

The end of file!

Flushing video encoder

Flushing video encoder

Flushing video encoder

Flushing video encoder

Flushing video encoder

Flushing video encoder

Flushing video encoder

Flushing video encoder

这里需要注意的是,可以通过av_log_set_level设置LOG的打印级别,以观察更多的调试信息:

使用ffprobe程序分析码流

媒体信息解析器ffprobe程序是FFmpeg提供的媒体信息检测工具。使用ffprobe不仅可以检测音视频文件的整体封装格式,还可以分析其中每一路音频流或者视频流信息,甚至可以进一步分析音视频流的每一个码流包或图像帧的信息。ffprobe的基本使用方法非常简单,直接使用参数-i加上要分析的文件即可。

查看封装格式指令

ffprobe -show_format -i test.mp4注:使用参数-i,输入要分析的文件。添加参数–show_format,即可显示音视频文件更详细的封装格式信息。

封装格式信息:

[FORMAT]

filename=C:UsersczeDownloadstest.mp4//输入文件名

nb_streams=1//输入包含多少路媒体流

format_name=mov,mp4,m4a,3gp,3g2,mj2//封装模块名称

format_long_name=QuickTime / MOV//封装模块全称

start_time=0.000000//输入媒体文件的起始时间

duration=3.334000//输入媒体文件的总时长

size=483666//输入文件大小

bit_rate=1160566//总体码率

TAG:major_brand=isom

TAG:major_brand=isom

TAG:compatible_brands=isomiso2mp41

TAG:encoder=Lavf58.20.100

[/FORMAT]

查看媒体流指令:

ffprobe -show_streams -i test.mp4注:一个音视频文件通常包括两路及以上的媒体流(如一路音频流和一路视频流)。使用参数-i,输入要分析的文件。添加参数-show_streams,即可显示每一路媒体流的具体信息。

视频流信息:

[STREAM]

index=0//媒体流序号

codec_name=hevc//编码器名称

codec_long_name=H.265 / HEVC (High Efficiency Video Coding)//编码器全称

profile=Main//编码档次

codec_tag_string=hev1

codec_tag=0x31766568

width=1920//视频图像的宽

height=1080//视频图像的高

coded_width=1920

coded_height=1080

film_grain=0

has_b_frames=3//每个I帧和P帧之间的B帧数量

sample_aspect_ratio=N/A//像素采样横纵比

display_aspect_ratio=N/A//画面显示横纵比

level=150//编码级别

refs=1

id=0x1

r_frame_rate=30/1//最小帧率

avg_frame_rate=303/10//平均帧率

start_time=0.000000//起始位置的实际时间

duration_ts=51200//以时间基为单位的总时长

duration=3.333333//当前流的实际时长

bit_rate=1156005//当前流的码率

max_bit_rate=N/A//当前流的最大码率

bits_per_raw_sample=N/A//当前流每个采样的位深

nb_frames=101//当前流包含的总帧数

extradata_size=99

DISPOSITION:default=1

DISPOSITION:dub=0

DISPOSITION:original=0

DISPOSITION:comment=0

DISPOSITION:lyrics=0

DISPOSITION:karaoke=0

DISPOSITION:forced=0

DISPOSITION:hearing_impaired=0

DISPOSITION:clean_effects=0

DISPOSITION:attached_pic=0

DISPOSITION:timed_thumbnails=0

DISPOSITION:captions=0

DISPOSITION:descriptions=0

DISPOSITION:metadata=0

DISPOSITION:dependent=0

DISPOSITION:still_image=0

TAG:language=und

TAG:handler_name=VideoHandler

TAG:vendor_id=[0][0][0][0]

[/STREAM]

注:在该实例中,此文件只包含一路视频流信息。

使用VLC播放

压缩后的文件无法直接播放,可以通过VLC进行播放,VLC在Ubuntu下可以直接通过下面方法进行安装:

sudo apt-get install vlc使用Elecard StreamEye软件分析码流

现有的码流分析软件众多,Elecard StreamEye Tools是一款分析视音频码流的工具,读者可自行去Elecard官网下载安装包。网址为:https://www.elecard.com/

下面以Elecard StreamEye Tools 中的Elecard StreamEye为例,对编码后的视频文件进行分析。

首先打开Elecard StreamEye软件,点击File,点击Open。即可打开选择的视频文件,播放视频文件。

Elecard StreamEye主界面为视频编码每一帧的信息,其中红色代表编码帧为I帧,绿色代表编码帧为P帧。

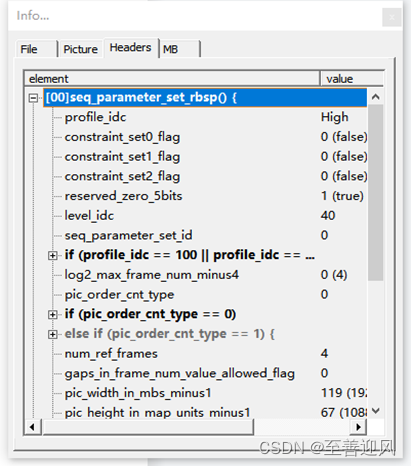

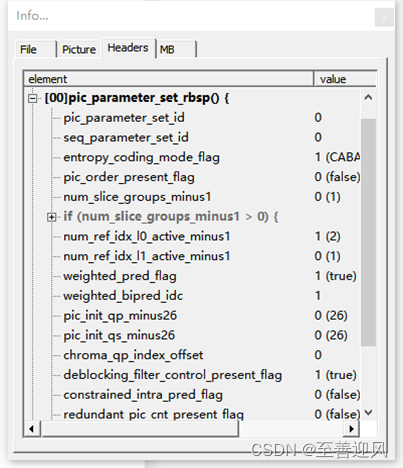

点击View,点击Info,即可查看视频流信息,选择Headers可以显示该视频流的SPS和PPS信息。

原文地址:https://blog.csdn.net/m0_52537869/article/details/134676038

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_5405.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!