本文介绍: UDF: 一对一UDAF: 多对一UDTF: 一对多spark sql原生python只能写udf, 借助pandas等第三方组件就可以写udf和udaf。

目录

一 . 开窗函数

二 . SparkSQL函数定义

1. HIVE_SQL用户自定义函数

2.Spark原生UDF

3. pandasUDF

4. pandasUDAF

三. Spark on HIVE

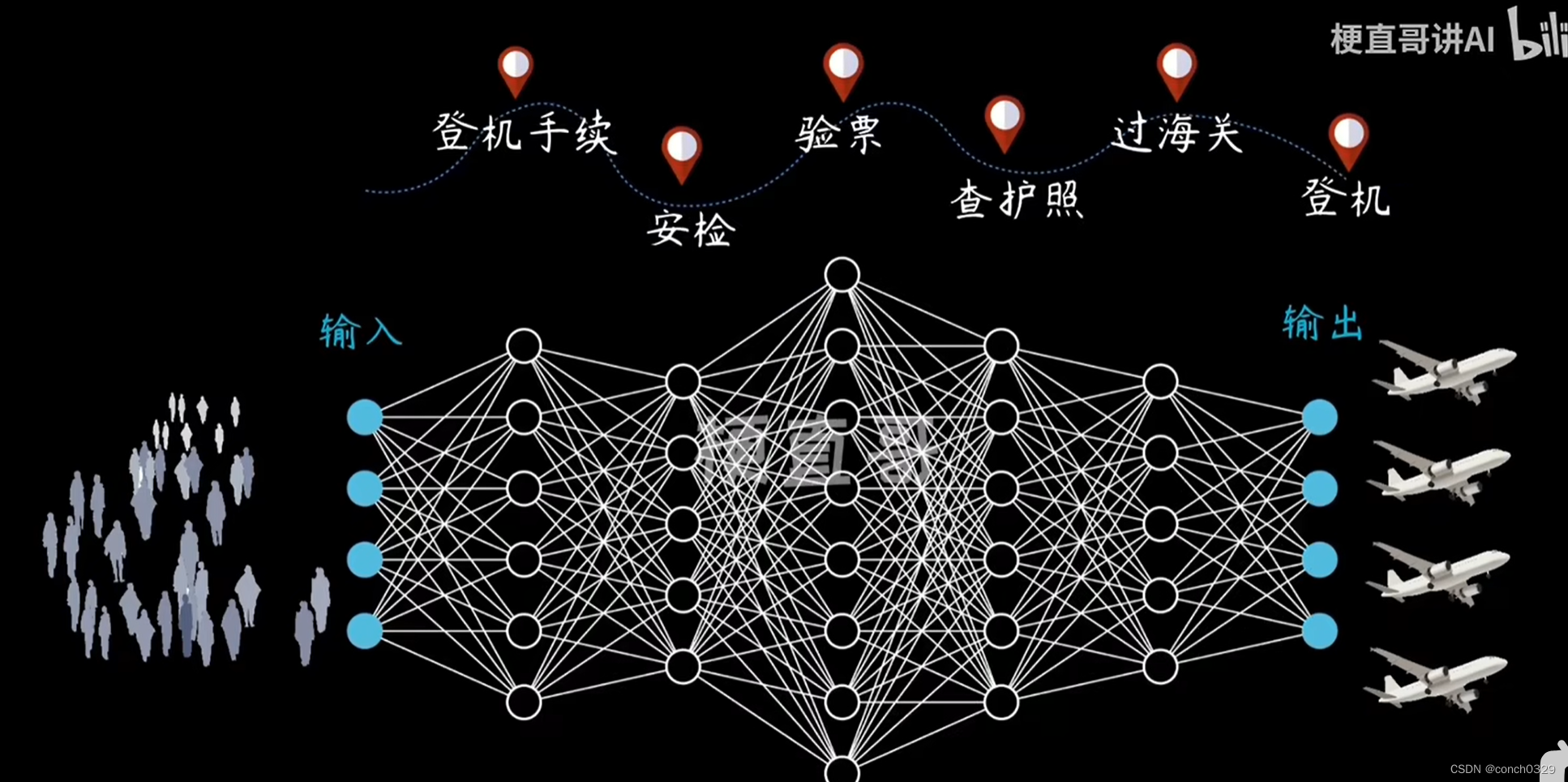

四.SparkSQL的执行流程

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。