本文介绍: 它的基本思想是将数据映射到高维空间中,使得数据在该空间中线性可分,然后在该空间中寻找最优的超平面,将不同类别的数据分开。在训练过程中,SVM会寻找最大间隔超平面,即距离支持向量最远的超平面。这样可以使得分类器的泛化能力更好,对新的数据具有更好的预测能力。如果你的数据来源于一个CSV文件中的很多条文本,你可以使用Python中的pandas库来读取CSV文件。SVM的优点在于可以处理高维数据,具有较好的泛化能力和鲁棒性。同时,SVM还可以使用核函数将数据映射到更高维的空间中,从而处理非线性问题。

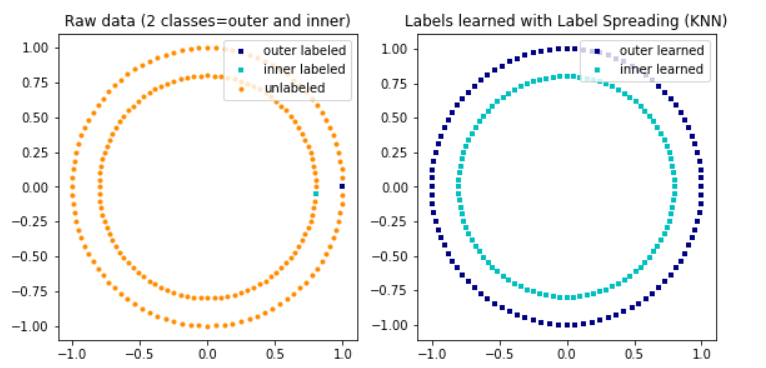

支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,主要用于分类和回归问题。它的基本思想是将数据映射到高维空间中,使得数据在该空间中线性可分,然后在该空间中寻找最优的超平面,将不同类别的数据分开。

SVM的优点在于可以处理高维数据,具有较好的泛化能力和鲁棒性。同时,SVM还可以使用核函数将数据映射到更高维的空间中,从而处理非线性问题。

SVM的核心是支持向量,即距离超平面最近的数据点。在训练过程中,SVM会寻找最大间隔超平面,即距离支持向量最远的超平面。这样可以使得分类器的泛化能力更好,对新的数据具有更好的预测能力。

SVM的训练过程可以使用优化算法来实现,例如序列最小优化(Sequential Minimal Optimization,SMO)算法。在实际应用中,SVM还可以使用软间隔和核函数等技术来处理噪声和非线性问题。

如果你的数据来源于一个CSV文件中的很多条文本,你可以使用Python中的pandas库来读取CSV文件 。CSV中数据格式示例如下,包含两个字段:text和label。第一行是字段名,后面的行是数据记录。每一行的字段值使用逗号进行分隔:

如果你的数据来源于一个txt文本中的很多句子,句子和标签之间用逗号分隔,示例如下:

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。