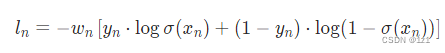

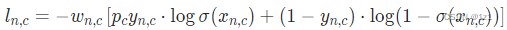

本文介绍: 如果我们在做多分类任务,有些类比较重要,有些类不太重要,想要模型更加关注重要的类别,那么只需将比较重要的类所对应的w权重设置大一点,不太重要的类所对应的w权重设置小一点。其中pos_weight对应上式公式中的p_c,这个参数是为了调节正负样本不均衡问题的,如果正负样本比是10:1,那么我们可以将p_c设置为1/10来平衡正负样本。上式是nn.BCEWithLogitsLoss损失函数的计算公式,其中w_n对应weight参数。

weight参数

上式是nn.BCEWithLogitsLoss损失函数的计算公式,其中w_n对应weight参数。

如果我们在做多分类任务,有些类比较重要,有些类不太重要,想要模型更加关注重要的类别,那么只需将比较重要的类所对应的w权重设置大一点,不太重要的类所对应的w权重设置小一点。

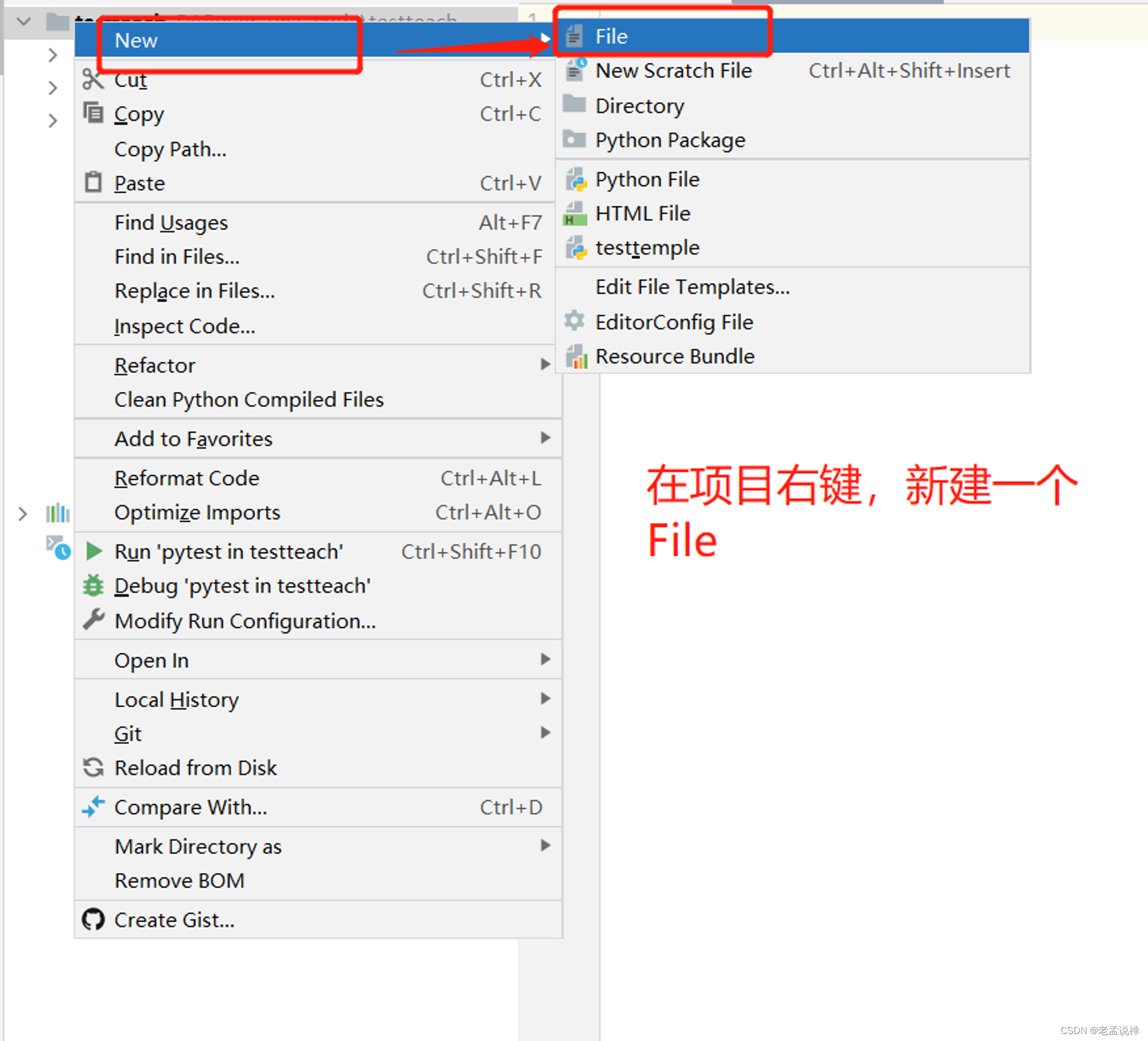

下面是一个代码演示:

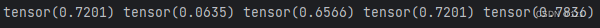

运行结果:

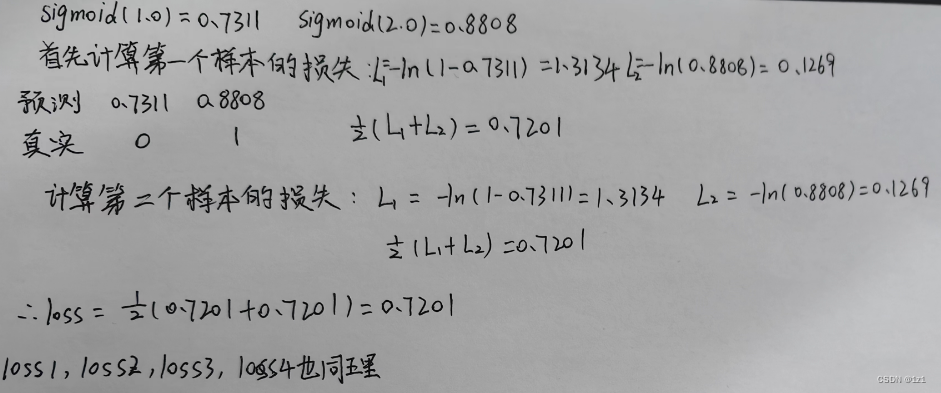

其中[1.0, 2.0]经过sigmoid层之后的值是[0.7311,0.8808]

对于loss的计算过程如下所示:

pos_weight参数

其中pos_weight对应上式公式中的p_c,这个参数是为了调节正负样本不均衡问题的,如果正负样本比是10:1,那么我们可以将p_c设置为1/10来平衡正负样本。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。