本文介绍: 决策树是广泛用于分类和回归任务的模型,本质上是从一层层if/else问题中进行学习,并得出结论。这些问题类似于“是不是”中可能问到的问题。

决策树是广泛用于分类和回归任务的模型,本质上是从一层层if/else问题中进行学习,并得出结论。这些问题类似于“是不是”中可能问到的问题。

决策树的每个结点代表一个问题或一个包含答案的终结点(叶结点)。树的边奖问题的答案与将问的下一个问题连接起来。

用机器学习的语言来说,,为了得到预测结果,利用多个特征构建一个模型,可以利用监督学习从数据中学习模型,而不需要人为构建模型。

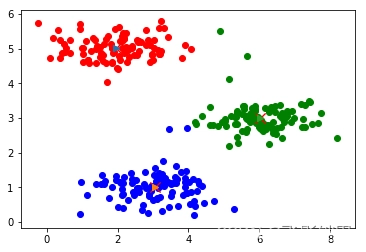

学习决策树,就是学习一系列if/else问题,使我们能够最快的速度得到正确答案。在机器学习中,这些问题就叫做测试。数据通常不具有二元特征(是/否),而是表现为连续特征。为了构造决策树,算法搜遍所有可能得测试,找到对目标变量来说信息量最大的一个。

顶结点(也叫根结点)表示整个数据集,包含属于类别0的所有点和类别1的所有点,通过测试的真假来对数据集进行区分。递归生成二元决策树,其中每个结点都包含一个测试。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。