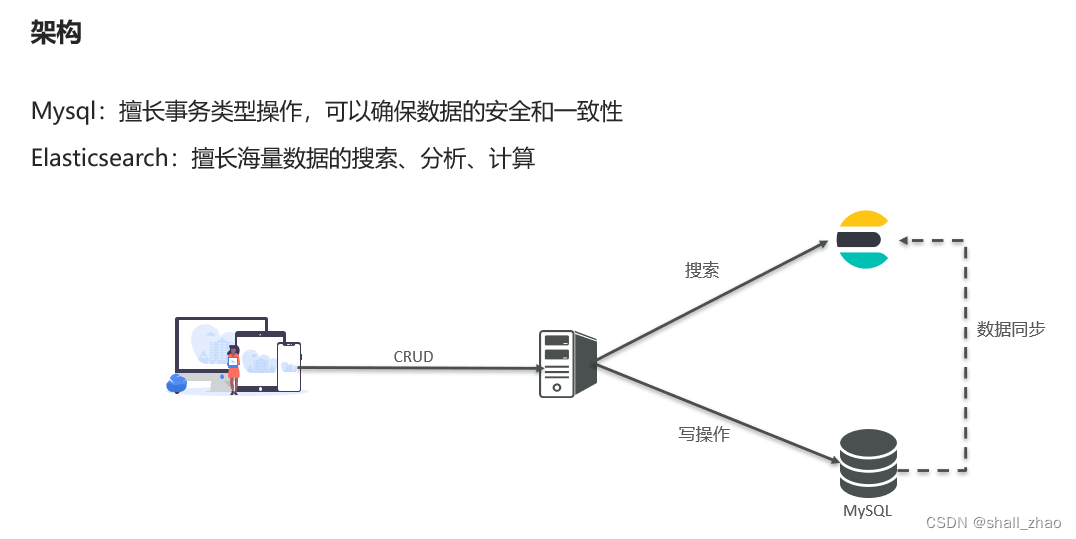

分布式搜索引擎ElasticSearch——基础

初识elasticsearch

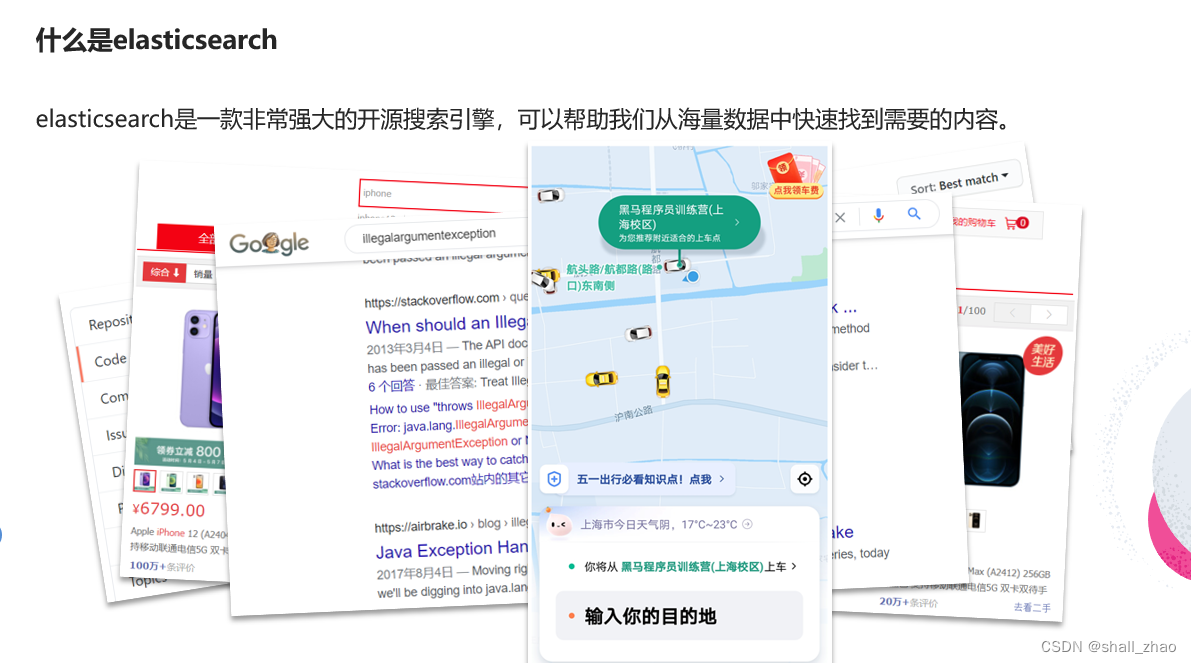

什么是elasticsearch

elasticsearch的发展

https://lucene.apache.org/

https://www.elastic.co/cn/

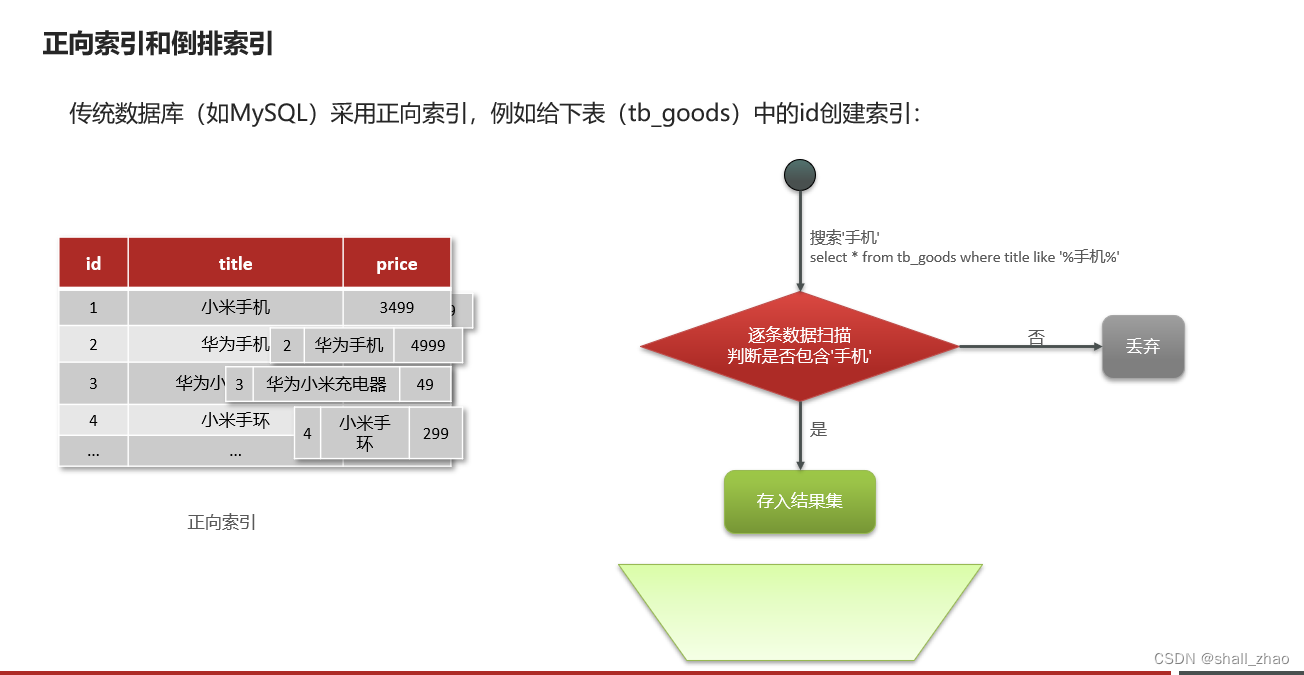

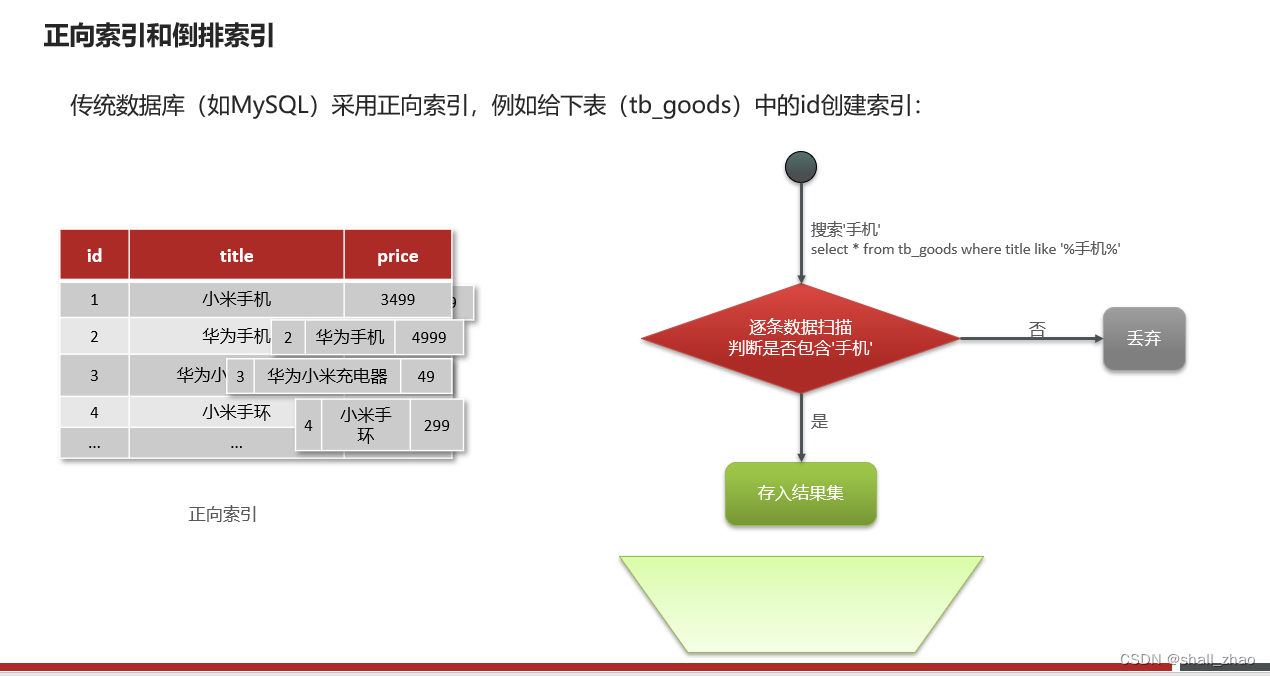

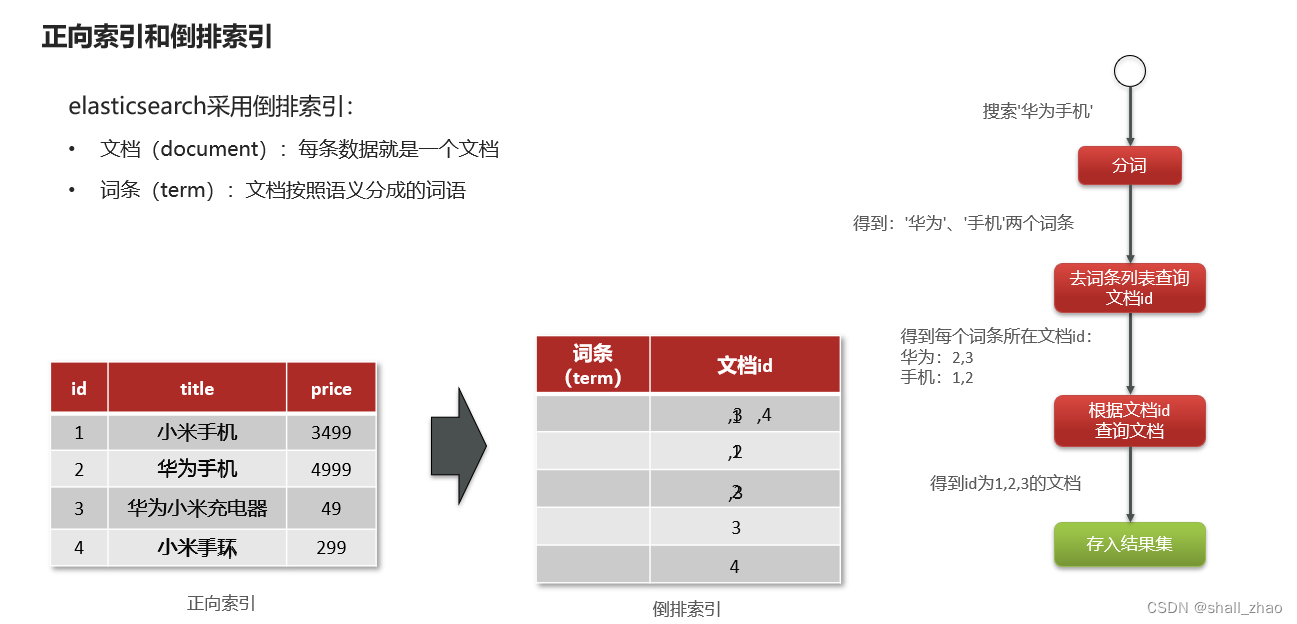

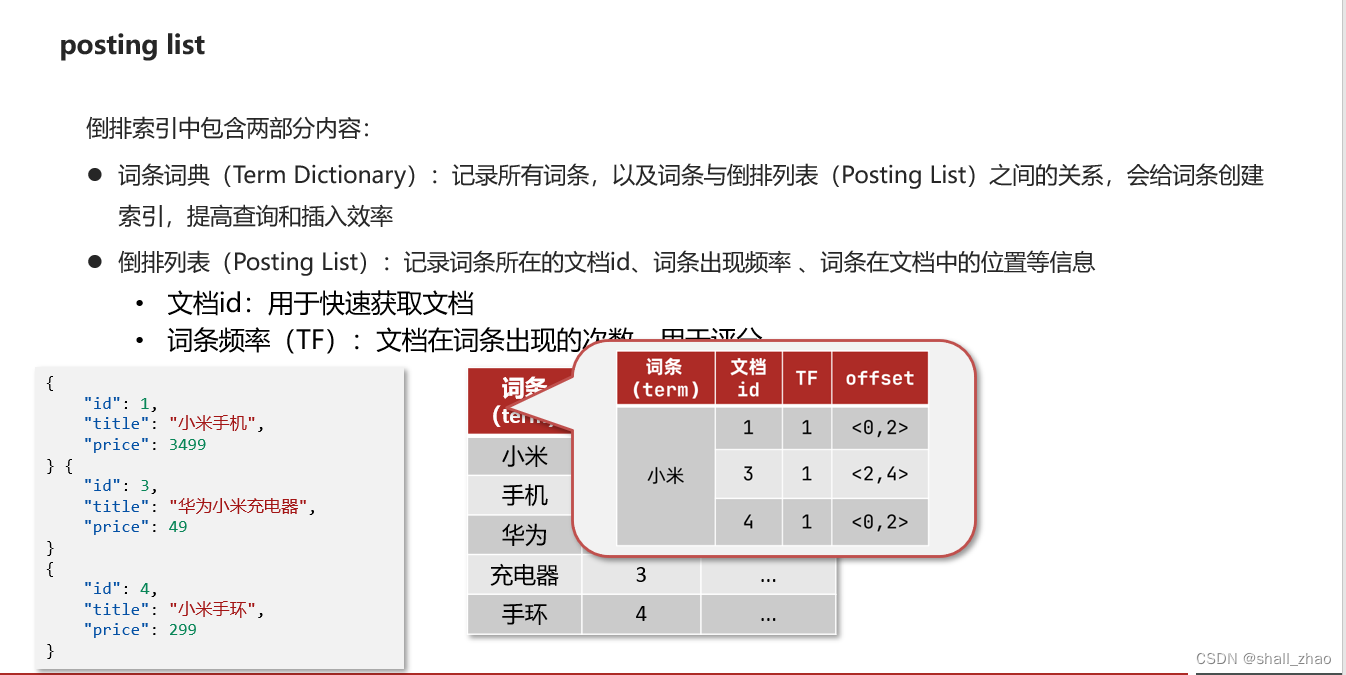

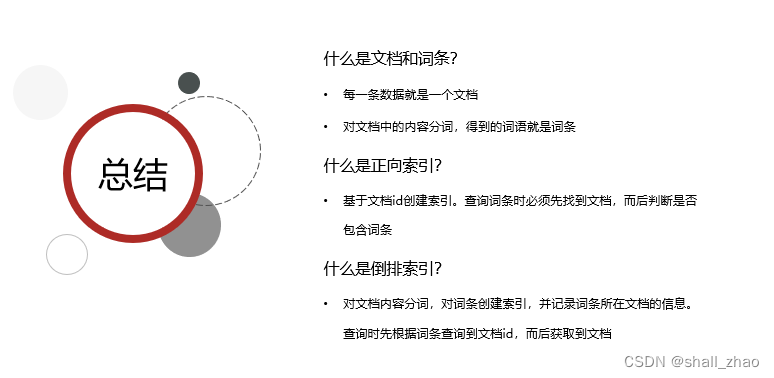

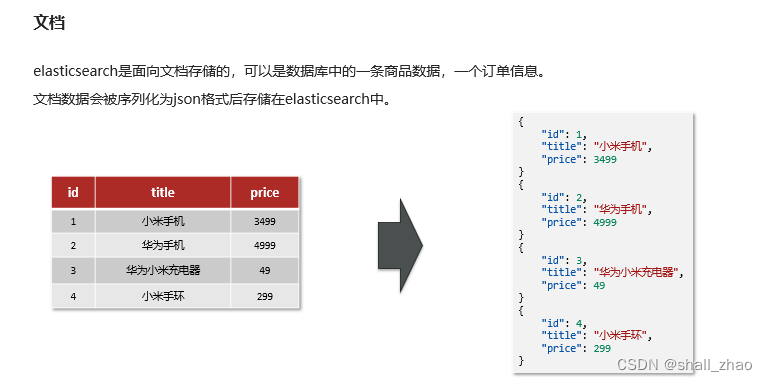

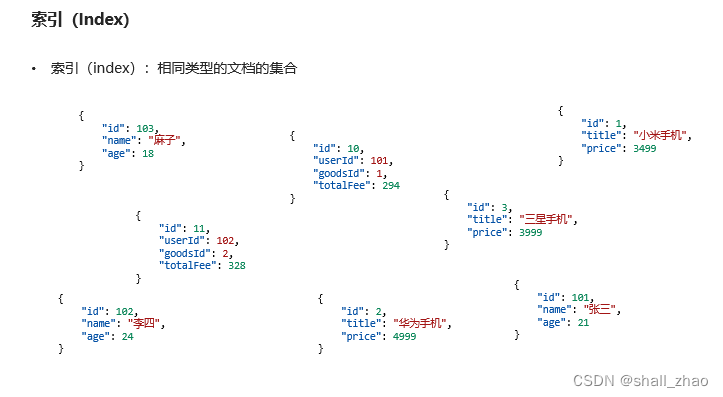

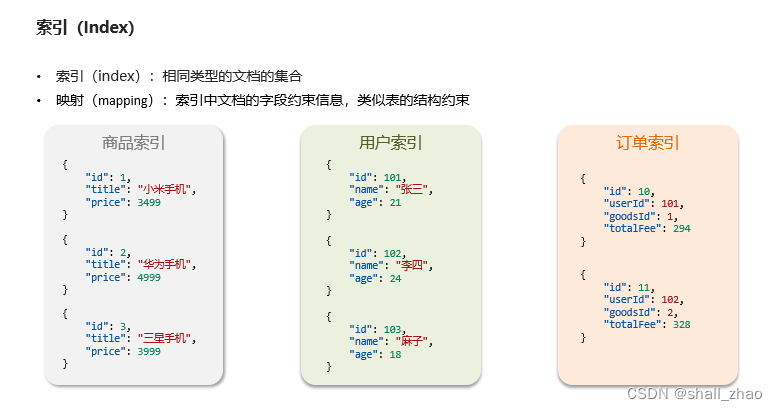

正向索引和倒排索引

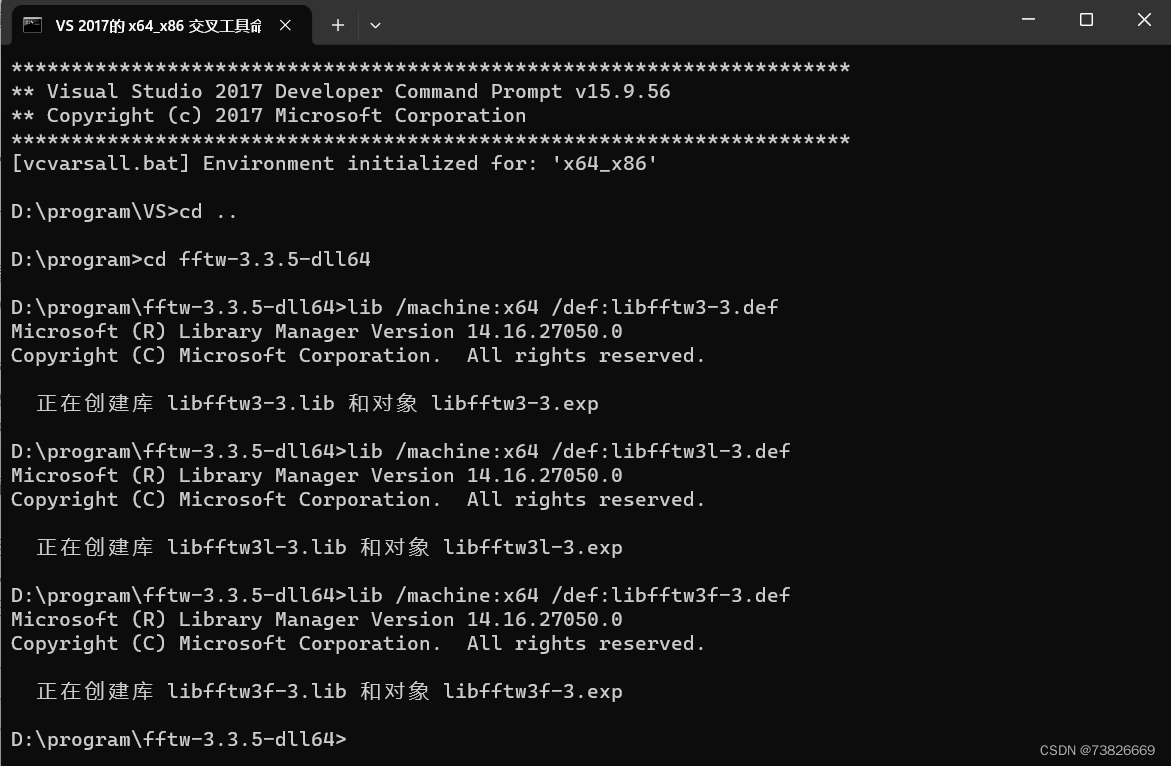

安装elasticsearch,kibana

https://github.com/medcl/elasticsearch-analysis-ik

部署单点es

创建网络

因为我们还需要部署kibana容器,因此需要让es和kibana容器互联。这里先创建一个网络:

docker network create es-net

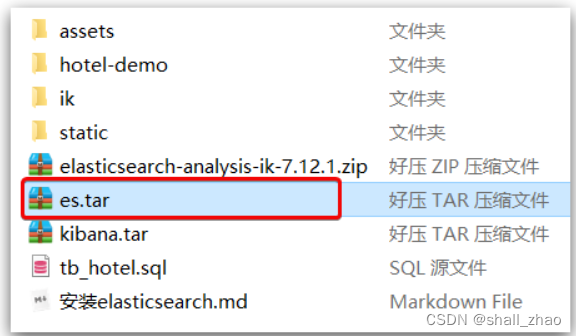

加载镜像

这里我们采用elasticsearch的7.12.1版本的镜像,这个镜像体积非常大,接近1G。不建议大家自己pull。网速没问题的话,直接去pull也没问题只要记得指定版本为7.12.1即可(学习教学方便)

课前资料提供了镜像的tar包:

大家将其上传到虚拟机中,然后运行命令加载即可:

# 导入数据

docker load -i es.tar

同理还有kibana的tar包也需要这样做。同理kibana也可以直接去pull

运行

运行docker命令,部署单点es:

docker run -d

--name es

-e "ES_JAVA_OPTS=-Xms512m -Xmx512m"

-e "discovery.type=single-node"

-v es-data:/usr/share/elasticsearch/data

-v es-plugins:/usr/share/elasticsearch/plugins

--privileged

--network es-net

-p 9200:9200

-p 9300:9300

elasticsearch:7.12.1

命令解释:

-e "cluster.name=es-docker-cluster":设置集群名称-e "http.host=0.0.0.0":监听的地址,可以外网访问-e "ES_JAVA_OPTS=-Xms512m -Xmx512m":内存大小-e "discovery.type=single-node":非集群模式-v es-data:/usr/share/elasticsearch/data:挂载逻辑卷,绑定es的数据目录-v es-logs:/usr/share/elasticsearch/logs:挂载逻辑卷,绑定es的日志目录-v es-plugins:/usr/share/elasticsearch/plugins:挂载逻辑卷,绑定es的插件目录--privileged:授予逻辑卷访问权--network es-net:加入一个名为es-net的网络中-p 9200:9200:端口映射配置

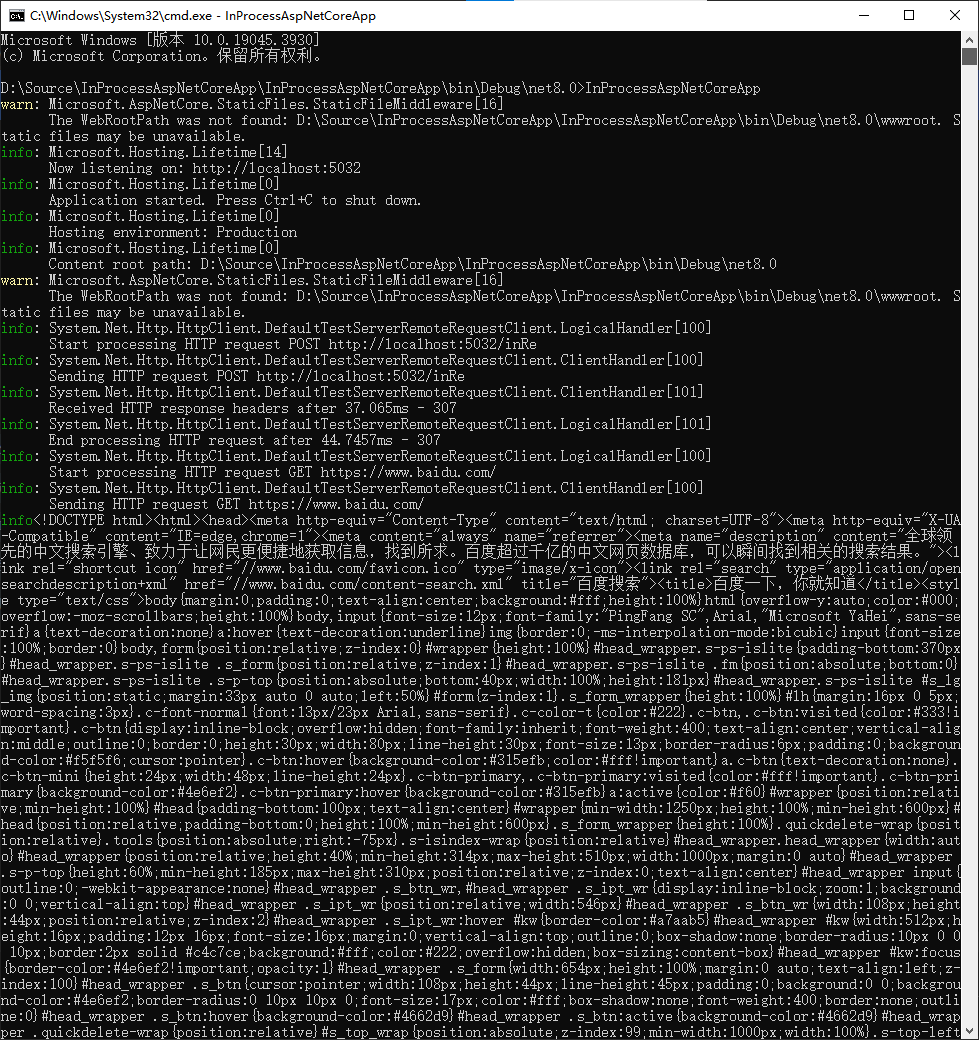

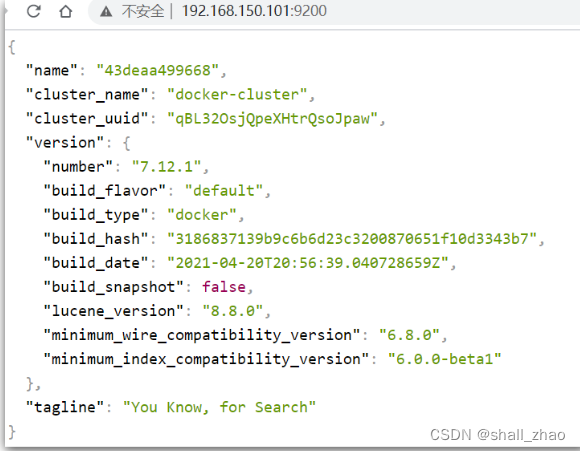

在浏览器中输入:http://192.168.150.101:9200 即可看到elasticsearch的响应结果:

部署kibana

kibana可以给我们提供一个elasticsearch的可视化界面,便于我们学习。

部署

运行docker命令,部署kibana

docker run -d

--name kibana

-e ELASTICSEARCH_HOSTS=http://es:9200

--network=es-net

-p 5601:5601

kibana:7.12.1

--network es-net:加入一个名为es-net的网络中,与elasticsearch在同一个网络中-e ELASTICSEARCH_HOSTS=http://es:9200":设置elasticsearch的地址,因为kibana已经与elasticsearch在一个网络,因此可以用容器名直接访问elasticsearch-p 5601:5601:端口映射配置

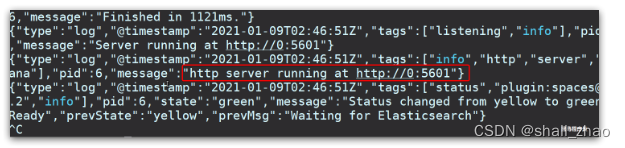

kibana启动一般比较慢,需要多等待一会,可以通过命令:

docker logs -f kibana

查看运行日志,当查看到下面的日志,说明成功:

此时,在浏览器输入地址访问:http://192.168.150.101:5601,即可看到结果

DevTools

kibana中提供了一个DevTools界面:

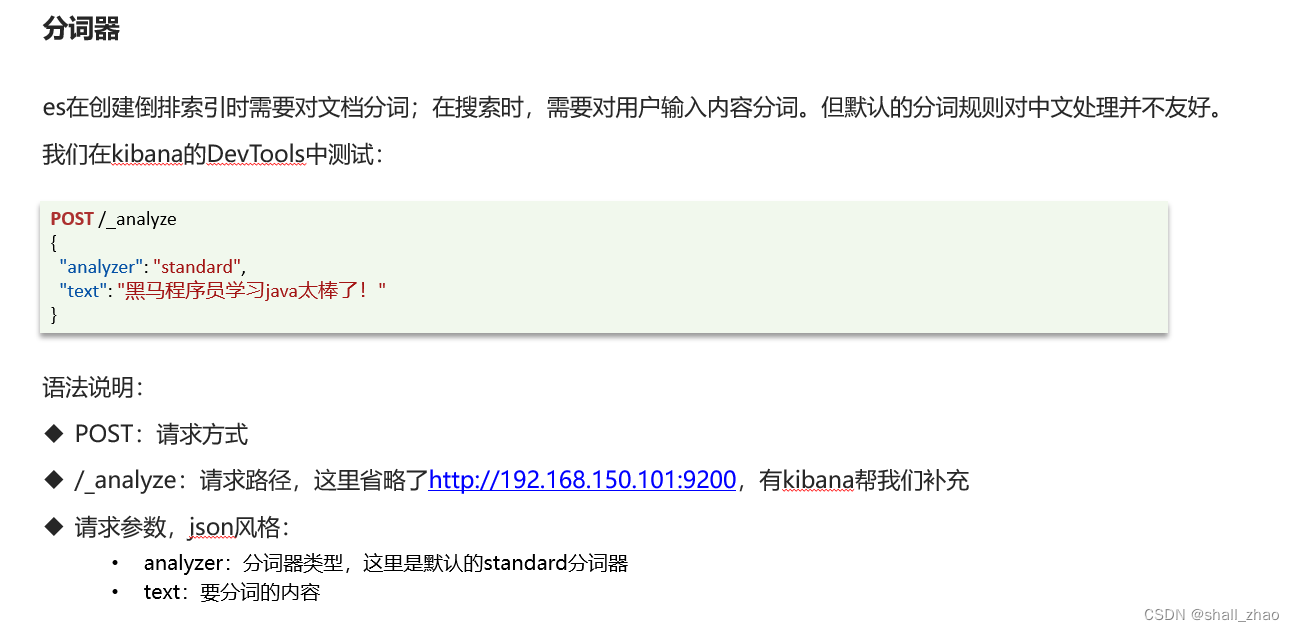

安装IK分词器

在线安装ik插件(较慢)

# 进入容器内部

docker exec -it es /bin/bash

# 在线下载并安装

./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.12.1/elasticsearch-analysis-ik-7.12.1.zip

#退出

exit

#重启容器

docker restart elasticsearch

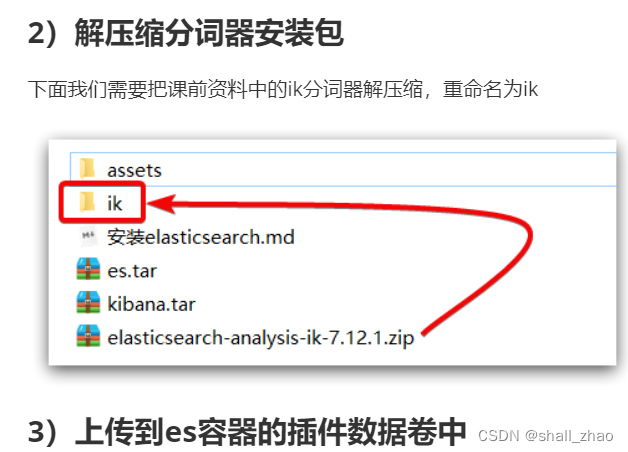

离线安装ik插件(推荐)

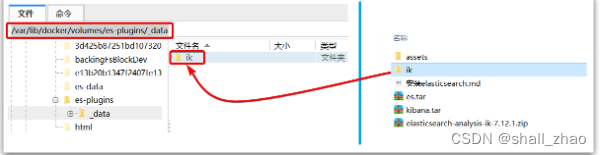

1)查看数据卷目录

安装插件需要知道elasticsearch的plugins目录位置,而我们用了数据卷挂载,因此需要查看elasticsearch的数据卷目录,通过下面命令查看:

docker volume inspect es-plugins

显示结果:

[

{

"CreatedAt": "2022-05-06T10:06:34+08:00",

"Driver": "local",

"Labels": null,

"Mountpoint": "/var/lib/docker/volumes/es-plugins/_data",

"Name": "es-plugins",

"Options": null,

"Scope": "local"

}

]

说明plugins目录被挂载到了:/var/lib/docker/volumes/es-plugins/_data 这个目录中。

也就是/var/lib/docker/volumes/es-plugins/_data :

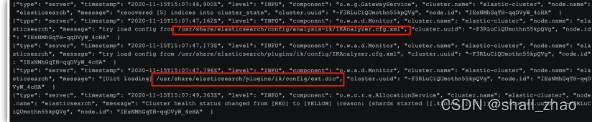

4)重启容器

# 4、重启容器

docker restart es

# 查看es日志

docker logs -f es

5)测试:

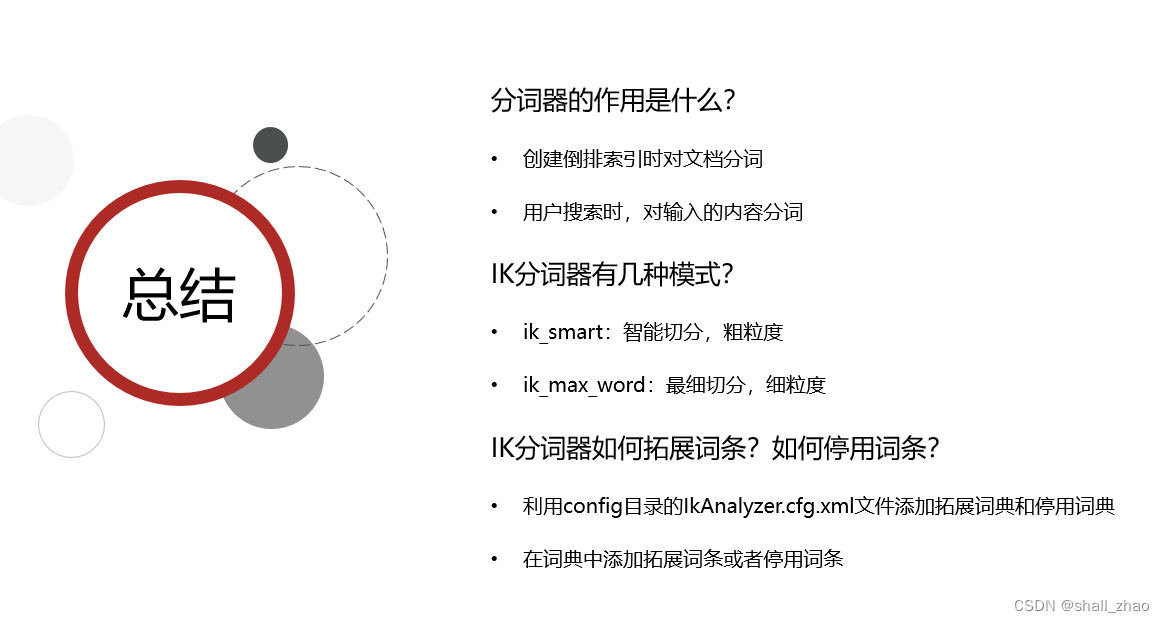

IK分词器包含两种模式:

-

ik_smart:最少切分 -

ik_max_word:最细切分

GET /_analyze

{

"analyzer": "ik_max_word",

"text": "黑马程序员学习java太棒了"

}

结果:

{

"tokens" : [

{

"token" : "黑马",

"start_offset" : 0,

"end_offset" : 2,

"type" : "CN_WORD",

"position" : 0

},

{

"token" : "程序员",

"start_offset" : 2,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 1

},

{

"token" : "程序",

"start_offset" : 2,

"end_offset" : 4,

"type" : "CN_WORD",

"position" : 2

},

{

"token" : "员",

"start_offset" : 4,

"end_offset" : 5,

"type" : "CN_CHAR",

"position" : 3

},

{

"token" : "学习",

"start_offset" : 5,

"end_offset" : 7,

"type" : "CN_WORD",

"position" : 4

},

{

"token" : "java",

"start_offset" : 7,

"end_offset" : 11,

"type" : "ENGLISH",

"position" : 5

},

{

"token" : "太棒了",

"start_offset" : 11,

"end_offset" : 14,

"type" : "CN_WORD",

"position" : 6

},

{

"token" : "太棒",

"start_offset" : 11,

"end_offset" : 13,

"type" : "CN_WORD",

"position" : 7

},

{

"token" : "了",

"start_offset" : 13,

"end_offset" : 14,

"type" : "CN_CHAR",

"position" : 8

}

]

}

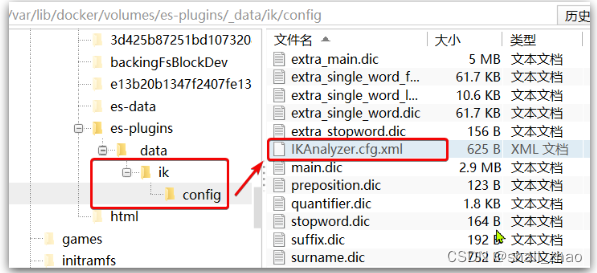

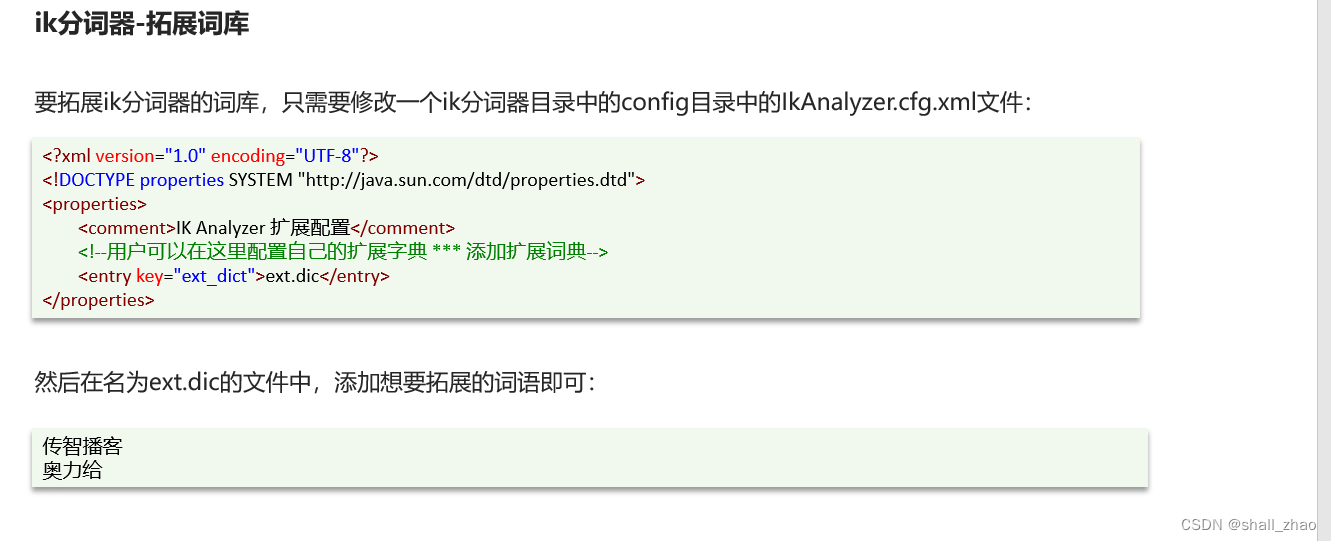

扩展词词典

随着互联网的发展,“造词运动”也越发的频繁。出现了很多新的词语,在原有的词汇列表中并不存在。比如:“奥力给”,“传智播客” 等。

所以我们的词汇也需要不断的更新,IK分词器提供了扩展词汇的功能。

1)打开IK分词器config目录:

2)在IKAnalyzer.cfg.xml配置文件内容添加:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置</comment>

<!--用户可以在这里配置自己的扩展字典 *** 添加扩展词典-->

<entry key="ext_dict">ext.dic</entry>

</properties>

3)新建一个 ext.dic,可以参考config目录下复制一个配置文件进行修改

传智播客

奥力给

4)重启elasticsearch

docker restart es

# 查看 日志

docker logs -f elasticsearch

日志中已经成功加载ext.dic配置文件

5)测试效果:

GET /_analyze

{

"analyzer": "ik_max_word",

"text": "传智播客Java就业超过90%,奥力给!"

}

注意当前文件的编码必须是 UTF-8 格式,严禁使用Windows记事本编辑

停用词词典

在互联网项目中,在网络间传输的速度很快,所以很多语言是不允许在网络上传递的,如:关于宗教、政治等敏感词语,那么我们在搜索时也应该忽略当前词汇。

IK分词器也提供了强大的停用词功能,让我们在索引时就直接忽略当前的停用词汇表中的内容。

1)IKAnalyzer.cfg.xml配置文件内容添加:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置</comment>

<!--用户可以在这里配置自己的扩展字典-->

<entry key="ext_dict">ext.dic</entry>

<!--用户可以在这里配置自己的扩展停止词字典 *** 添加停用词词典-->

<entry key="ext_stopwords">stopword.dic</entry>

</properties>

3)在 stopword.dic 添加停用词

停用词

4)重启elasticsearch

# 重启服务

docker restart elasticsearch

docker restart kibana

# 查看 日志

docker logs -f elasticsearch

日志中已经成功加载stopword.dic配置文件

5)测试效果:

GET /_analyze

{

"analyzer": "ik_max_word",

"text": "传智播客Java就业率超过95%,停用词都点赞,奥力给!"

}

注意当前文件的编码必须是 UTF-8 格式,严禁使用Windows记事本编辑

部署es集群

部署es集群可以直接使用docker-compose来完成,不过要求你的Linux虚拟机至少有4G的内存空间

首先编写一个docker-compose文件,内容如下:

version: '2.2'

services:

es01:

image: docker.elastic.co/elasticsearch/elasticsearch:7.12.1

container_name: es01

environment:

- node.name=es01

- cluster.name=es-docker-cluster

- discovery.seed_hosts=es02,es03

- cluster.initial_master_nodes=es01,es02,es03

- bootstrap.memory_lock=true

- "ES_JAVA_OPTS=-Xms512m -Xmx512m"

ulimits:

memlock:

soft: -1

hard: -1

volumes:

- data01:/usr/share/elasticsearch/data

ports:

- 9200:9200

networks:

- elastic

es02:

image: docker.elastic.co/elasticsearch/elasticsearch:7.12.1

container_name: es02

environment:

- node.name=es02

- cluster.name=es-docker-cluster

- discovery.seed_hosts=es01,es03

- cluster.initial_master_nodes=es01,es02,es03

- bootstrap.memory_lock=true

- "ES_JAVA_OPTS=-Xms512m -Xmx512m"

ulimits:

memlock:

soft: -1

hard: -1

volumes:

- data02:/usr/share/elasticsearch/data

networks:

- elastic

es03:

image: docker.elastic.co/elasticsearch/elasticsearch:7.12.1

container_name: es03

environment:

- node.name=es03

- cluster.name=es-docker-cluster

- discovery.seed_hosts=es01,es02

- cluster.initial_master_nodes=es01,es02,es03

- bootstrap.memory_lock=true

- "ES_JAVA_OPTS=-Xms512m -Xmx512m"

ulimits:

memlock:

soft: -1

hard: -1

volumes:

- data03:/usr/share/elasticsearch/data

networks:

- elastic

volumes:

data01:

driver: local

data02:

driver: local

data03:

driver: local

networks:

elastic:

driver: bridge

Run docker-compose to bring up the cluster:

docker-compose up

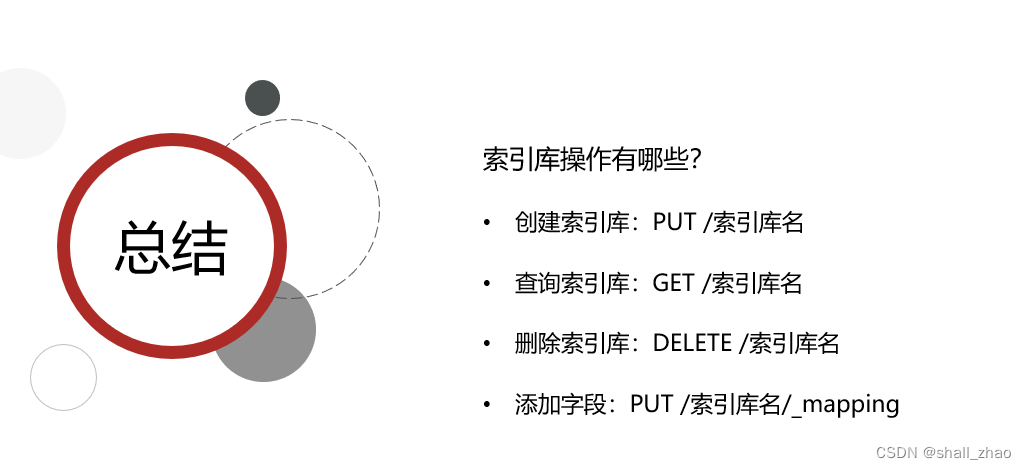

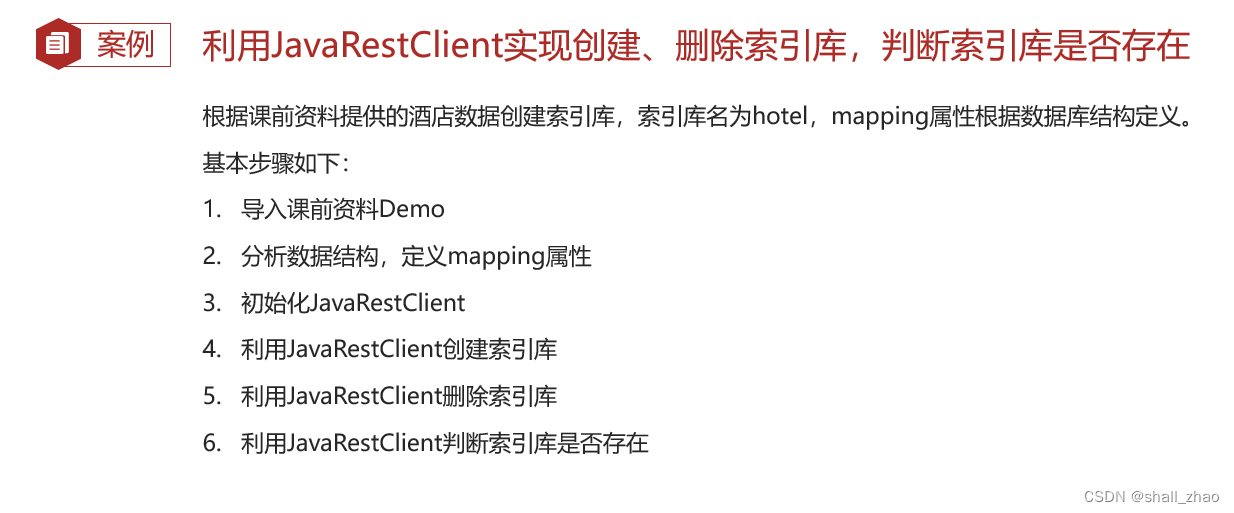

索引库操作

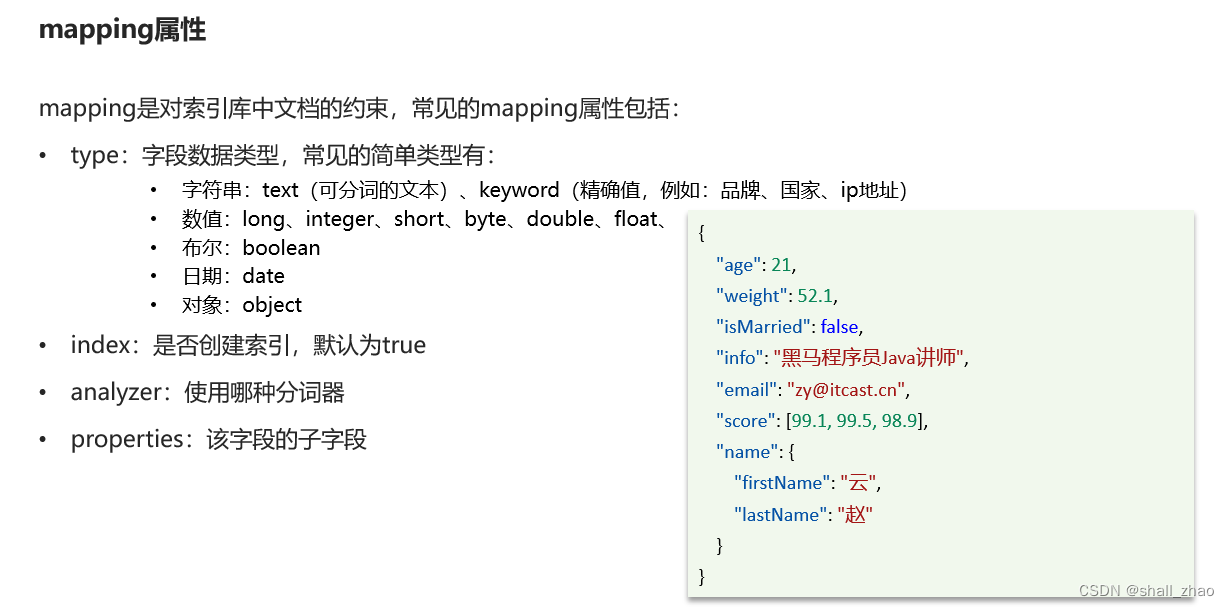

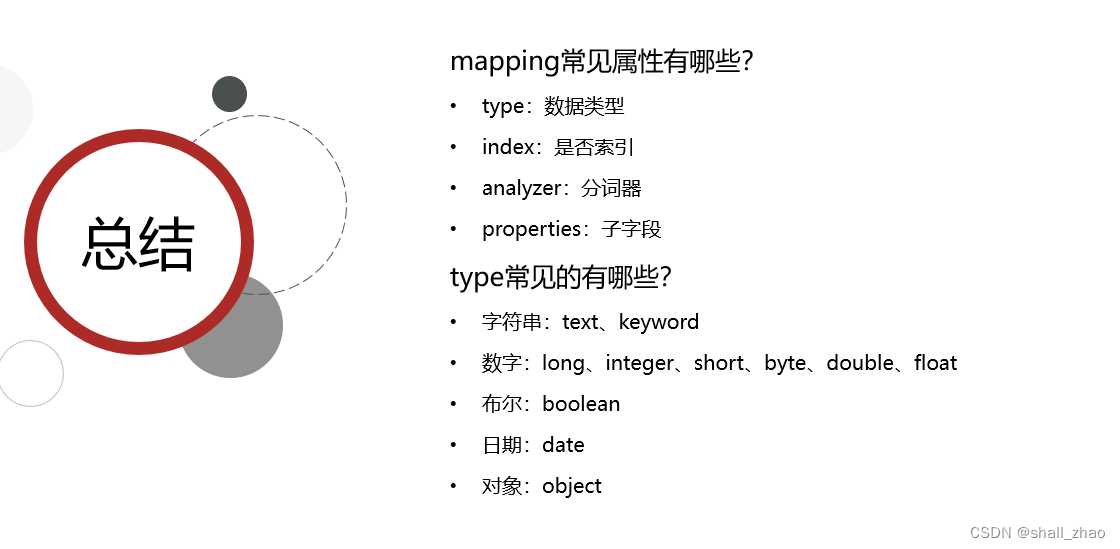

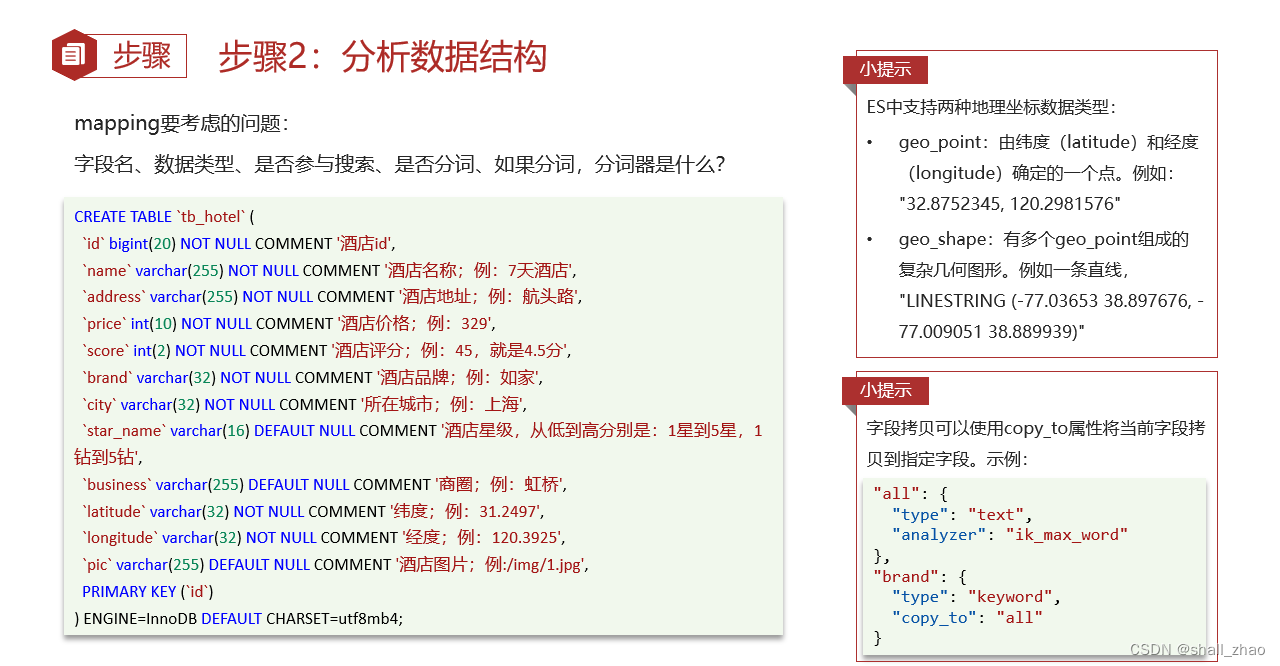

mapping属性

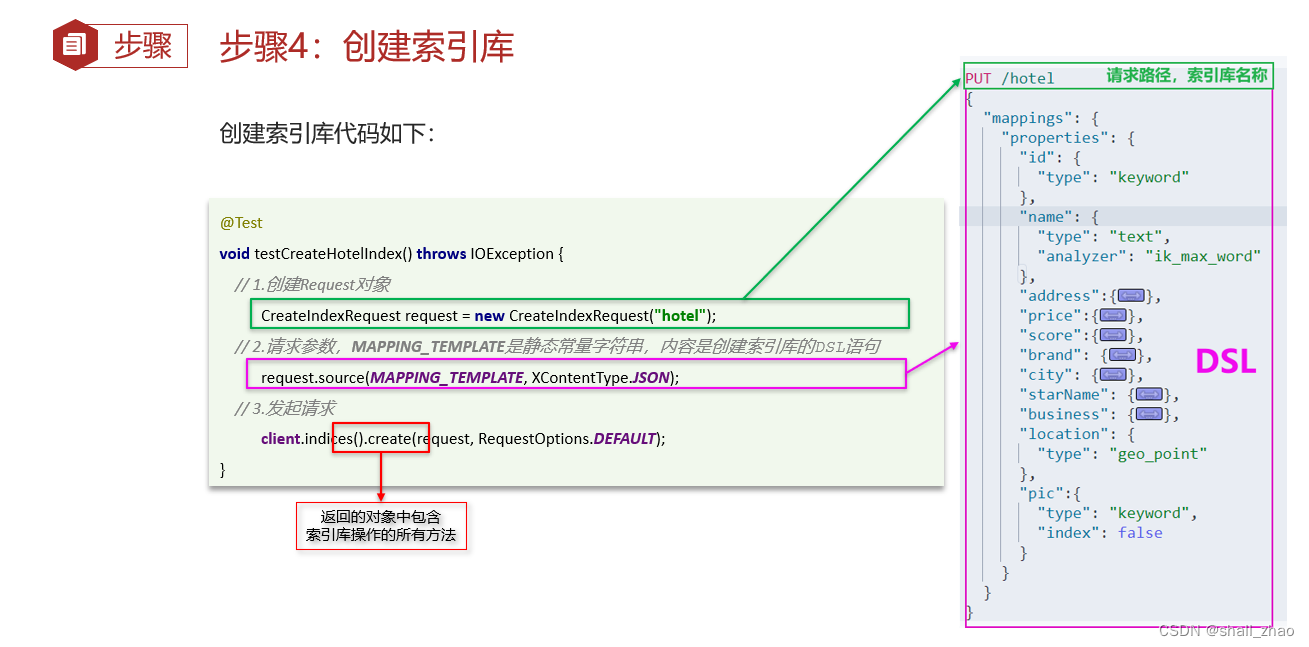

创建索引库

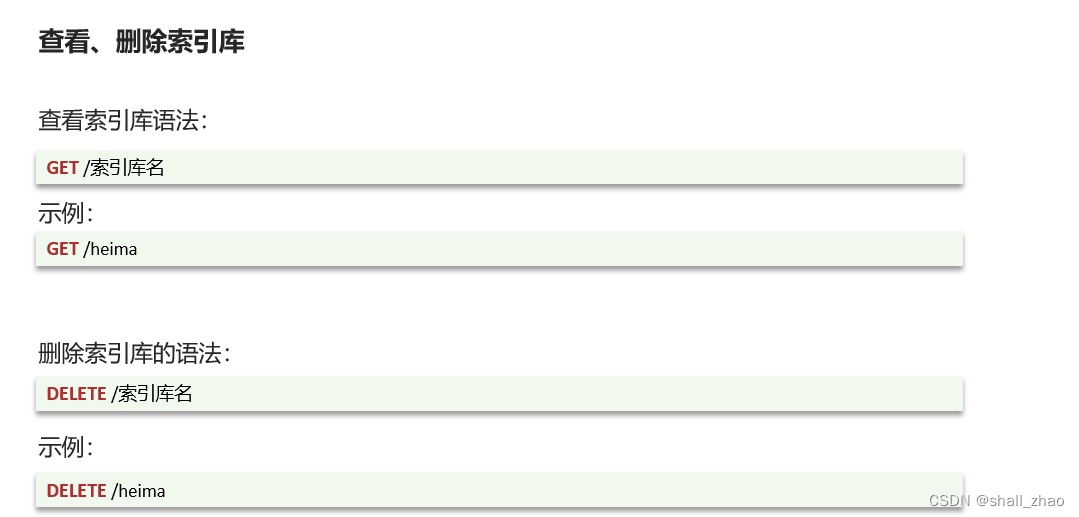

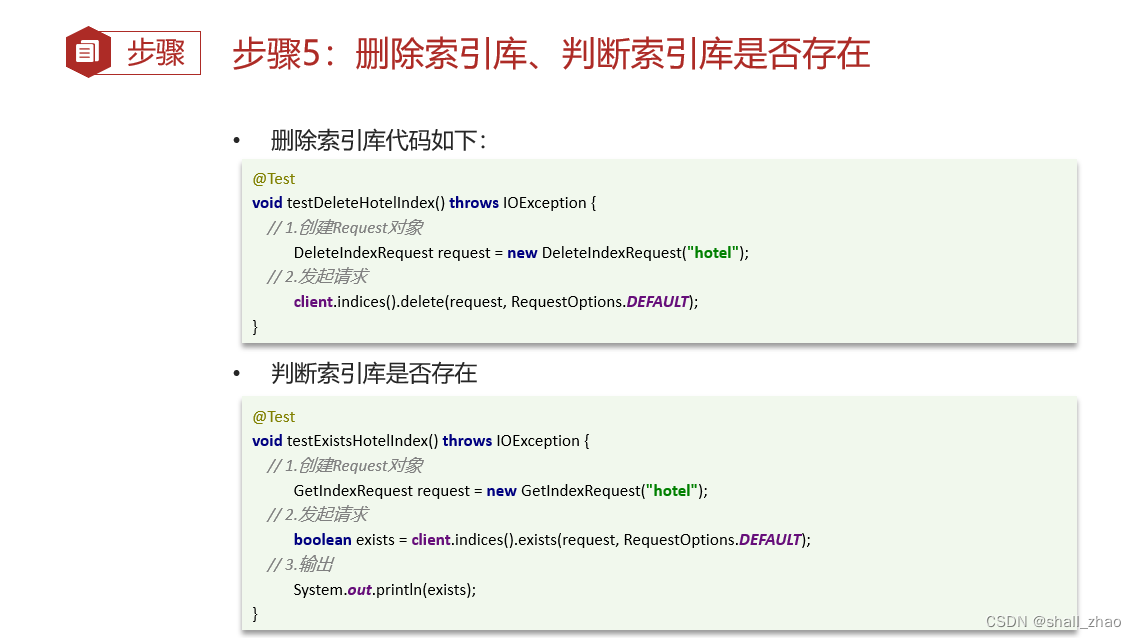

查询,删除索引库

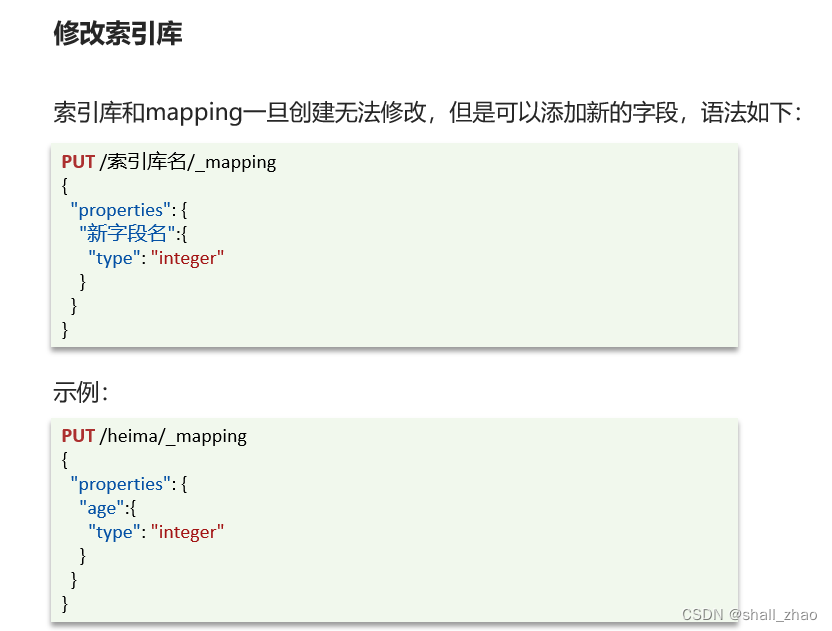

修改索引库——添加字段

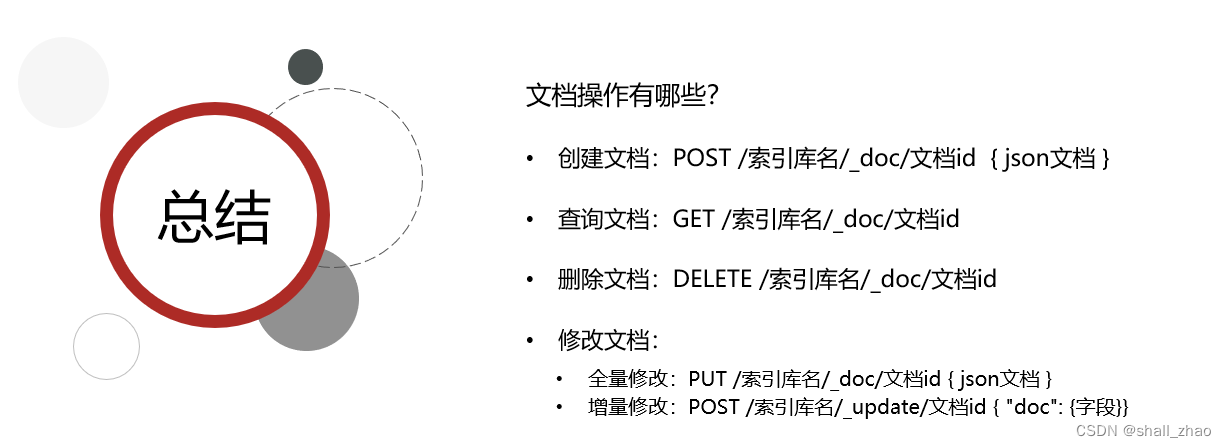

文档操作

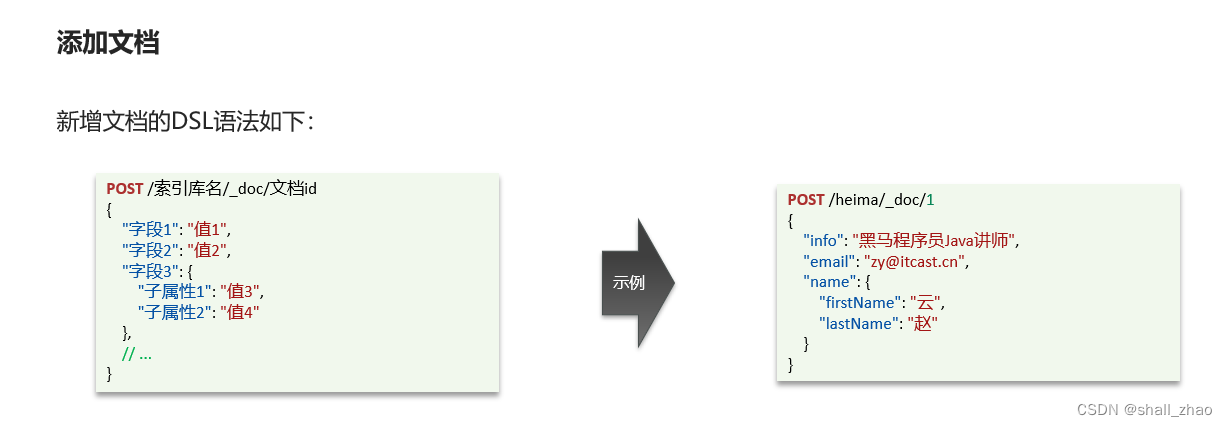

添加文档

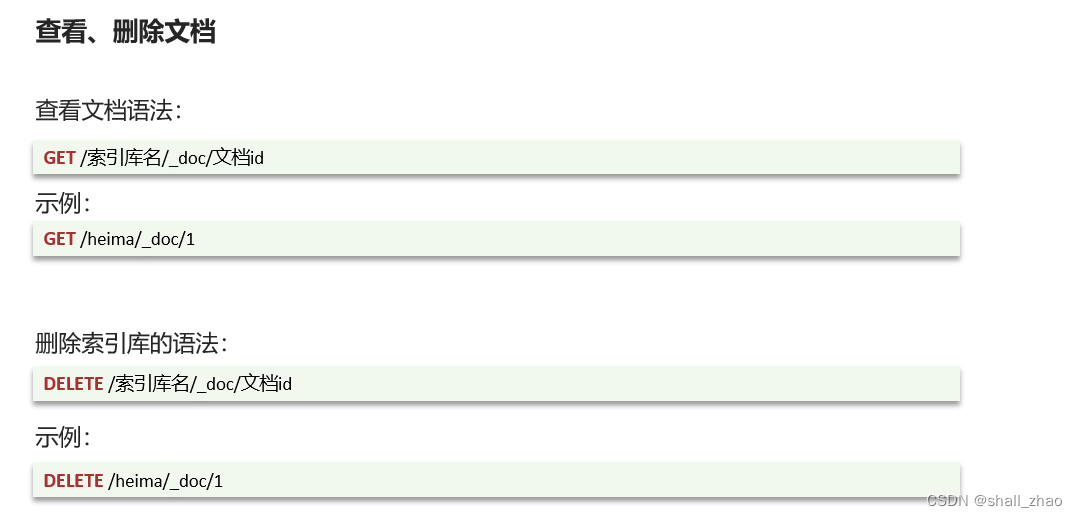

查看、删除文档

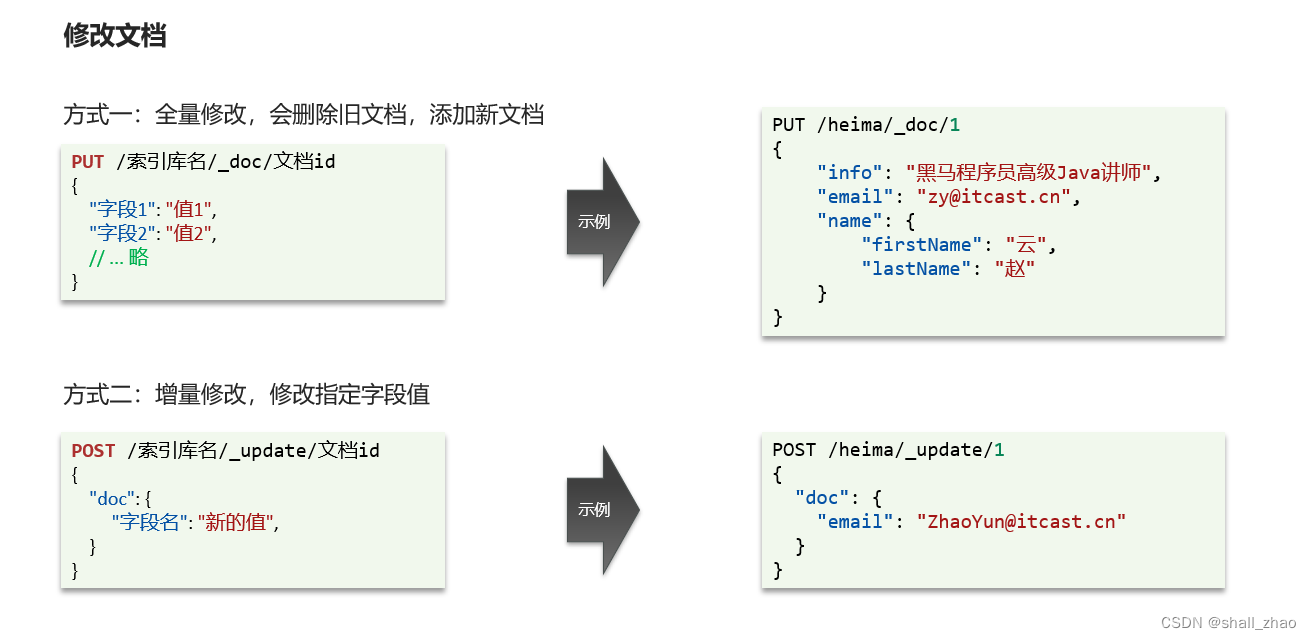

修改文档

全量修改如果传的id不存在,就直接成为新增了。

增量修改就是局部修改。

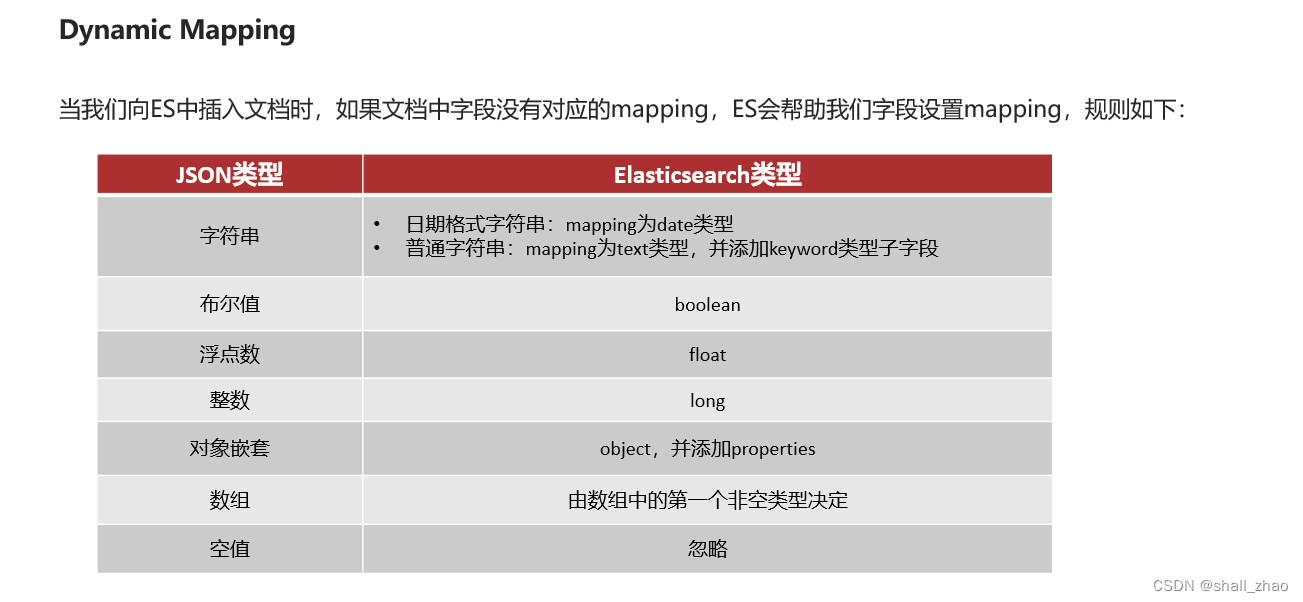

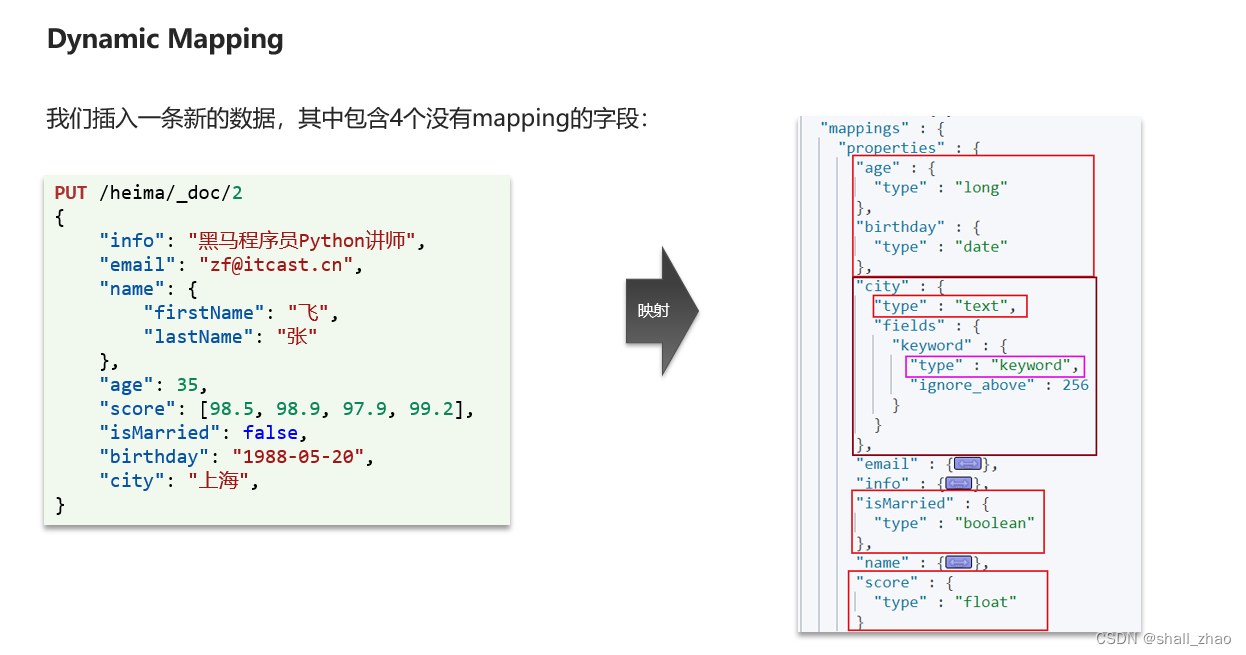

文档操作——动态映射

RestClient操作索引库

https://www.elastic.co/guide/en/elasticsearch/client/index.html

public class HotelIndexTest {

private RestHighLevelClient client;

@Test

void testInit(){

System.out.println(client);

}

// 创建索引库

@Test

void createHotelIndex() throws IOException {

// 1. 创建request对象

CreateIndexRequest request = new CreateIndexRequest("hotel");

// 2. 准备请求的参数:DSL语句

request.source(MAPPING_TEMPLATE, XContentType.JSON);

// 3. 发送请求

client.indices().create(request, RequestOptions.DEFAULT);

}

// 删除索引库

@Test

void testDDeleteHotelIndex() throws IOException {

// 1. 创建Request对象

DeleteIndexRequest request = new DeleteIndexRequest("hotel");

// 2. 发送请求

client.indices().delete(request,RequestOptions.DEFAULT);

}

// 判断是否存在索引库

@Test

void testExistsHotelIndex() throws IOException {

// 1. 创建Request对象

GetIndexRequest request = new GetIndexRequest("hotel");

// 2. 发送请求

boolean exists = client.indices().exists(request, RequestOptions.DEFAULT);

// 3. 输出

System.out.println(exists ? "索引库已经存在": "索引库不存在!");

}

@BeforeEach

void setUp(){

this.client = new RestHighLevelClient(RestClient.builder(

HttpHost.create("http://192.168.10.88:9200")

));

}

@AfterEach

void tearDown() throws IOException {

this.client.close();

}

}

public class HotelConstants {

public static final String MAPPING_TEMPLATE = "{n" +

" "mappings": {n" +

" "properties": {n" +

" "id": {n" +

" "type": "keyword"n" +

" },n" +

" "name": {n" +

" "type": "text",n" +

" "analyzer": "ik_max_word",n" +

" "copy_to": "{all}"n" +

" },n" +

" "address": {n" +

" "type": "keyword",n" +

" "index": falsen" +

" },n" +

" "price": {n" +

" "type": "integer"n" +

" },n" +

" "score": {n" +

" "type": "integer"n" +

" },n" +

" "brand": {n" +

" "type": "keyword",n" +

" "copy_to": "{all}"n" +

" },n" +

" "city": {n" +

" "type": "keyword"n" +

" },n" +

" "starName": {n" +

" "type": "keyword"n" +

" },n" +

" "business": {n" +

" "type": "keyword",n" +

" "copy_to": "{all}"n" +

" },n" +

" "location": {n" +

" "type": "geo_point"n" +

" },n" +

" "pic": {n" +

" "type": "keyword",n" +

" "index": falsen" +

" },n" +

" "all": {n" +

" "type": "text",n" +

" "analyzer": "ik_max_word"n" +

" }n" +

" }n" +

" n" +

" }n" +

"}";

}

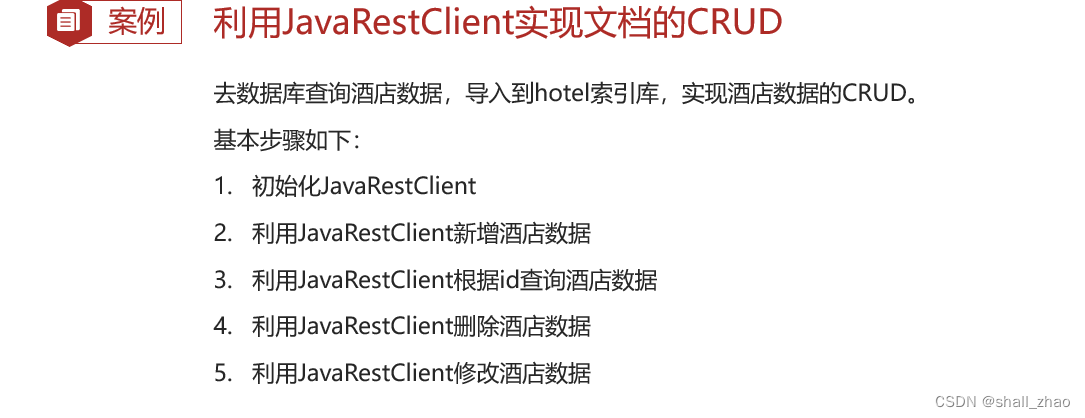

RestClient操作文档

@SpringBootTest

public class HotelDocumentTest {

private RestHighLevelClient client;

@Autowired

private IHotelService hotelService;

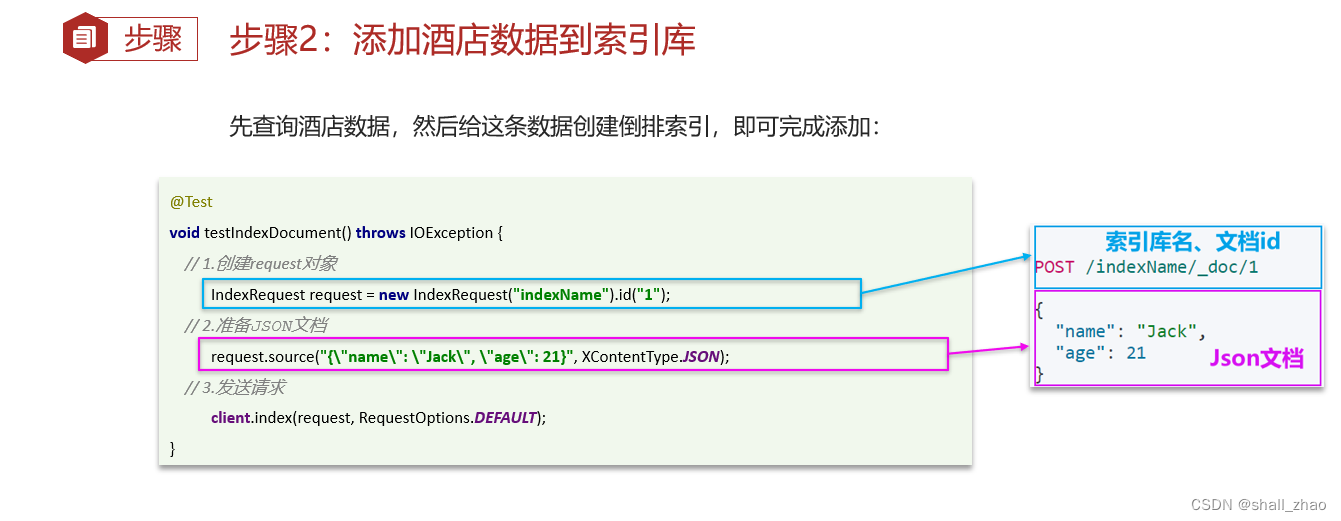

// 添加酒店数据到索引库

@Test

void testAddDocument() throws IOException {

// 根据id查询酒店数据

Hotel hotel = hotelService.getById(61083L);

// 转换为文档类型

HotelDoc hotelDoc = new HotelDoc(hotel);

// 1. 准备Request对象

IndexRequest request = new IndexRequest("hotel").id(hotel.getId().toString());

// 2. 准备json文档

request.source(JSON.toJSONString(hotelDoc),XContentType.JSON);

// 3. 发送文档

client.index(request,RequestOptions.DEFAULT);

}

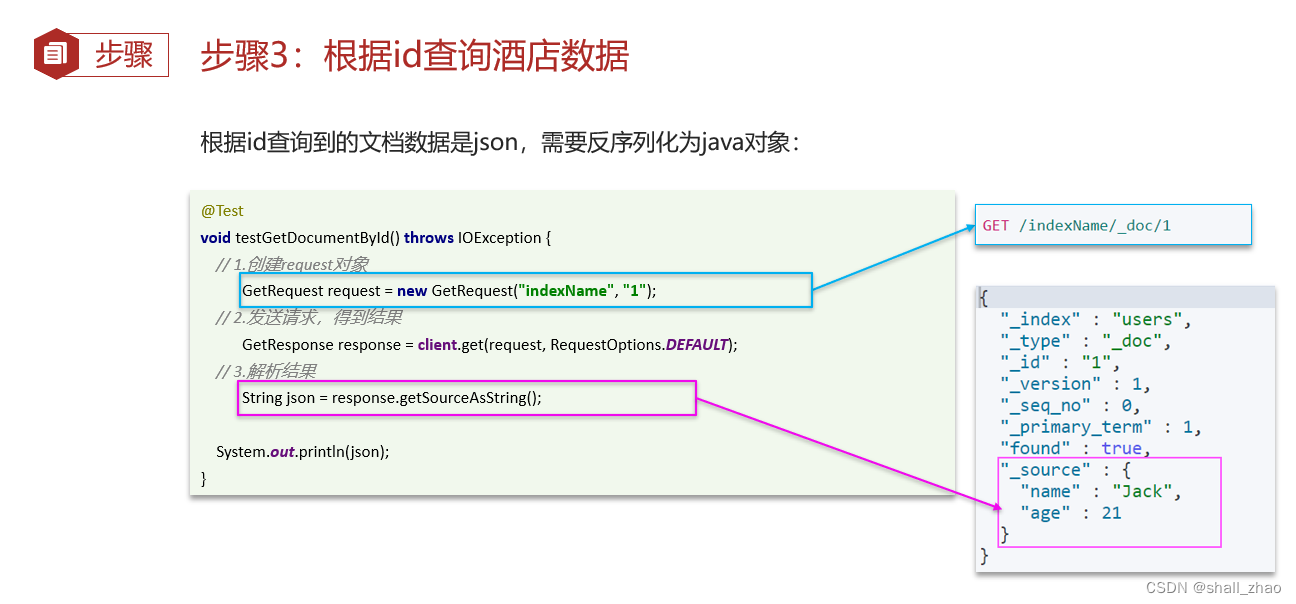

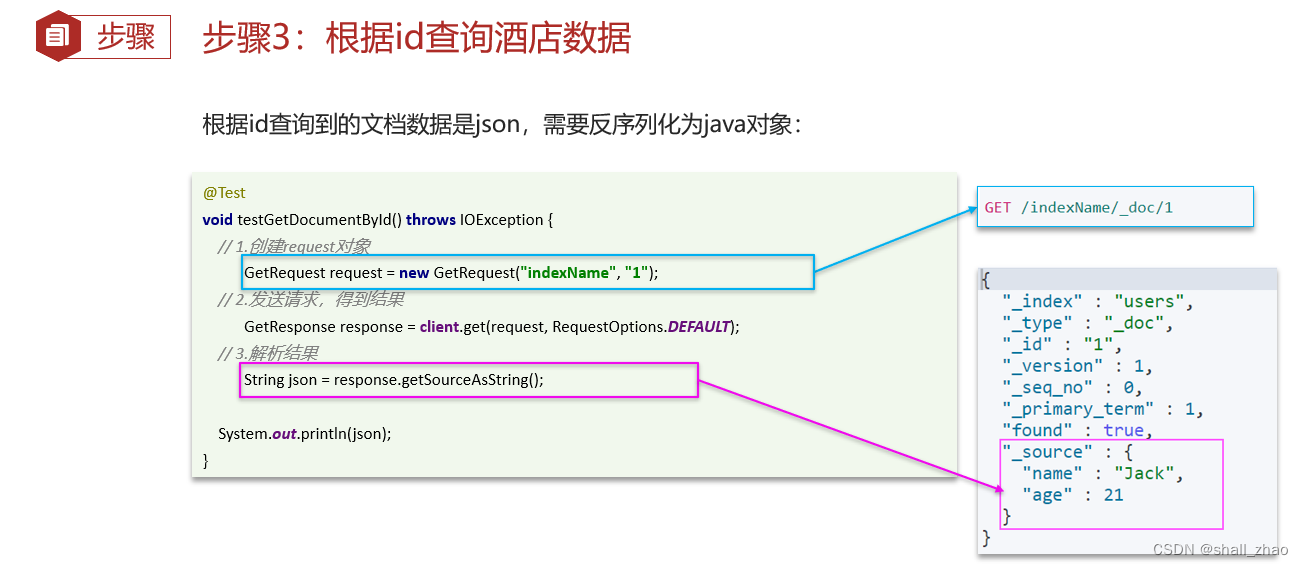

// 根据id查询酒店数据

@Test

void testGetDocumentById() throws IOException {

// 1. 准备Request

GetRequest request = new GetRequest("hotel", "61083");

// 2. 发送请求,得到响应

GetResponse response = client.get(request, RequestOptions.DEFAULT);

// 3. 解析响应结果

String json = response.getSourceAsString();

HotelDoc hotelDoc = JSON.parseObject(json, HotelDoc.class);

System.out.println(hotelDoc);

}

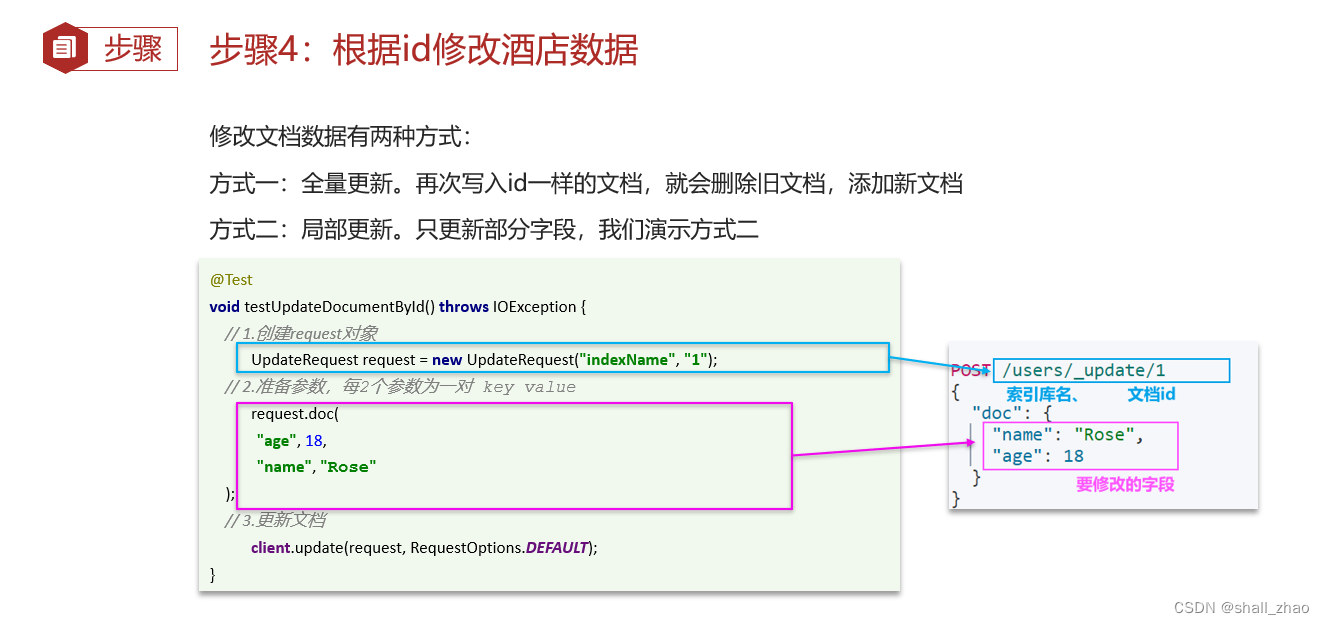

// 根据id修改酒店数据

@Test

void testUpdateDocument() throws IOException {

// 1. 准备request

UpdateRequest request = new UpdateRequest("hotel", "61083");

// 2. 准备请求参数

request.doc(

"price", "998",

"starName", "四钻"

);

// 3. 发送请求

client.update(request, RequestOptions.DEFAULT);

}

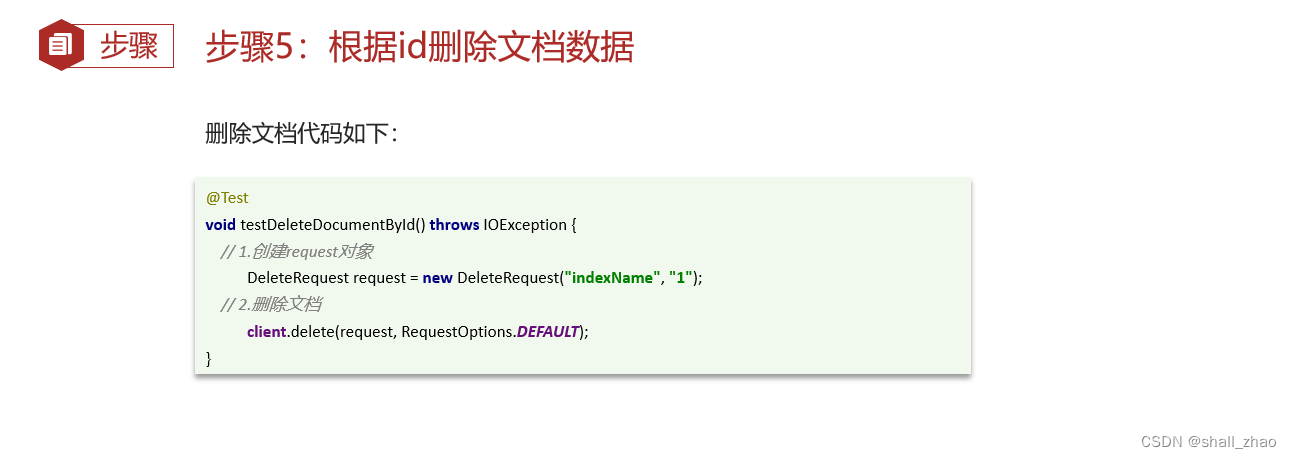

// 根据id删除文档数据

@Test

void testDeleteDocument() throws IOException {

// 1. 准备request

DeleteRequest request = new DeleteRequest("hotel", "61083");

// 2. 发送请求

client.delete(request, RequestOptions.DEFAULT);

}

@BeforeEach

void setUp(){

this.client = new RestHighLevelClient(RestClient.builder(

HttpHost.create("http://192.168.10.88:9200")

));

}

@AfterEach

void tearDown() throws IOException {

this.client.close();

}

}

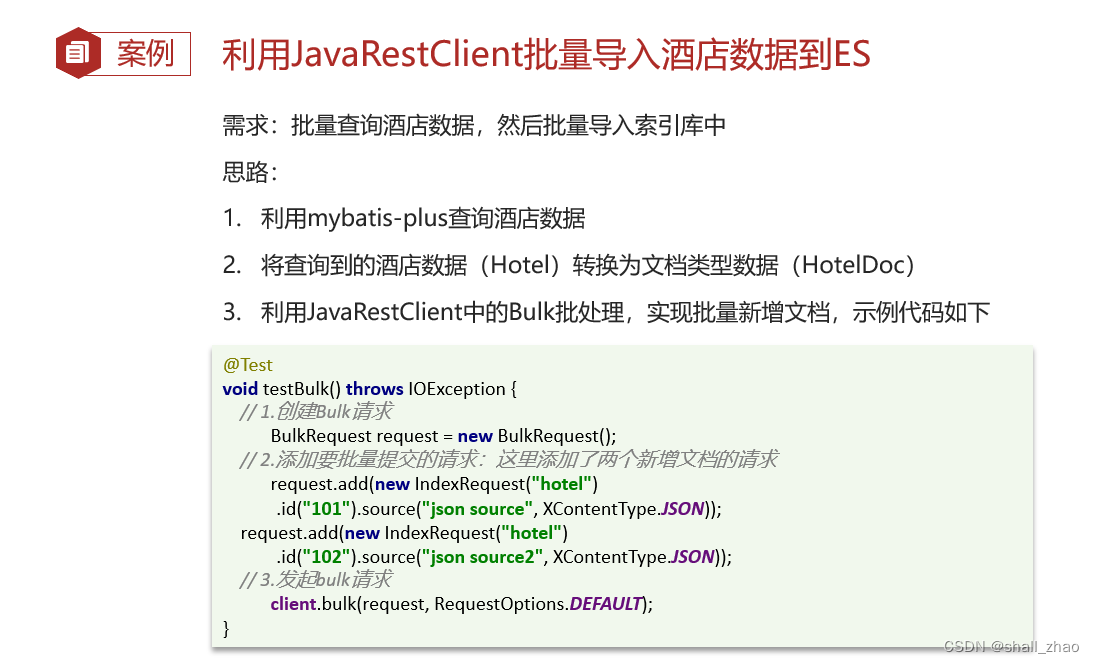

利用JavaRestClient批量导入酒店数据到ES

// 批量添加

@Test

void testBulkRequest() throws IOException {

// 批量查询酒店数据

List<Hotel> hotels = hotelService.list();

// 1. 创建Request

BulkRequest request = new BulkRequest();

// 2. 转杯参数,添加多个新增的Request

for (Hotel hotel : hotels) {

// 转换为文档类型HotelDoc

HotelDoc hotelDoc = new HotelDoc(hotel);

request.add(new IndexRequest("hotel")

.id(hotelDoc.getId().toString())

.source(JSON.toJSONString(hotelDoc),XContentType.JSON));

}

// 3. 发送请求

client.bulk(request, RequestOptions.DEFAULT);

}

原文地址:https://blog.csdn.net/shall_zhao/article/details/135566278

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_57270.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!