本文介绍: 1 CNN 学到的是什么1.1 Convolution 中的参数1.2 FFN 中的参数1.3 Output2 Deep Dream3 Deep Style4 More Application4.1 AlphaGo4.2 Speech4.3 Text

目录

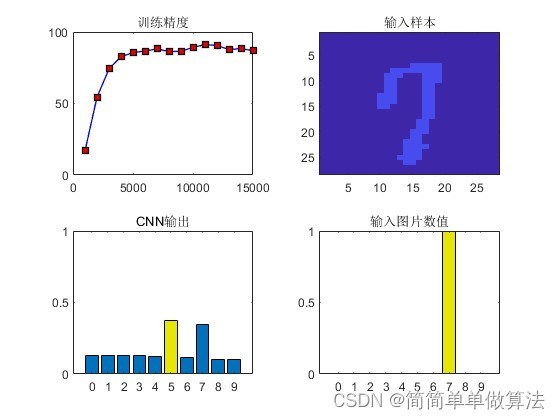

1 CNN 学到的是什么

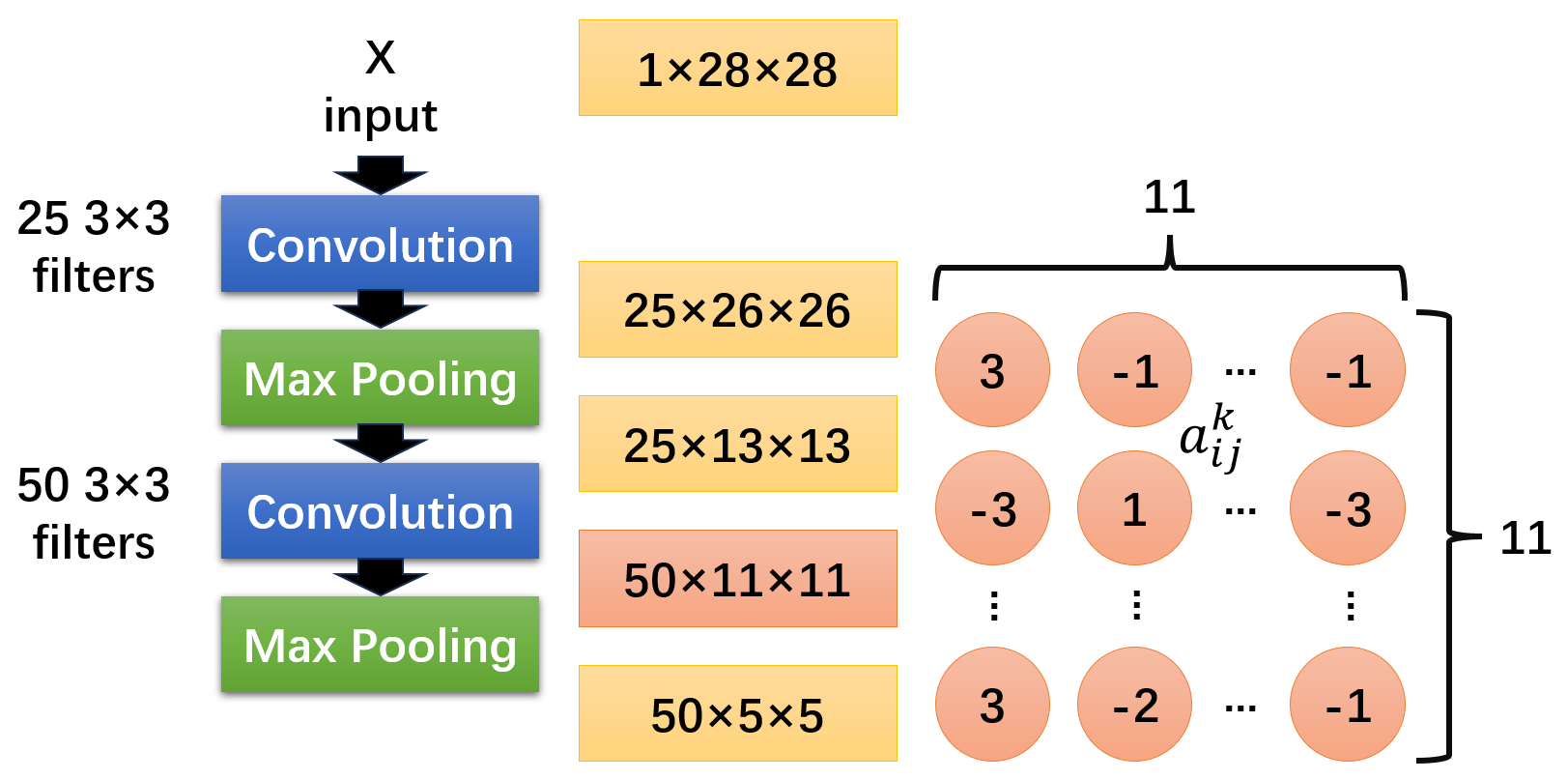

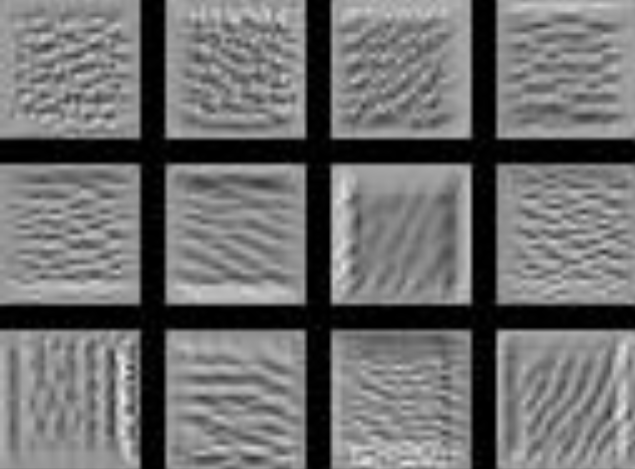

1.1 Convolution 中的参数

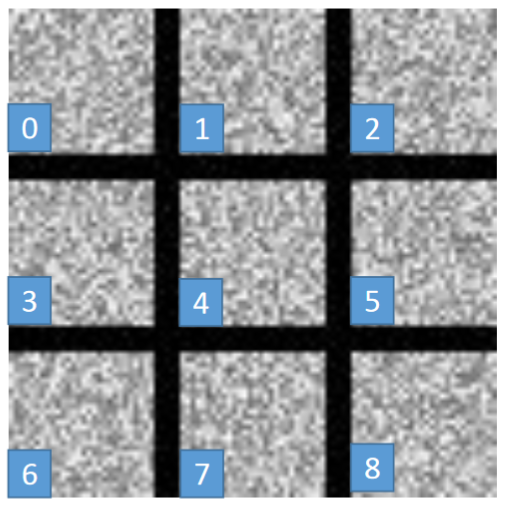

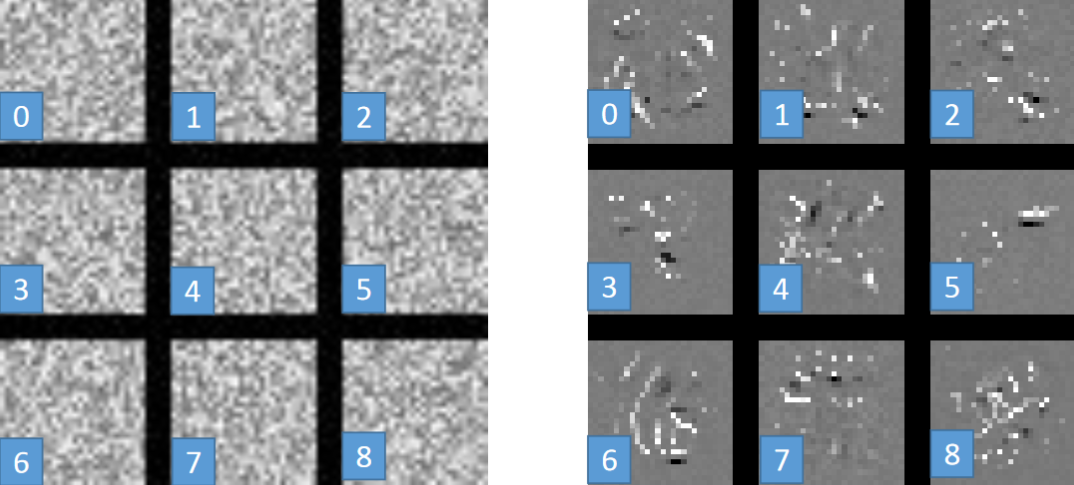

1.2 FFN 中的参数

1.3 Output

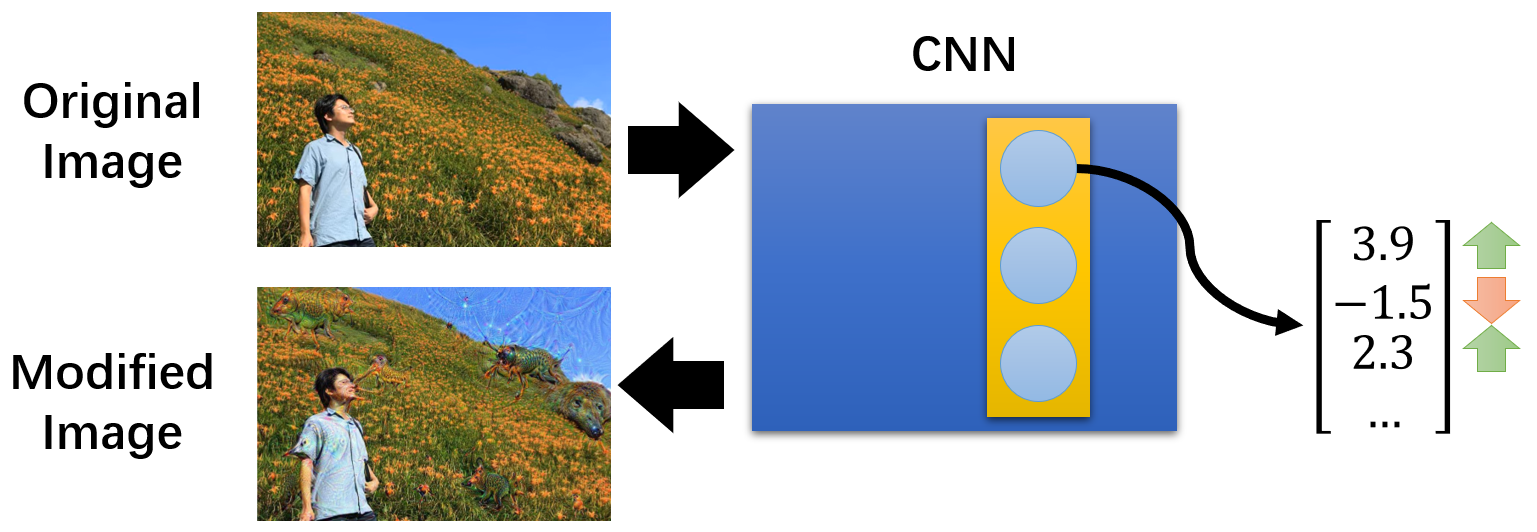

2 Deep Dream

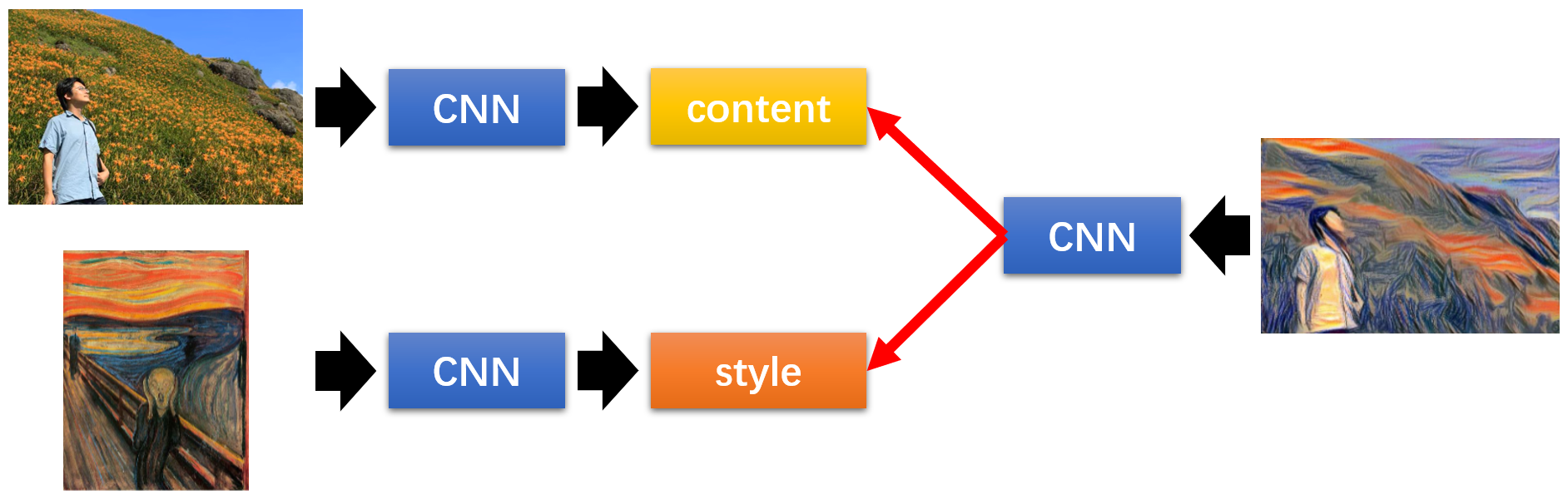

3 Deep Style

4 More Application

4.1 AlphaGo

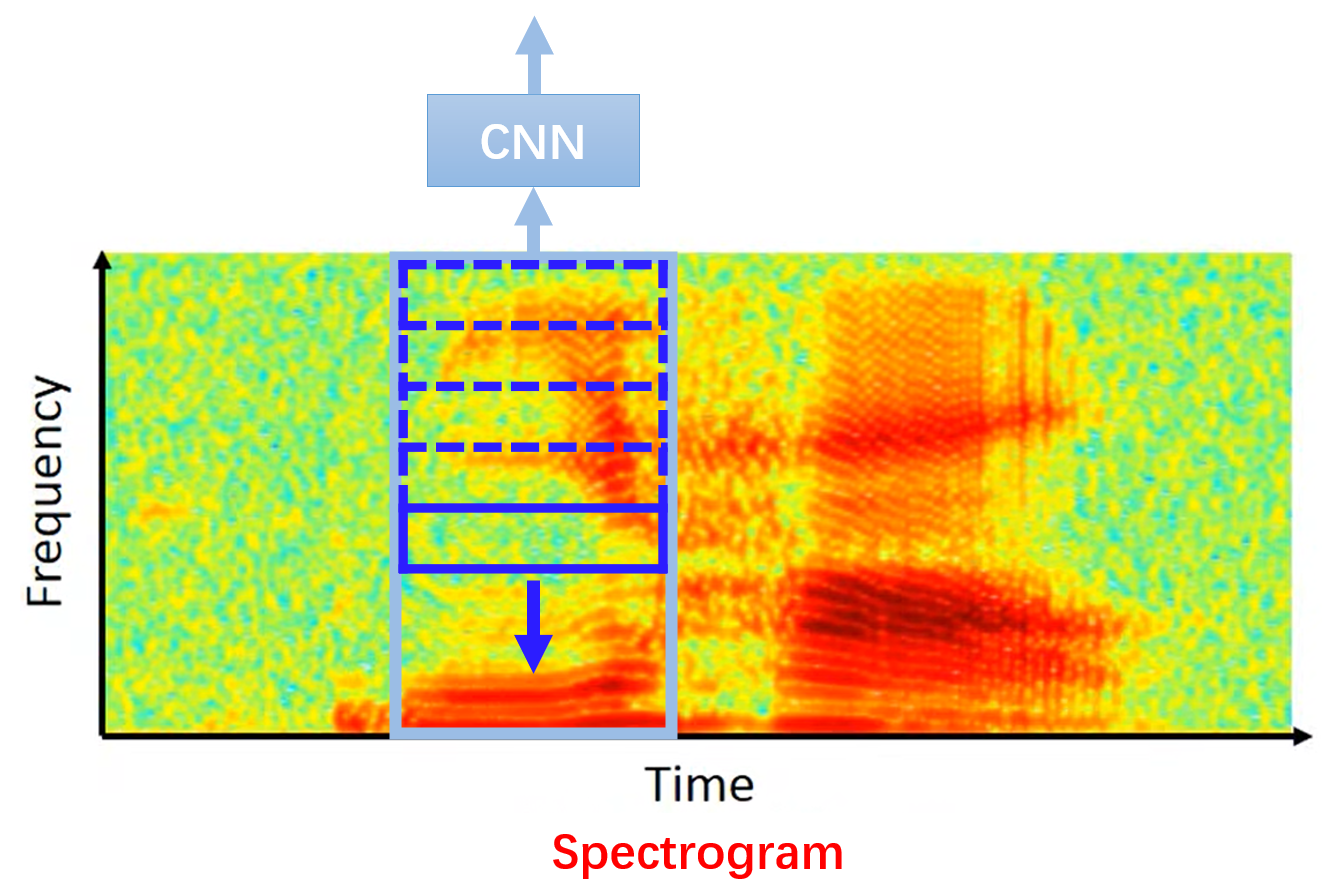

4.2 Speech

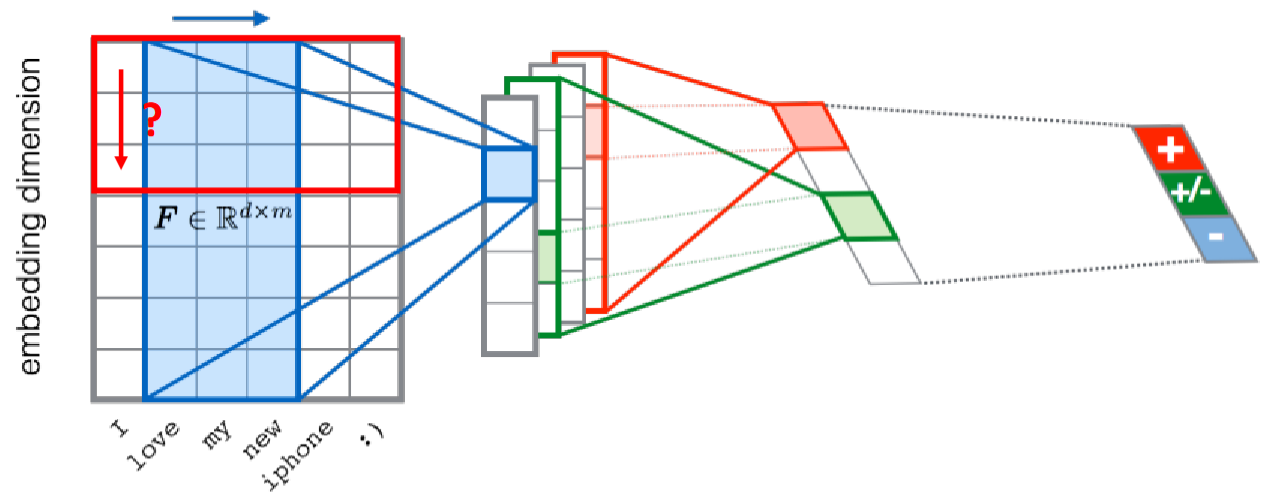

4.3 Text

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。