本文介绍: 方法,,每一步都根据前一步的模型误差来训练一个新的弱学习器,然后将其加到整体模型中。

什么是机器学习

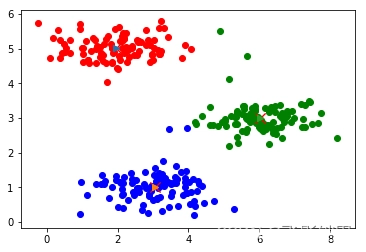

梯度提升机(Gradient Boosting Machines,GBM)是一种集成学习方法,通过将多个弱学习器(通常是决策树)组合成一个强学习器来提高模型的性能。GBM的训练过程是通过迭代,每一步都根据前一步的模型误差来训练一个新的弱学习器,然后将其加到整体模型中。

以下是梯度提升机的基本原理和使用方法:

基本原理

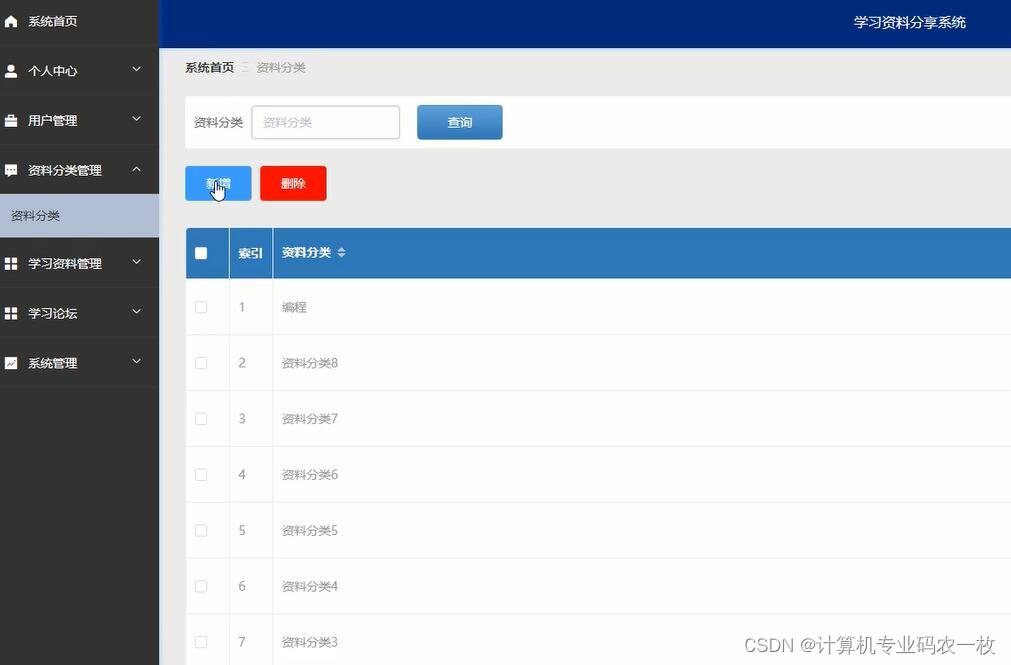

使用方法

GBM的使用步骤通常包括以下几个阶段:

代码示例(使用Python和scikit-learn)

以下是一个简单的梯度提升机分类的示例:

在这个示例中,我们使用了GradientBoostingClassifier,你可以根据问题的性质调整模型的超参数,如n_estimators(弱学习器的数量)、learning_rate(学习率)和max_depth(树的深度)等。详细的参数说明可以在官方文档中找到。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。