本文介绍: 【论文笔记合集】卷积神经网络之深度可分离卷积(Depthwise Separable Convolution)

本文作者: slience_me

我看的论文地址:MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

内容

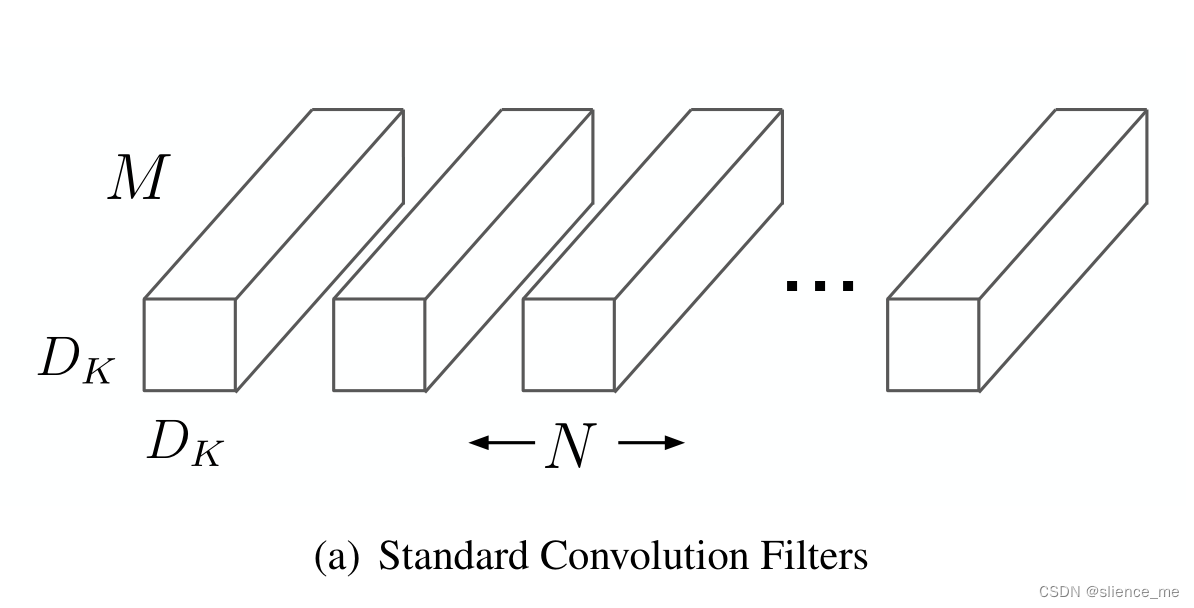

1. 标准卷积

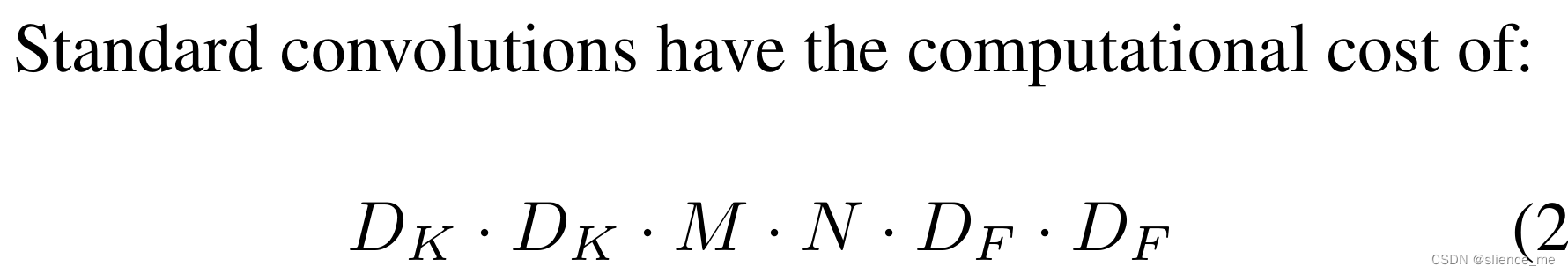

假设输入为DF×DF×M,输出为输入为DF×DF×N,卷积核为DK×DK×M,共有N个卷积核进行卷积操作

下图为标准的卷积过程,每个卷积核对输入的向量进行卷积操作,得到一个特征映射,共有N个卷积核进行卷积操作,则可以得到N个特征映射,即DK×DK×N

示意图如下:一般卷积

2. 深度可分离卷积(Depthwise Separable Convolution)

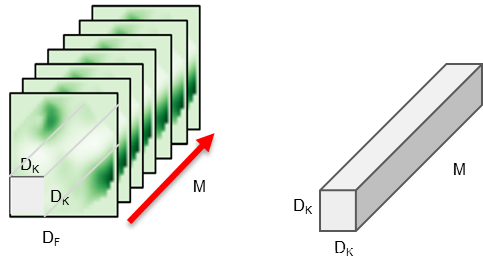

2.1 Depthwise Convolution

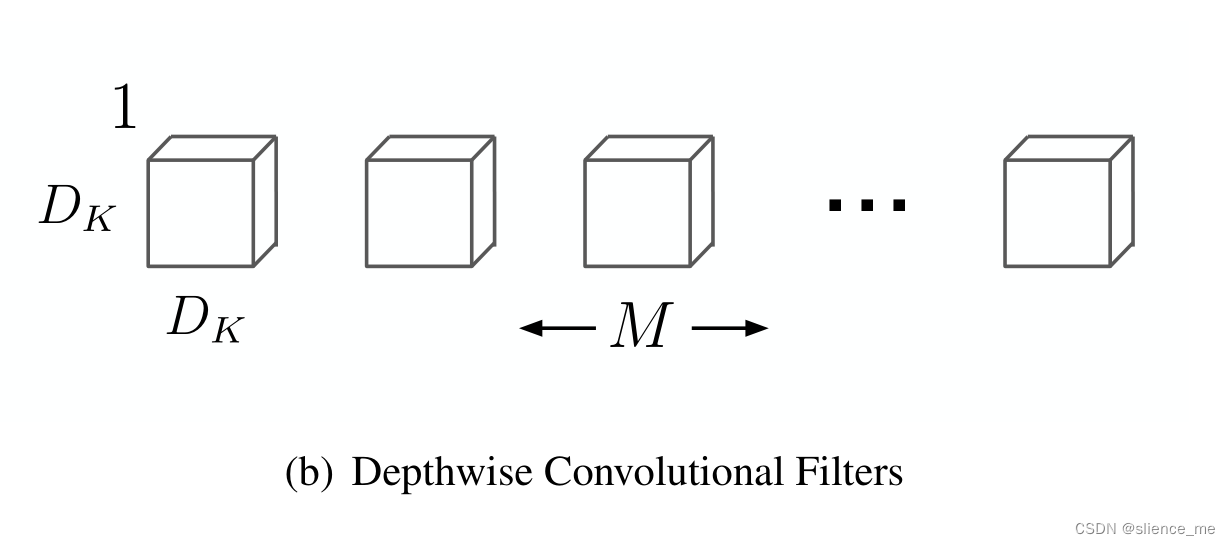

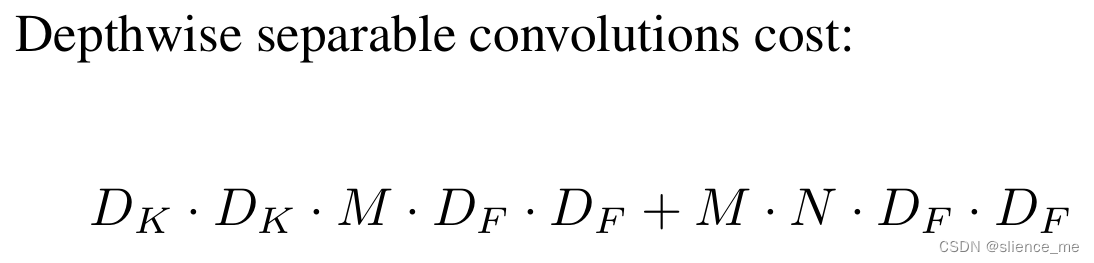

对于深度可分离卷积而言,

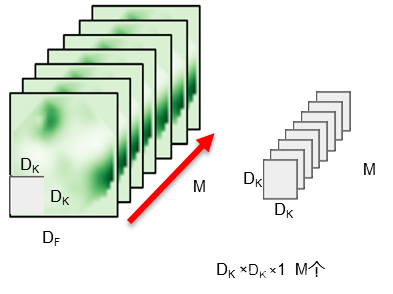

根据我的第二个图可知,每一个卷积核只负责一个通道的卷积操作,共有M个通道,则需要M个卷积核,对每一个通道进行卷积操作。

详细过程描述为:

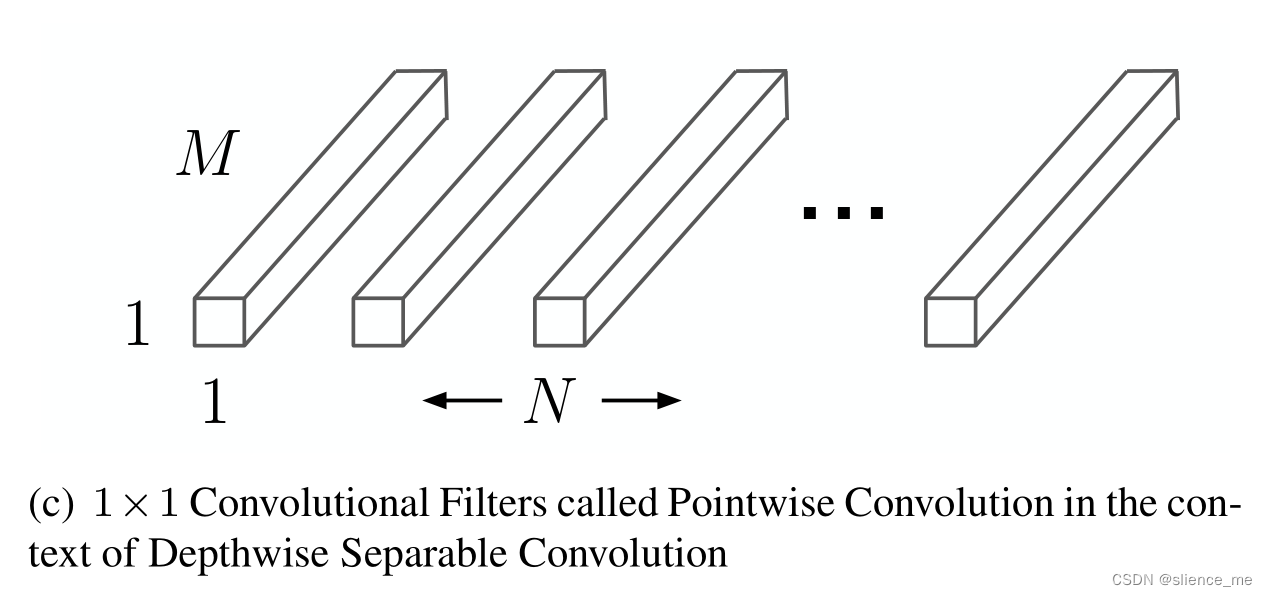

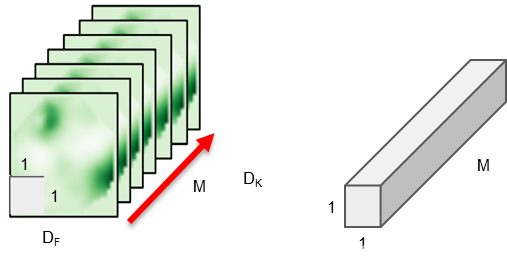

2.2 Pointwise Convolution

逐点卷积,采用了1×1×M的卷积核对2.1中深度卷积的结果进行逐点卷积操作,详细来说:

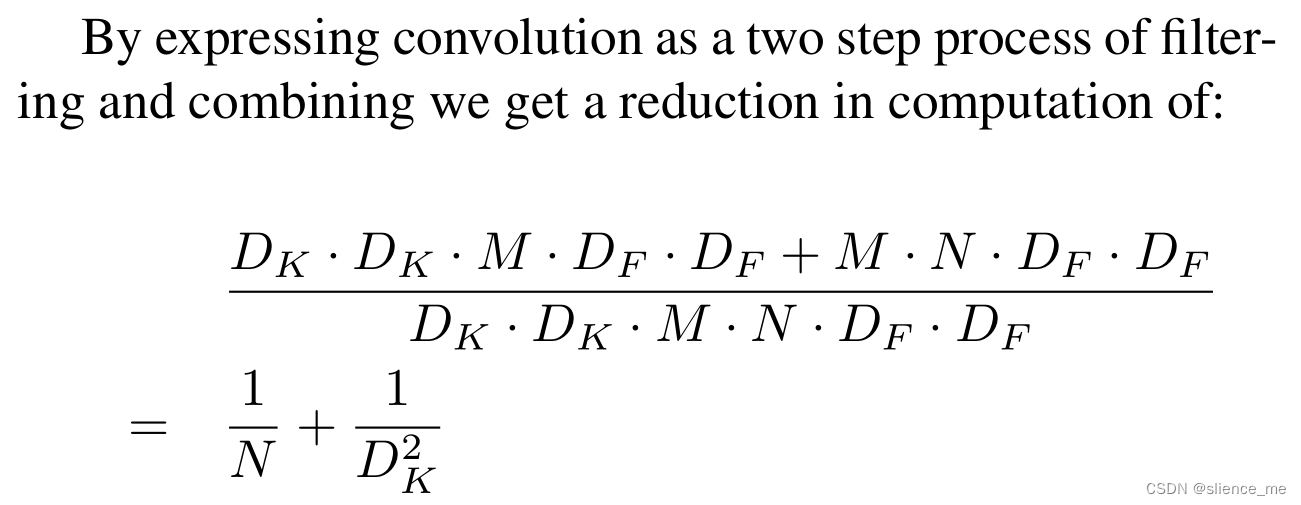

优点

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。