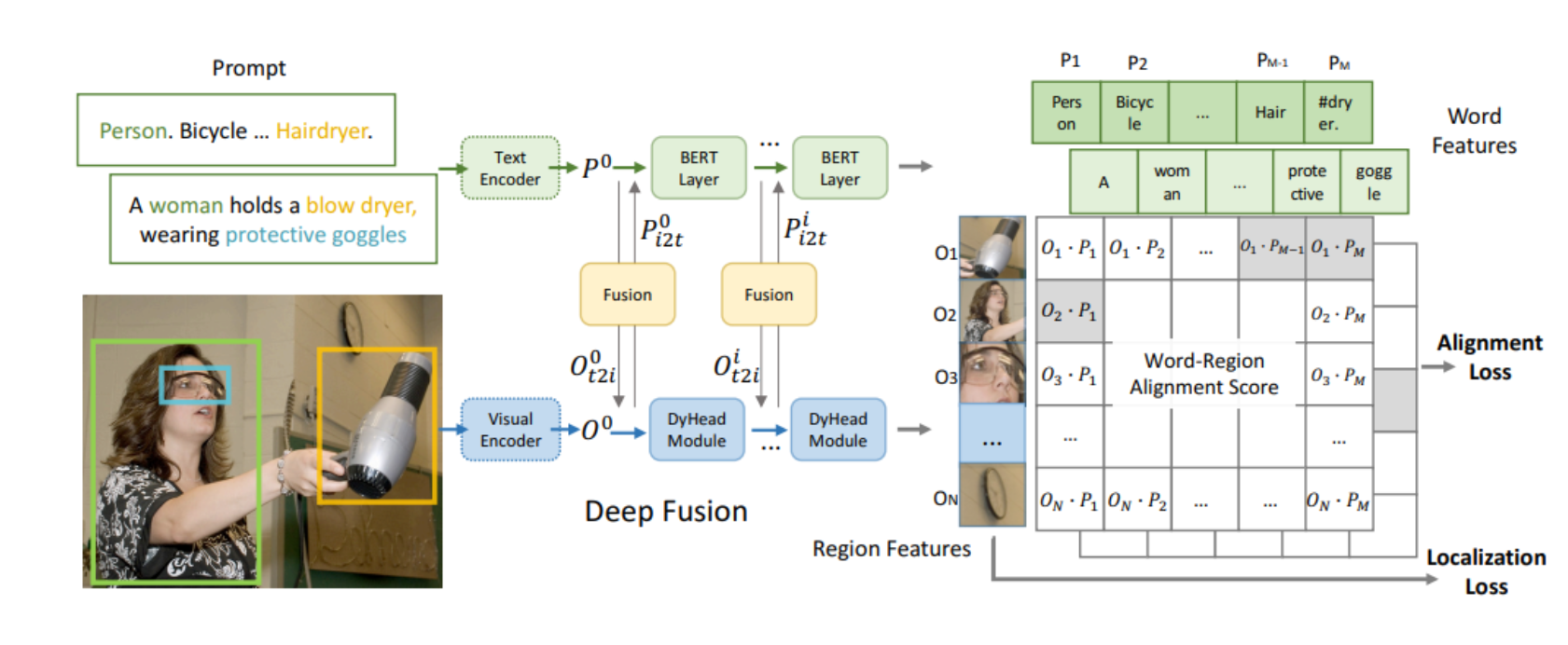

本文介绍: 它通过同时考虑前后的信息来处理视觉数据,这样做可以提高模型对图像内容的理解能力,特别是在需要理解像素之间复杂关系的视觉任务中。虽然它们的应用领域(视觉数据处理与序列数据处理)和具体实现细节可能有所不同,但基本的理念——即同时考虑前后信息来获得更全面的理解——是相似的。是的,你提到的“采用的双向序列建模(the bidirectional sequence modeling)”确实与“双向RNN(Bidirectional Recurrent Neural Networks)”的思路有相似之处。

1 学习资料

论文:《Vision Mamba: Efficient Visual Representation Learning with Bidirectional State Space Model》

阅读资料

【博文】《入局CV,Mamba再显神威!华科王兴刚团队首次将Mamba引入ViT,更高精度、更快速度、更低显存!》

【代码复现】《挑战Transformer的新架构Mamba解析以及Pytorch复现》

2 引言

(1)南溪:论文中的“Vim Block”采用的“the bidirectional sequence modeling”跟“双向RNN”的思路有点像

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。