本文介绍: 一转眼的时间,2024年了,翻看了一下博客首页,已有8年的码领,自从去年开启博客关注才能预览,至今已有1500个粉丝,比其他短视频平台的粉丝还要多,经年累月,8年一瞬,在码代码的道路上越来越不快乐,为何不快乐,因为寻觅不到快乐的源泉。————- “何以解忧,唯有暴富”

写在前面:

一转眼的时间,2024年了,翻看了一下博客首页,已有8年的码领,自从去年开启博客关注才能预览,至今已有1500个粉丝,比其他短视频平台的粉丝还要多,经年累月,8年一瞬,在码代码的道路上越来越不快乐,为何不快乐,因为寻觅不到快乐的源泉。

————- “何以解忧,唯有暴富”

需求

开发一个系统,主要是将数仓中治理完用于检索的数据灌入Elasticsearch中,一般情况,开源的一些系统都可以满足情况,包括自己编写代码实现。系统开发主要用于数据产品的产品化,需要开发界面和后续开发完成软著的申请

设计思路

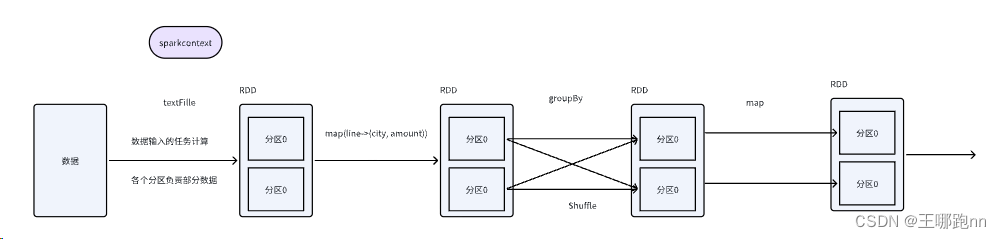

使用spark sql进行处理,之前也调研了抽象语法树生成代码的方式,也能实现功能,相对于sparksql方式稍显复杂,spark sql只需要将sql 字符串传入,生成临时试图,多表关联也可以通过参数传入,多表join将sql传入,并将需要用到的配置以参数方式传入,这样jar报的编码只需要对应一个模板主类入口,其他的参数从前端页面上配置传入。

主要代码

多表join 多几个 df.createOrReplaceTempView(table_name) ,将代码打成jar包,系统前端页面参数通过服务端传入并提交执行在大数据集群节点

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。