本文介绍: 其他可能影响训练过程的因素包括优化器的选择、损失函数的选择以及训练数据集的大小和组成。重要的是要仔细考虑和配置这些设置,以确保导出的模型针对预期用例经过优化,并且可以在目标环境中有效使用。所有训练指标将自动记录在您选择的平台中,您可以访问这些日志以监控模型随时间的表现,比较不同模型,并识别改进的领域。恢复训练时,Ultralytics YOLO将加载最后保存的模型的权重,并恢复优化器状态、学习率调度器和时期编号。YOLO 模型的导出设置是指用于在其他环境或平台中使用模型时保存或导出模型的各种配置和选项。

Yolov8使用

使用Ultralytics YOLO进行模型训练

使用示例

姿态模型

目标检测

数据集格式

在COCO128数据集上训练YOLOv8n模型100个时期,图像大小为640。可以使用device

参数指定训练设备。如果没有传递参数,并且有可用的GPU,则将使用GPU device=0,否则将使用device=cpu。有关完整列表的训练参数,请参见下面的参数部分。

!!! 示例 “单GPU和CPU训练示例”

设备将自动确定。如果有可用的GPU,那么将使用它,否则将在CPU上开始训练。

多GPU训练

多GPU训练通过在多个GPU上分布训练负载,实现对可用硬件资源的更有效利用。无论是通过Python API还是命令行界面,都可以使用此功能。

若要启用多GPU训练,请指定您希望使用的GPU设备ID。

要使用2个GPU进行训练,请使用CUDA设备0和1,使用以下命令。根据需要扩展到更多GPU。

恢复中断的训练

在处理深度学习模型时,从之前保存的状态恢复训练是一个关键特性。在各种情况下,这可能很方便,比如当训练过程意外中断,或者当您希望用新数据或更多时期继续训练模型时。

参数

记录

TensorBoard

Ultralytics YOLO 的模型导出

使用示例

参数

导出格式

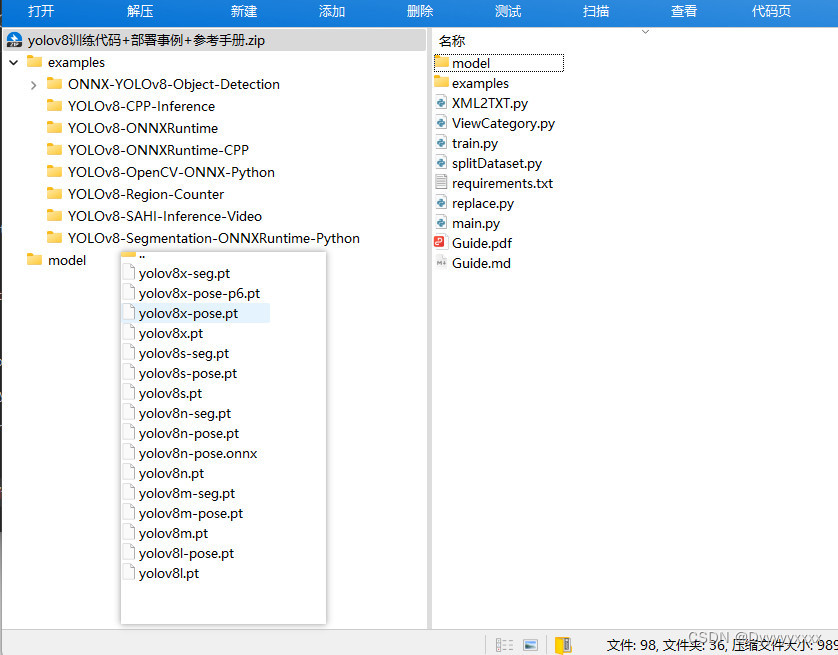

Yolov8 训练代码+部署事例+参考手册 1G资料

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。