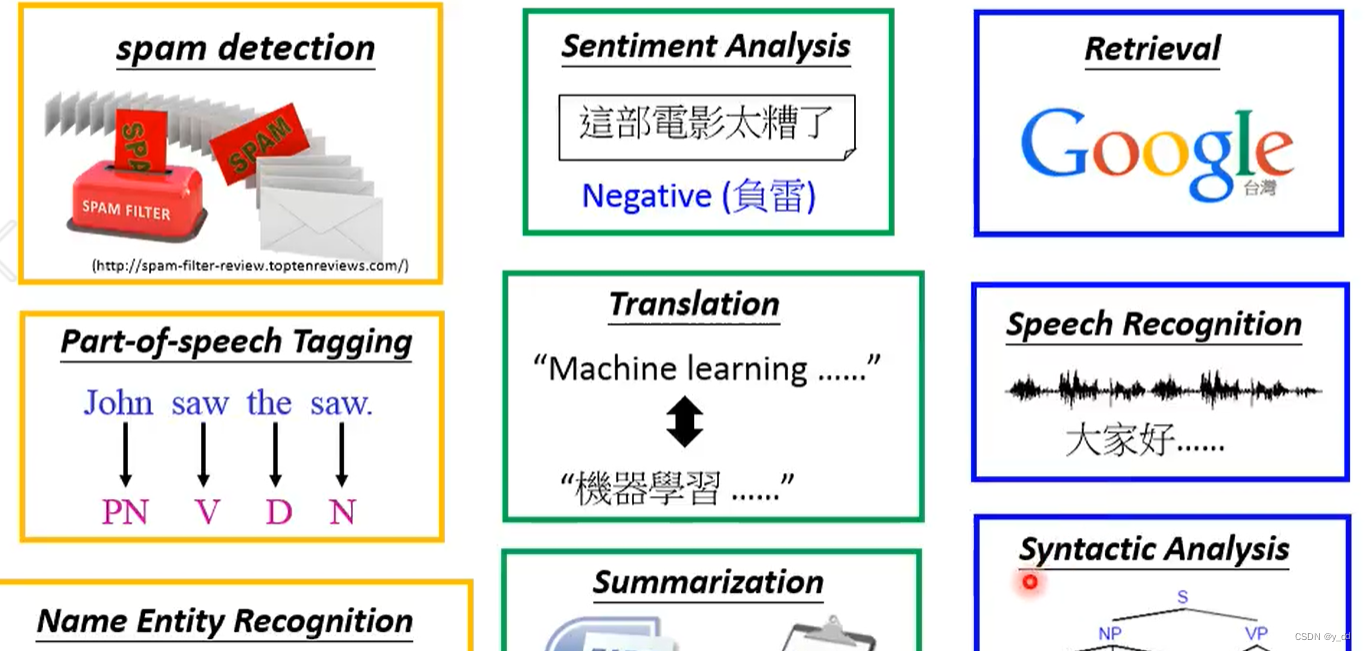

本文介绍: 用向量表示物品(如单词、产品或新闻文章),以便最小化相似项目之间的距离,最大化不同项目之间的距离。将张量乘以或加上一个标量不会改变张量的形状,其中张量的每个元素都将与标量相加或相乘。第一个性质是:如果我们按常数因子a缩放向量的所有元素, 其范数也会按相同常数因子的。由于输入矩阵沿0轴降维以生成输出向量,因此输入轴0的维数在输出形状中消失。目标是深度学习算法最重要的组成部分(除了数据),通常被表达为范数。(size)概念不涉及维度,而是分量的大小。每个ai⊤都是行向量,表示矩阵的第i行。

1、加法运算

2、乘法运算

将张量乘以或加上一个标量不会改变张量的形状,其中张量的每个元素都将与标量相加或相乘。

3、降维

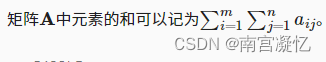

可以计算任意形状张量的元素和。

指定张量沿哪一个轴来通过求和降低维度。

为了通过求和所有行的元素来降维(轴0),可以在调用函数时指定axis=0。 由于输入矩阵沿0轴降维以生成输出向量,因此输入轴0的维数在输出形状中消失。

沿着行和列对矩阵求和,等价于对矩阵的所有元素进行求和。

平均值通过将总和除以元素总数来计算平均值。

计算平均值的函数也可以沿指定轴降低张量的维度。

4、非降维求和

有时在调用函数来计算总和或均值时保持轴数不变会很有用。

由于sum_A在对每行进行求和后仍保持两个轴,可以通过广播将A除以sum_A。

沿某个轴计算A元素的累积总和, 比如axis=0(按行计算),可以调用cumsum函数。 此函数不会沿任何轴降低输入张量的维度。

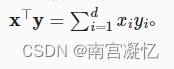

5、点积

torch.dot(x,y) 点积是两个向量相同位置的按元素乘积的和。

也可以通过执行按元素乘法,然后进行求和来表示两个向量的点积。

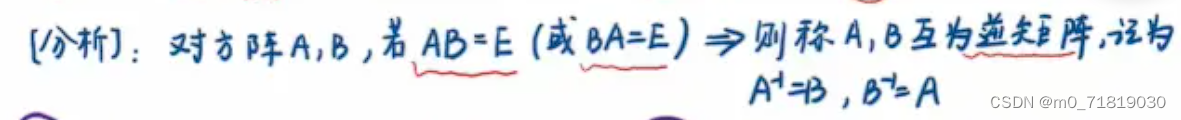

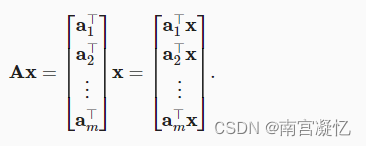

6、矩阵-向量积

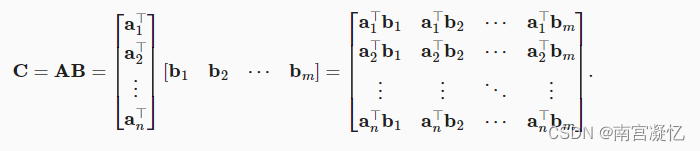

将矩阵A用它的行向量表示

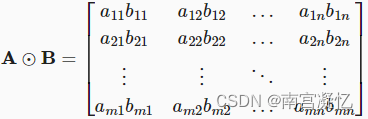

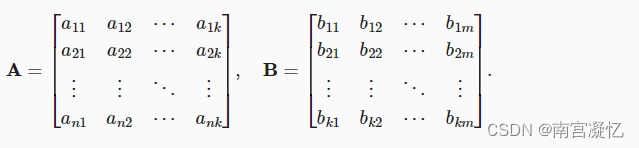

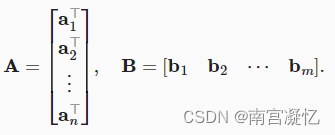

7、矩阵-矩阵乘法

8、范数

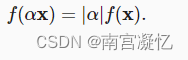

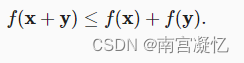

向量范数是将向量映射到标量的函数f。

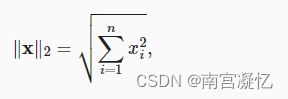

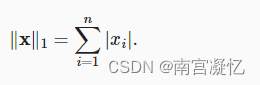

L2范数是向量元素平方和的平方根(向量)

L1范数是向量元素的绝对值

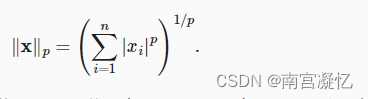

Lp一般范数

Frobenius范数是矩阵元素平方和的平方根(矩阵的L2范数)

范数和目标

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

ai行向量, bj列向量。

ai行向量, bj列向量。