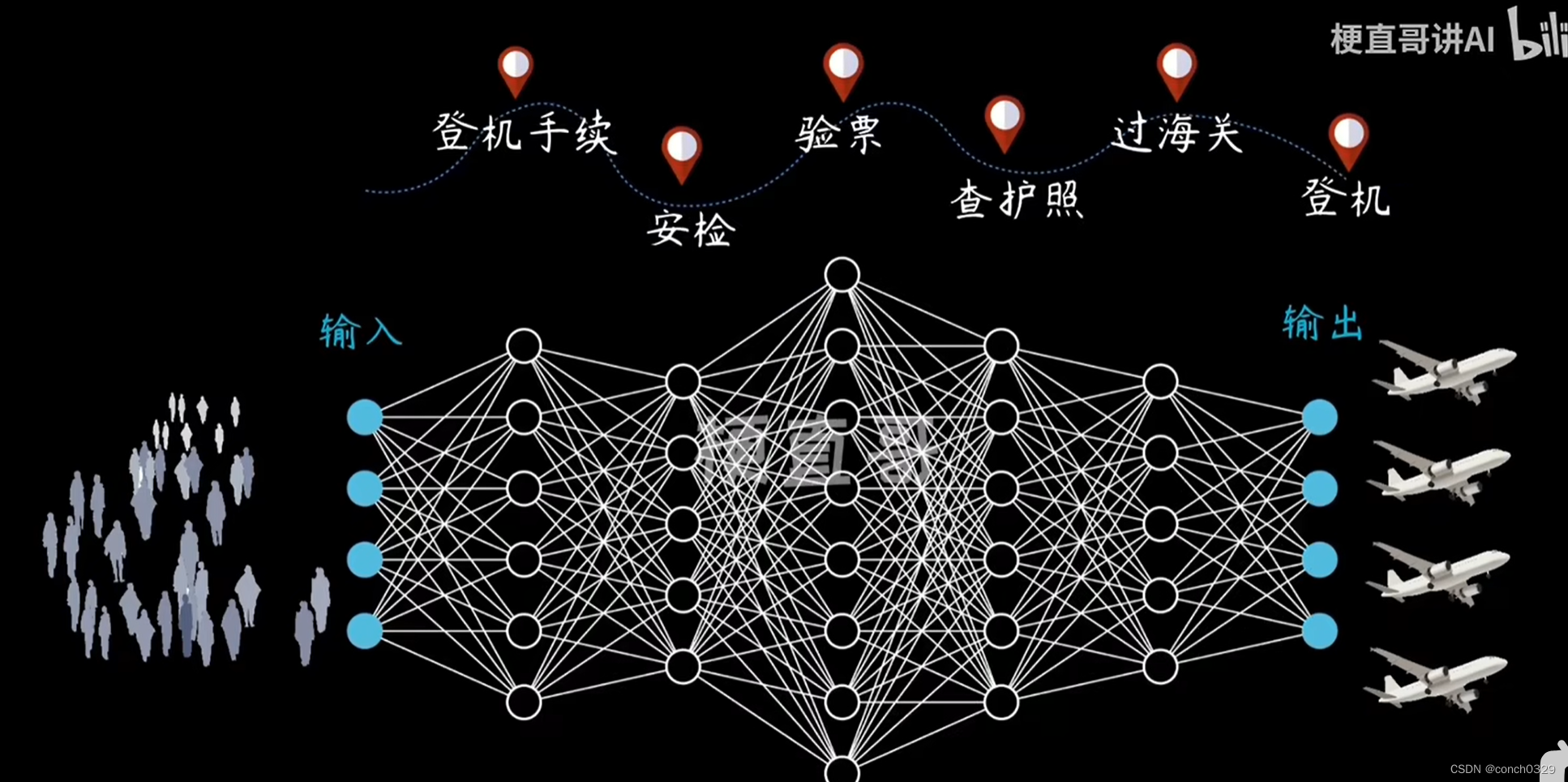

本文介绍: GPT的全称是”Generative Pre–training Transformer”,翻译成中文的意思是“生成式预训练转换器”。那么GPT到底是个什么东西呢?GPT是由OpenAI实验室开发的自然语言处理(NLP:Natural Language Processing) 模型。那什么是“模型”呢?模型就是一个数学中的函数,函数有输入参数和输出参数,我们给同一个函数输入了不同的参数,这个函数会产生不同的输出。通过数据集进行大量的训练,调整权重,从而得到的Text Generation模型。

没想到2023年的双11之后,还能看到如此多的科技圈大佬针对GPT提出火药味十足的讨论和极具戏剧性的表演。

历史回顾:

似乎这些热度都胜过月底的黑五节,但引发这一切争议的就是GPT之战:

什么是GPT

GPT的全称是”Generative Pre-training Transformer”,翻译成中文的意思是“生成式预训练转换器”。那么GPT到底是个什么东西呢?GPT是由OpenAI实验室开发的自然语言处理(NLP:Natural Language Processing) 模型。那什么是“模型”呢?模型就是一个数学中的函数,函数有输入参数和输出参数,我们给同一个函数输入了不同的参数,这个函数会产生不同的输出。通过数据集进行大量的训练,调整权重,从而得到的Text Generation模型。

OpenAI

OpenAI 由伊隆·马斯克、萨姆·奥特曼以及其他科技界的杰出领袖于 2015 年 12 月联合创立,最初是一个非盈利的人工智能研究实验室,名为 OpenAI Inc 503©(3) public charity。该实验室专注于开发对人类友好的 AI 技术,其核心宗旨是推进 AI 技术的发展,同时确保这些技术的应用对全人类都能带来积极的影响。

从成立之初,OpenAI 便郑重承诺其研究成果将是开源的,以促进全球 AI 领域的合作与进步。这一承诺不仅凸显了 OpenAI 对技术创新的追求,更强调了技术的伦理性和普惠性,旨在通过其工作来推动构建一个由高度发达且安全的人工智能技术支持的未来。

奥特曼

个人看法

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。