本文介绍: Transformer是一种基于自注意力机制的神经网络结构,它通过多头自注意力机制和位置编码,解决了传统RNN在处理长序列时的问题,大大提高了NLP任务的性能。此外,还要注意模型的泛化能力,避免过拟合和欠拟合等问题。通过不断探索新的技术和应用场景,以及解决伦理和社会问题,相信NLP技术将在未来发挥更大的作用,为人类社会的发展做出更大的贡献。此外,还有一些更先进的技术如BERT、GPT系列模型等预训练语言模型,这些模型通过对大量无标签数据进行预训练,学习到了丰富的语言知识,进一步推动了NLP技术的发展。

自然语言处理的发展

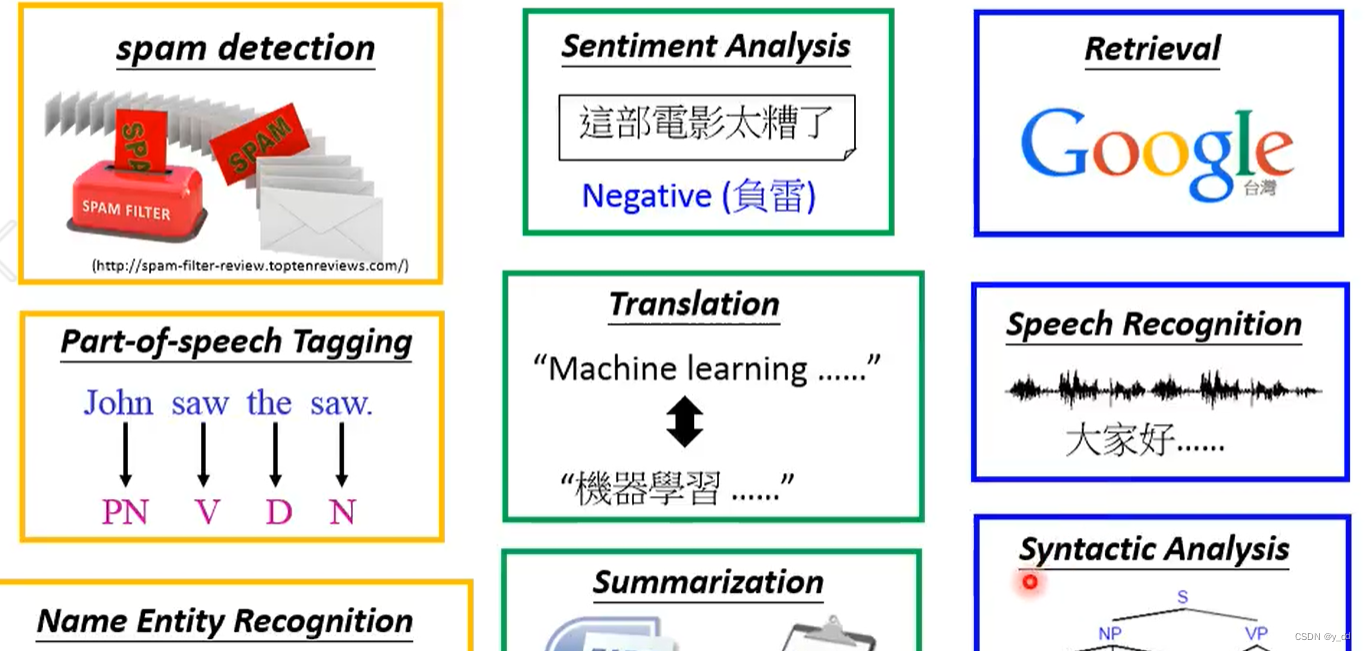

自然语言处理(NLP)作为人工智能领域的一个分支,旨在让计算机理解和生成人类语言。随着深度学习和大数据技术的不断进步,NLP在近年来取得了显著的突破。本文将探讨NLP技术的发展历程、最新技术进展以及未来展望。随着深度学习和大数据技术的进步,自然语言处理取得了显著的进步。人们正在研究如何使计算机更好地理解和生成人类语言,以及如何应用NLP技术改善搜索引擎、语音助手、机器翻译等领域。

一、技术进步

词嵌入是一种将词汇向量化的技术,它将每个词汇表示为一个实数向量,使得语义上相似的词汇在向量空间中的距离更近。RNN是一种用于处理序列数据的神经网络,它在NLP中广泛应用于文本分类、情感分析、机器翻译等领域。Transformer是一种基于自注意力机制的神经网络结构,它通过多头自注意力机制和位置编码,解决了传统RNN在处理长序列时的问题,大大提高了NLP任务的性能。

此外,还有一些更先进的技术如BERT、GPT系列模型等预训练语言模型,这些模型通过对大量无标签数据进行预训练,学习到了丰富的语言知识,进一步推动了NLP技术的发展。。

二、应用场景

三、挑战与前景

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。