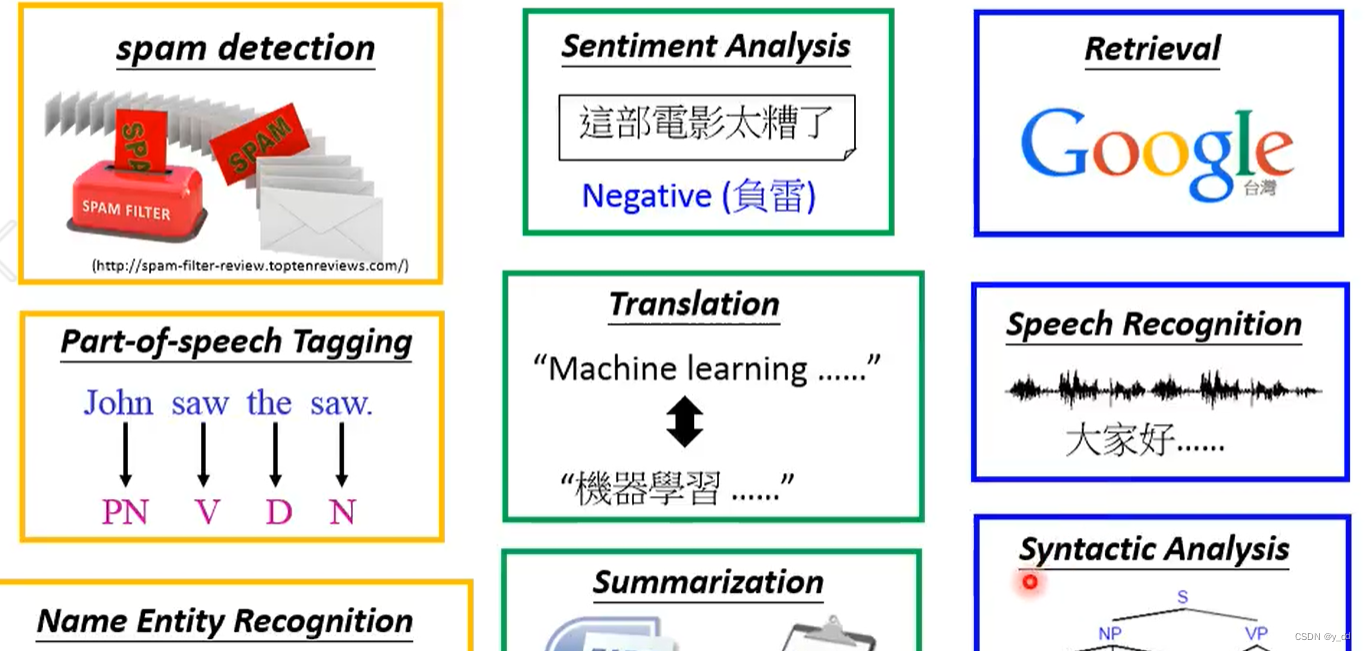

随着深度学习和大数据技术的不断进步,自然语言处理(NLP)领域已经取得了显著的成果。从简单的文本分类到复杂的机器翻译,NLP技术正在不断突破,为人工智能领域带来更多可能性。本文将简要介绍自然语言处理技术的最新进展,并探讨其在搜索引擎、语音助手、机器翻译等领域的应用。

一:技术进步

自然语言处理(NLP)是人工智能的一个重要分支,它涉及到使计算机能够理解、解释和生成人类语言的技术。近年来,自然语言处理技术取得了显著的进步,这主要得益于以下几种关键技术的快速发展:

1、词嵌入(Word Embedding)

词嵌入是将词汇表中的每个词映射到一个固定大小的向量。这种表示形式能够捕捉词的语义和句法信息,使计算机能够理解和处理词汇之间的关系。word2vec、GloVe等模型是实现词嵌入的流行方法。在NLP任务中,词嵌入有助于提高模型对语言的理解能力,如文本分类、情感分析、机器翻译等。

2、循环神经网络(Recurrent Neural Network, RNN)

RNN 是一种能够处理序列数据的神经网络。由于语言是一种序列数据,RNN 非常适合处理自然语言。RNN 能够在序列的不同时间点保持信息的状态,这使得它们在处理诸如文本生成、机器翻译等任务时非常有用。但是,传统的 RNN 在处理长序列时存在梯度消失或爆炸的问题。

3、长短时记忆网络(Long Short-Term Memory, LSTM)

LSTM 是 RNN 的一种变体,它通过记忆单元来解决传统 RNN 在处理长序列时的梯度消失问题。LSTM 能够学习长期依赖关系,使其在处理自然语言时更加有效。LSTM 被广泛用于语言模型、文本分类、机器翻译等任务。

4、Transformer

Transformer 是一种基于自注意力机制的模型,它在2017年提出后迅速改变了NLP的研究和应用场景。Transformer 摒弃了传统的循环网络结构,转而使用自注意力机制来直接计算词语之间的关联,这使得模型能够同时考虑输入序列中所有位置的信息,大幅提高了处理长序列的能力。Transformer 已被用于多种NLP任务,包括机器翻译、文本生成、问答系统等,并且其架构也被扩展到了语音合成和图像处理等领域。

5、注意力机制(Attention Mechanism)

注意力机制允许模型在处理输入序列时关注序列中最重要的部分。在自然语言处理中,这意味着模型可以集中精力理解关键的词语或短语,忽略那些不重要的部分。注意力机制通常与 RNN 和 Transformer 结合使用,极大地提升了模型在诸如机器翻译、文本摘要等任务上的性能。