1. 拓扑空间

1.1 拓扑空间概念

拓扑空间是一种数学概念,其核心在于定义了一种“邻域”结构,而非具体的距离或度量关系。在拓扑空间中,我们关注的是点之间连通性的全局属性,例如哪些点可以通过连续变形相互转换,哪些集合是开集、闭集,以及整个空间是否具有紧致性等特性。

拓扑空间的核心是通过“邻域”结构来刻画集合上的几何和拓扑性质。在这样的空间中,邻域定义了一种局部属性,它描述了每一点周围的点如何以某种方式相对聚集在一起。具体来说,拓扑空间由以下基本公理确定:

-

邻域公理:对于空间中的任意点x和该点的任意邻域U,都存在另一个包含x在内的邻域V,使得任何包含V的邻域也包含U(这称为邻域基或内点性)。

-

空集和全集的性质:整个集合X以及空集∅都是拓扑空间中的开集。

-

有限交集性质:任意有限个开集的交集仍是一个开集。

-

任意并集性质:任意多个开集的并集仍是一个开集。

基于这些公理,我们可以定义闭集、开闭集、聚点、边界、闭包等概念,并进一步研究空间的连通性、分离性和紧致性等全局特性。

- 连通性指的是空间中是否存在无法分解为两个不相交且非空开子集的情况。

- 分离性探讨空间中点与点、点与集合、集合与集合之间是否可以被“分开”,比如豪斯多夫分离性、正规性等。

- 紧致性则是一种非常重要的性质,在一个拓扑空间中,如果每个覆盖该空间的开集族都有一个有限子族能同样覆盖该空间,则称此空间为紧致。在紧致空间上,连续函数确实可以在有界闭集上取得最大值和最小值,这是紧致性的一个重要应用。

拓扑空间的概念极大地拓宽了数学分析和其他领域如代数拓扑、泛函分析、微分几何的研究范围,因为其抽象性质允许我们讨论各种不同类型的“形状”和“变形”,而无需依赖具体的距离度量。在现代数据分析领域,特别是在拓扑数据分析(TDA)中,这些概念也被用来揭示复杂数据集的内在结构和模式。

1.2 拓扑空间的研究内容和方向

拓扑空间的研究内容和方向广泛且深入,涵盖多个数学分支领域。以下是一些主要的研究内容和方向:

-

基础拓扑学:

- 空间结构的定义和分类:研究如何通过邻域、开集、闭集等基本概念来定义拓扑空间,并探讨不同拓扑空间之间的同胚关系。

- 连通性理论:分析拓扑空间中的连通性、道路连通性、局部连通性和完全不连通性等属性。

- 分离公理与分离性质:例如豪斯多夫空间(Hausdorff空间)、正规空间、完全正规空间、正则空间、Tychonoff空间等,这些不同的分离性条件对应于空间中点或集合之间可以达到何种程度的分离。

- 基本拓扑不变量:如紧致性、完备性、可度量化、一致连续性等。

-

代数拓扑学:

- 同调论与同伦论:利用群论工具研究空间的全局特性,比如计算同调群、同伦群等不变量,以区分不同的拓扑空间。

- 凸包和单纯复形:将拓扑空间用更简单的对象(如单纯形)构建的复形来近似,并研究它们的拓扑性质。

- 度量空间上的覆盖空间理论,如弗雷德霍姆(Fredholm)理论和塞尔(Serre)纤维丛理论等。

-

泛函分析中的拓扑空间:

- 巴拿赫空间、希尔伯特空间和其他赋范线性空间:研究具有内积和范数结构的拓扑空间及其上的算子理论。

- 测度理论和拓扑测度空间:涉及概率空间、Lebesgue积分、Borel σ-代数以及Radon-Nikodym定理等内容。

-

微分拓扑学:

- 微分流形理论:研究具有局部欧几里得结构的拓扑空间,以及流形上的微分结构、切丛、联络等。

- 黎曼几何和辛几何中的拓扑问题:在具有额外几何结构的空间上探讨拓扑性质,如高维流形的分类、奇异纤维化等。

-

低维拓扑学:

- 二维和三维流形的分类与特征化,包括著名的庞加莱猜想等重要问题。

-

动力系统与遍历理论:

- 在拓扑空间上定义的动力系统的行为,研究其长期动态性质,如吸引子、周期轨道的存在性、稳定性和遍历性。

-

拓扑数据分析(TDA):

- 利用拓扑学原理对数据进行分析和建模,特别是复杂高维数据集中找出稳定的拓扑特征,如 Persistent Homology(持久同调)。

-

非交换几何与量子拓扑:

- 结合代数和量子物理,研究非交换代数环上的拓扑空间及相应几何结构。

拓扑空间的理论不仅在纯数学内部有着深远的影响,也在诸如物理学、计算机科学、工程学和统计学等领域找到了应用。

2. 拓扑不变量

拓扑不变量是一类在同胚映射下保持不变的数学对象或数值,是拓扑学的核心概念之一。它们用于刻画和分类拓扑空间,即使在不考虑具体点的位置和形状而只关注空间的整体结构时,也能区分不同的拓扑空间。以下是一些重要的拓扑不变量:

-

同伦群(Homotopy Groups):

- 第0同伦群π₀对应于连通分支的数量。

- 高阶同伦群πₙ描述了n维球体可以连续变形到给定空间的方式。

-

同调群(Homology Groups):

- 同调群是通过链复形理论定义的,度量空间中洞的数目和类型。H₀记录路径连通分量数;H₁对应一维孔洞(如环面中的洞);更高维度的同调群则对应更复杂的多维空洞结构。

-

上同调群(Cohomology Groups):

- 上同调与同调类似,但提供了额外的信息,并且与流形上的系数向量空间有更多交互作用。

-

欧拉示性数(Euler Characteristic, χ):

- 欧拉示性数是一个全局整数不变量,它反映了拓扑空间内部闭合曲面的正负组合情况。对于多面体,它是顶点数减去边数加上面数。

-

贝蒂数(Betti Numbers, bₙ):

- 贝蒂数是同调群的秩,表示每个维度上“独立的洞”的数量。

-

弗雷德霍姆指数(Fredholm Index):

- 在算子理论中,弗雷德霍姆指数是某些线性算子的一个拓扑不变量,它反映了解空间和核空间之间的差异。

-

勒贝格指标(Lefschetz Fixed Point Theorem):

- 勒贝格固定点定理提供了一个计算空间中不动点数量的方法,该数量作为一个拓扑不变量。

-

链接数(Linking Number):

- 在三维空间中,链接数衡量两个闭曲线是否相互环绕的程度。

-

约当不变量(Jacobian Invariant):

- 在代数几何中,约当不变量描述了代数簇的奇异性质。

-

纽结不变量(Knot Invariants):

- 纽结理论中有一系列不变量,如亚历山大多项式、琼斯多项式等,它们能够区分不同的纽结。

-

持久同调(Persistent Homology):

- 在拓扑数据分析中,持久同调分析数据集的拓扑结构,包括生命周期(birth and death times)等,这些信息可以编码成 Persistence Diagram 或 Barcode,作为数据集的拓扑特征。

以上列表仅列举了部分常见的拓扑不变量,实际应用中还有许多其他类型的不变量及其相关理论,这些不变量在纯数学研究以及物理、化学、生物学、计算机科学等领域都有广泛应用。

3. 拓扑数据分析

3.1 拓扑数据分析

拓扑数据分析(Topological Data Analysis, TDA)是一门结合了拓扑学和数据分析的交叉学科,它旨在从高维数据中提取并量化形状、连接性和全局结构等信息。张量在TDA中的应用主要体现在以下几个方面:

-

Persistent Homology:

- 持久同调是TDA的核心工具之一,用于分析点云或网络等复杂数据集在不同尺度下的拓扑特性。通过构造一系列过滤器(如Vietoris-Rips Complex),可以生成一系列嵌入空间,并计算其同调群及其生命周期。

- 在这个过程中,虽然持久同调并不直接使用张量作为输入,但它产生的输出结果——持久图(Persistence Diagram)、barcode或者 Persistence Landscape 等,可以进一步转换为一阶或多阶张量形式,便于后续的机器学习模型处理。

-

多尺度特征表示:

- 通过对数据进行拓扑编码,可以将复杂的高维数据转化为低维且具有不变性质的向量或张量表示。例如,对持久图进行度量化处理后,可以用一个固定长度的向量来描述数据的拓扑特征,这种向量可以视为一种特殊的张量,适用于下游机器学习算法。

-

神经网络集成:

- 近年来,研究者开始探索将拓扑特征与深度学习相结合的方法,如基于张量的神经网络架构,这些架构能够接受经过拓扑变换的数据作为输入,比如利用张量来表示不同层次上的持久性特征,进而实现更高效地学习和推理。

-

张量分解与压缩:

- 对于大规模的多模态或高阶拓扑数据,可以通过张量分解技术(如CP分解、Tucker分解、Tensor-Train分解等)来进行降维和压缩,以减少计算复杂性和存储需求,同时保持数据的主要拓扑特征。

-

跨模态学习:

- 在涉及多种类型数据(如图像、文本、时间序列)的多模态拓扑数据分析中,张量可以作为一个通用容器,容纳来自不同模态的信息,并通过合适的张量操作和学习机制捕捉它们之间的潜在联系。

总之,在拓扑数据分析领域,张量不仅作为一种数据结构来组织和整合多维度的拓扑特征,而且越来越多地参与到拓扑特征的提取、表达、学习和推断过程中,从而促进了拓扑方法在实际问题中的广泛应用。

3.2 拓扑数据分析(TDA)领域中张量的应用

张量的应用主要体现在:

-

Persistent Homology:

- 持久同调是一种用于计算和分析数据集的拓扑不变量的方法。对于高维数据集,通过构建一系列嵌入空间(如Rips Complex或Čech Complex),可以追踪数据在不同尺度下的孔洞生成与消失情况,形成所谓的持久对(Persistence Pair)或者Barcode。

- 这些持久对中的出生时间和死亡时间可以被编码为数值向量或矩阵形式,这些低维表示包含了原始高维数据的拓扑信息,如环路数量、空洞大小等。

-

Filtered Complexes and Multidimensional Persistence:

- 在处理更复杂的数据时,可能会涉及到多维度的持久同调,此时可以用高阶张量来存储和表示不同维度的拓扑特征及其变化过程。

-

Topological Features as Inputs for Machine Learning Models:

- 经过上述处理后得到的拓扑不变量(如持久图像或对应的向量化表示)可以作为机器学习模型的输入特征,使得模型能够捕捉到数据内在的拓扑结构和模式,从而提高分类、聚类或其他预测任务的性能。

-

Topological Signal Processing (TSP):

- 在某些场景下,张量也被用来表示和处理信号在拓扑空间上的分布和变换,这种技术称为拓扑信号处理,在分析网络数据、时空序列数据等方面有潜在应用价值。

因此,张量不仅在传统数学领域中有着重要的地位,也在现代数据分析尤其是拓扑数据分析中扮演了关键角色,帮助研究者从新的角度理解和挖掘复杂数据的深层次结构。

4. 拓扑编码

拓扑编码(Topological Encoding)是一种将数据集中的复杂、高维且具有内在拓扑结构的信息转换为数值形式,通常是向量或张量,以方便在机器学习和数据分析中处理的方法。这种方法的核心是通过计算和量化数据的拓扑不变性质来捕捉其全局形状特征和层次结构。

具体而言,在实践中,常见的步骤包括:

-

构建拓扑空间:

- 首先对原始数据点集构造一个拓扑空间,例如通过距离度量构建邻接关系,或者使用网格化方法、覆盖树等几何或代数拓扑结构。

-

计算拓扑不变量:

- 应用拓扑数据分析(TDA)工具,如Persistent Homology,它能捕获不同尺度下的连通性、孔洞以及其他抽象拓扑特征,并记录这些特征在逐步增加参数(如半径或阈值)时的“出生”和“死亡”。

-

编码表示:

- 将计算得到的持久图、barcode、Persistence Diagram等信息转化为数值向量或矩阵形式,这些可以看作是每个拓扑特征的寿命信息的一维或多维表示。

-

降维与特征提取:

- 有时还需要进一步将高维的拓扑特征向量进行降维处理,如通过线性或非线性映射技术将其转换成低维空间中的向量,以便于后续的机器学习模型能够有效利用。

最终,这种转化后的数值向量或张量包含了原始数据集的高层次、鲁棒性的拓扑特性,能够在不丢失关键结构信息的前提下,用于各种分类、回归、聚类或其他机器学习任务。

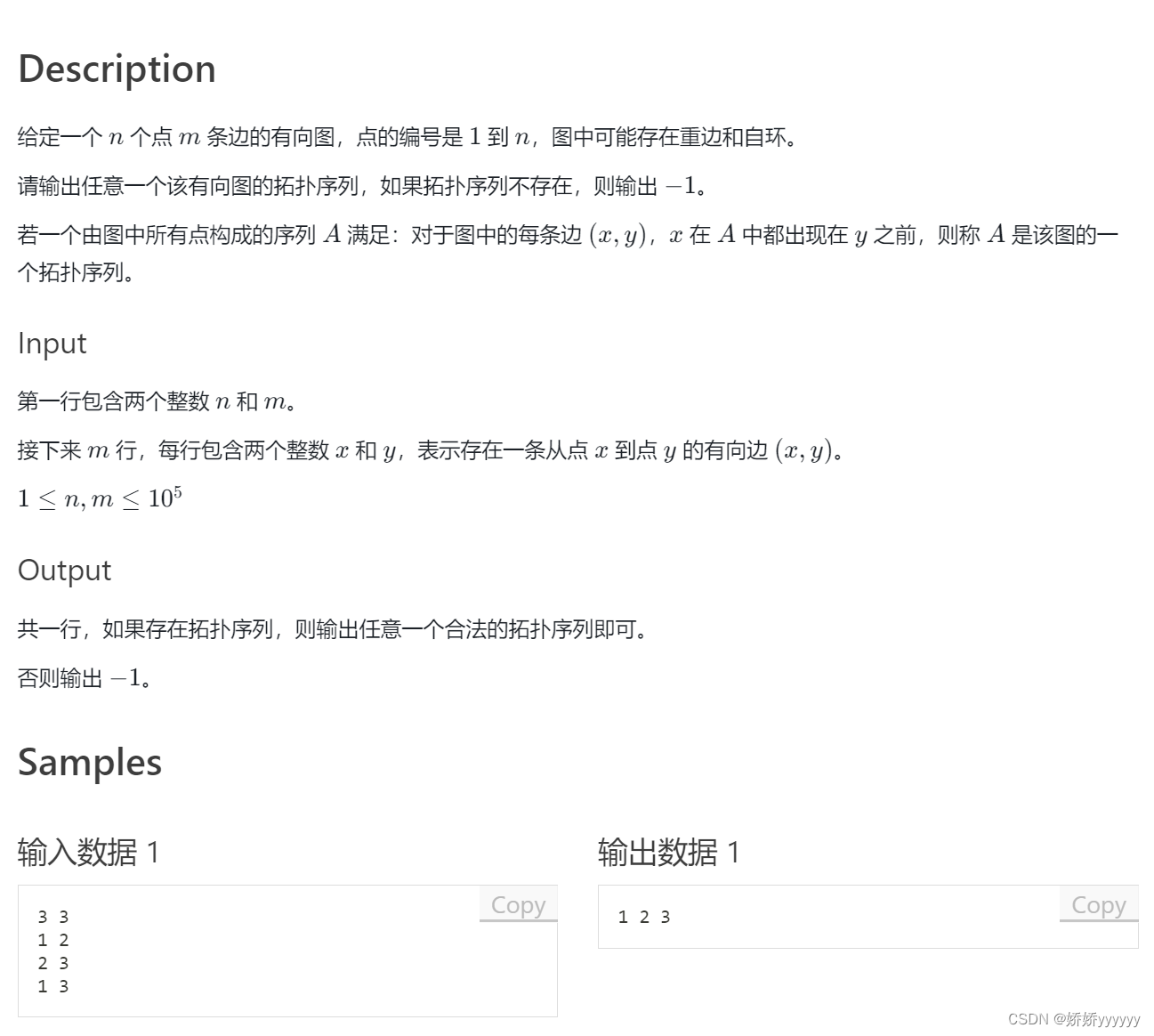

5. 将数据的拓扑结构转换为向量或张量

实现将数据的拓扑结构转换为数值向量或张量形式的具体过程会根据不同的数据类型和应用场景而变化。这里我们以一个简单的示例说明如何将网络数据(有向图)的拓扑特征转化为数值向量,然后进一步组织成张量。

假设我们有一个网络数据,表示为邻接矩阵 adjacency_matrix,其中节点数为 n。我们可以使用例如节点度数、聚类系数等基本网络统计量作为拓扑特征,并将这些特征编码成一个数值向量:

Python

1import numpy as np

2

3# 假设 adjacency_matrix 是一个 n x n 的numpy数组,代表了图的邻接矩阵

4n = adjacency_matrix.shape[0]

5

6# 计算节点度数

7degrees = np.sum(adjacency_matrix, axis=0)

8

9# 转换为向量形式

10topological_features_vector = degrees.reshape(1, -1) # 将一维向量扩展为二维列向量

11

12# 如果还有其他拓扑特征(比如聚类系数),可以计算并添加到向量中

13# clustering_coefficients = calculate_clustering_coefficients(adjacency_matrix)

14# topological_features_vector = np.hstack((degrees.reshape(1, -1), clustering_coefficients.reshape(1, -1)))

15

16# 若要构建多节点的特征张量

17# 假设每个节点有m个拓扑属性

18# topological_features_matrix = np.vstack((feature1, feature2, ..., feature_n)).T

19# 然后将其转换为张量

20# import torch

21# topological_features_tensor = torch.tensor(topological_features_matrix)

22

23# 对于更复杂的拓扑结构分析,如Persistent Homology中的Barcode或Persistence Diagram,

24# 需要使用专门的库(如Gudhi、Dionysus等)进行计算,并对结果进行编码如果我们要处理的是更高级的拓扑不变量,如通过持久同调得到的生命周期,则需要利用TDA相关的库来计算这些不变量,并将结果整理为数值形式。下面是一个简化的持久同调例子(但请注意,实际应用时可能需要更多的编程工作和安装相应的库):

Python

1from gudhi import RipsComplex, PersistentHomology

2

3# 假设 points 是点云数据集

4rips_complex = RipsComplex(points=points, max_edge_length=max_distance)

5simplex_tree = rips_complex.create_simplex_tree()

6

7# 计算一维持久同调

8births_deaths_1d = simplex_tree.persistence_intervals_in_dimension(1)

9

10# 编码为向量

11def intervals_to_vectors(intervals):

12 births_and_deaths = [(interval[0][1], interval[1][1]) for interval in intervals]

13 return np.array(births_and_deaths).flatten()

14

15vector_representation = intervals_to_vectors(births_deaths_1d)

16

17# 转换成张量

18topological_features_tensor = torch.tensor(vector_representation).unsqueeze(0)在上述持久同调的例子中,我们首先构造了一个Rips复形,然后计算了一维持久同调的生成与消失时间,并将它们编码为一个连续的数值向量。最后,为了适应深度学习框架,我们将这个向量封装成了一个张量。这仅是拓扑数据分析的一个简单实例,实际应用中可能还需要考虑更高维度的同调群和其他复杂情况。

6. 拓扑空间与Transformer

Transformer模型和拓扑空间是两个在数学和计算机科学中有着完全不同背景和用途的概念。

Transformer模型: Transformer是一种深度学习架构,特别针对序列到序列(sequence-to-sequence)的转换任务设计,如机器翻译、文本摘要生成等。Transformer摒弃了循环神经网络(RNN)在处理长序列时存在的梯度消失或梯度爆炸问题,以及计算上的顺序依赖性,通过引入自注意力机制来捕捉输入序列中的任意位置之间的关系。在Transformer模型中,编码器将输入序列映射为一个连续的向量表示,解码器则根据这些表示生成目标序列。位置编码是Transformer中用于保持输入序列顺序信息的重要组成部分。

拓扑空间: 拓扑空间是抽象代数拓扑学中的基本概念,它是一个集合与一组满足特定条件的子集(开集族)所组成的结构。在拓扑空间中,可以定义点的邻域、连通性、收敛性等一系列重要概念,这些概念并不依赖于具体的距离度量,而是基于开集的相对包含关系。拓扑空间理论在现代数学中有广泛的应用,例如在几何、分析、动力系统、泛函分析等领域,并且与之相关的还有同胚、连续函数、紧致性等诸多高级主题。

简而言之,Transformer模型主要用于解决自然语言处理等领域的具体应用问题,而拓扑空间则是数学中研究一般空间结构及连续性质的基础工具。两者虽然看似不相关,但在某些复杂的数据分析场景下,尤其是涉及高维数据分布结构和流形学习时,拓扑空间理论可能间接地对深度学习模型的设计与理解提供启发。

在深度学习和高维数据分析中,拓扑空间理论的概念与方法可以为理解和探索数据的内在结构提供深刻的见解。例如:

-

拓扑数据分析(Topological Data Analysis, TDA):这是一种利用拓扑学工具来研究复杂数据集全局形状的方法论。其中一个重要工具是 Persistent Homology(持续同调),它可以帮助我们识别并量化数据中的孔洞、环状结构等特征,这些特征在高维流形或非线性数据集中往往蕴含着重要的信息。

-

神经网络中的拓扑不变量:在某些情况下,深度学习模型可以通过嵌入层将输入映射到一个潜在空间,这个潜在空间的拓扑结构可能反映了原始数据分布的本质属性。研究这些潜在空间的拓扑特性有助于设计出对数据变换更鲁棒的模型。

-

图神经网络(Graph Neural Networks, GNNs):在处理节点关系复杂的图数据时,图的连通性和邻接结构实际上体现了某种拓扑性质。通过引入拓扑学思想,可以更好地理解图卷积操作如何传播和聚合信息。

-

动态系统建模:在连续时间序列数据建模中,系统的动力学行为可以通过连续映射或微分方程来描述,而这些映射的性质可以从拓扑角度分析,这对于设计能捕捉系统内在动态模式的神经网络架构具有启发意义。

因此,尽管Transformer模型本身不直接依赖于拓扑空间理论,但在理解和优化深度学习模型对于复杂数据结构的学习能力时,拓扑学方法可以提供有价值的视角和工具。

原文地址:https://blog.csdn.net/xw555666/article/details/135867095

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_64453.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!