本文介绍: 梯度下降算法,机器学习的精髓

1. 梯度下降算法

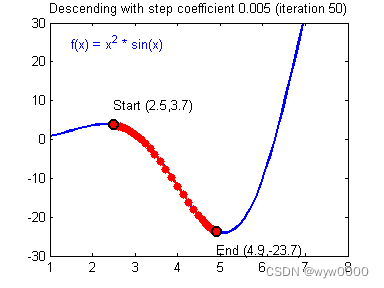

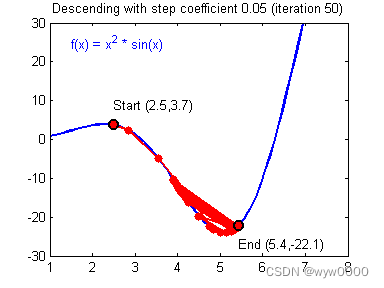

梯度下降算法是一种优化算法,用于最小化函数的数值方法。它通过沿着函数梯度的反方向来更新参数,以逐步减小函数值。这一过程重复进行直到达到收敛条件。梯度下降算法有多种变体,包括批量梯度下降、随机梯度下降和小批量梯度下降。这些变体在处理大规模数据和优化不同类型的函数时具有不同的优势。

2. 梯度下降求解

下面用一个例子来说明,使用梯度下降求极值的过程。

求y=

x

2

x^2

3. 总结

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。