本文介绍: 在本篇博客中,我们将深入探讨 Spark 分布式运行原理、面试题总结以及延伸知识点:关于Spark默认并行度spark.default.parallelism的理解

Spark系列文章:

大数据 – Spark系列《一》- 从Hadoop到Spark:大数据计算引擎的演进-CSDN博客

大数据 – Spark系列《二》- 关于Spark在Idea中的一些常用配置-CSDN博客

大数据 – Spark系列《三》- 加载各种数据源创建RDD-CSDN博客

目录

🍠Spark分布式运行原理

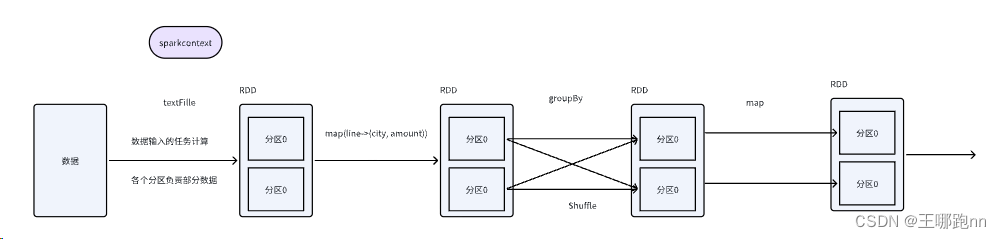

1)🧀编程抽象类 RDD

2)🧀分区数据处理

3)🧀统一的数据处理逻辑

4) 🧀统一的结果类型

🍠延申:关于Spark默认并行度spark.default.parallelism的理解

1. 🧀设置方式: 可以通过Spark配置项进行设置

2. 🧀影响因素

🍠Spark面试题总结:

1. Spark是什么,用于什么场景?

2. Spark的优点

3. Spark为什么比MR效率高?

4. Spark编程核心步骤

5. Spark运行模式有哪些?(.setMaster方法)

6. RDD是什么?

7. 创建RDD的方式有哪些?

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。