与基于屏幕空间的 2D人体姿态估计不同,3D人体姿态估计是尝试还原人体在三维世界中的形状与姿态,包括深度信息。绝大多数的现有3D人体姿态估计方法依赖2D人体姿态估计,通过获取 2D人体姿态后再构建神经网络算法,实现从 2D 到 3D人体姿态的映射。

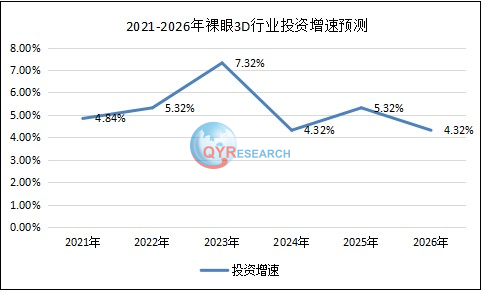

在 ARKit中,由于是采用计算机视觉的方式估计人体姿态,与2D人体姿态估计一样,3D人体姿态估计也受到遮挡、光照、姿态、视角的影响,并且相比于2D人体姿态估计,3D人体姿态估计计算量要大得多,也要复杂得多。但幸运的是,我们并不需要去关注底层的算法实现,ARKit会在检测到人体时直接提供一个ARBodyAnchor 类型对象,该对象包含一个 ARSkeleton3D类型的人体骨骼类型,通过这个类型可以获取所有检测到的人体骨骼关节点信息。ARBodyAnchor 描述了检测到的3D人形结构信息,其结构如下图所示。

对比图2D结构,可以看到,在 ARKit 中,2D与3D人体关节结构层次基本一致,唯一不同的是,在3D 人体结构中,多了一个表示 3D 人体空间位置信息的 Transform(ARBodyAnchor 下的Transform)。在使用上,这两者使用方法完全一样,只是代表3D 人体骨骼的Skeleton 结构比2D更复杂。

描述 3D人体骨骼结构的类为 ARSkeleton3D,也继承自 ARSkeleton 类,ARSkeleton3D 描述了3D空间中的人体骨骼节点结构。由于描述的人体结构是在三维空间中的层次结构,该类包含两个表示位置信息的数组 jointLocalTransforms 和 jointModelTransforms,其中jointLocalTransforms 描述的位置信息是某个节点相对其父节点的位置,而jointModelTransforms 描述的位置信息是相对检测到的ARBodyAnchor 位置。jointLocalTransforms 和 jointModelTransforms 包含的是3D空间中各关节点的位置信息矩阵。

在使用中,可以通过 ARSkeleton3D 的 localTransform(for: ARSkeleton. JointName)方法得到某个关节点相对其父节点的位置,此方法需要传递关节点的原始名称(rawValue)而不是ARSkeleton 预定义的关节点名(预定义关节点名可以通过其.rawValue 获取原始名称)。同样,我们也可以通过 modelTransform(for: ARSkeleton. JointName)方法得到某个关节点相对 ARBodyAnchor 的位置。