本文介绍: 尽量使用短key不要存过大的数据避免使用keys *:使用,来代替在存到Redis之前压缩数据设置 key 有效期选择回收策略(maxmemory-policy)减少不必要的连接限制redis的内存大小(防止swap,OOM)slowLog使用pipline批量操作数据。

0.为什么要使用缓存?

用缓存,主要有两个用途:高性能、高并发。

1. 高性能

尽量使用短key

不要存过大的数据

避免使用keys *:使用SCAN,来代替

在存到Redis之前压缩数据

设置 key 有效期

2. 高可用

2.1 单机版的高可用

2.2 Replication-Sentinel模式

2.3 Redis-Cluster模式

2.4 Proxy模式

2.4.1 数据分片

(1)Range分片

(2)节点取余分片

(3)一致性哈希分区

(4)虚拟槽分区

(5)Redis分区

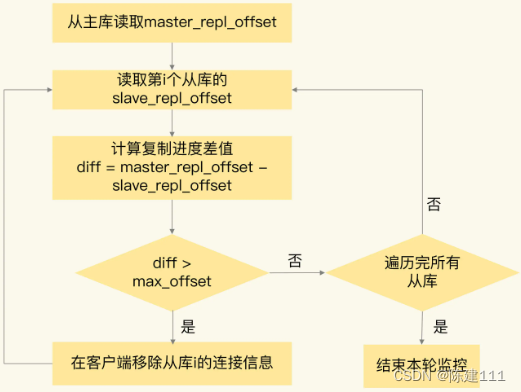

3. 主从复制

4. 分布式缓存的常见问题

4.1 缓存击穿

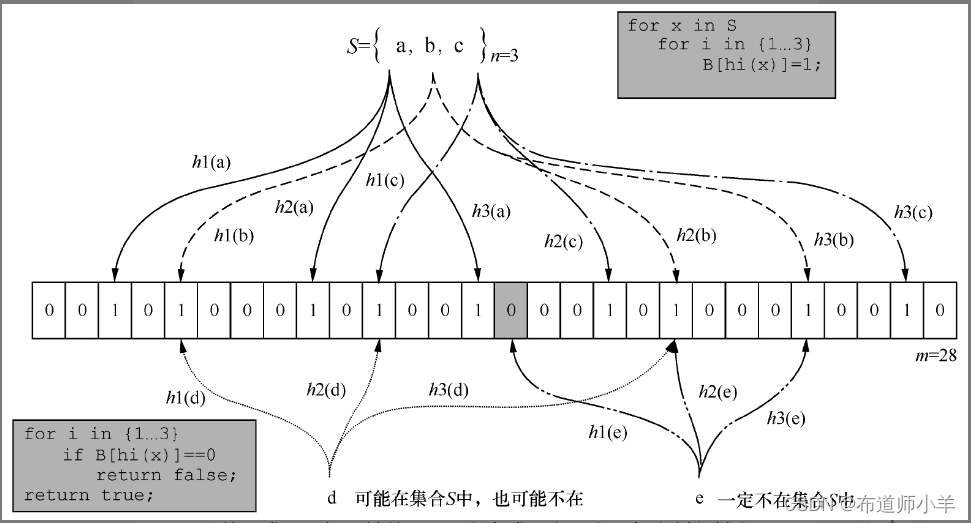

4.2 缓存穿透

4.3 缓存雪崩

4.4 缓存一致性

4.4.1 cache pattern

4.4.2 CacheAside数据不一致问题

4.5 数据丢失

5. 数据预热 & 冷热分离

6.多级缓存

6.1 二级缓存

6.1.1 本地缓存

6.1.2 多级缓存的数据一致性

6.2 三级缓存

7. 缓存选型

8. 缓存过期

8.1 过期策略

8.2 过期删除策略

9. BigKey问题

9.1 定义

9.2 产生原因

9.3 危害

9.4 bigKey识别

9.5 解决方案

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。