本文介绍: 本博客将介绍爬虫开发中常用的代理技术,并深入探讨代理IP的基础知识。我们将讨论为何在爬虫中使用代理,以及代理服务器的作用和类型。随后,我们将介绍如何构建一个本地代理池,以便在爬虫过程中动态管理和使用代理IP。我们将分享相关的代码示例,涵盖代理池的搭建、代理IP的获取和验证,以及如何在爬虫程序中使用代理IP。通过本文,您将深入了解爬虫代理技术的重要性,掌握构建本地代理池的实践方法,并在实际开发中提升爬虫的稳定性和效率。无论您是初学者还是有一定经验的开发者,本文都将为您提供有价值的指导和实用的代码示例。

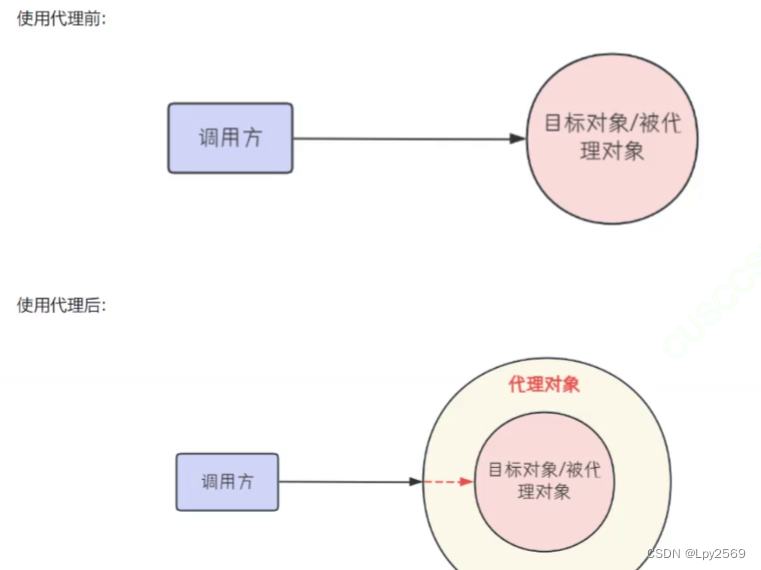

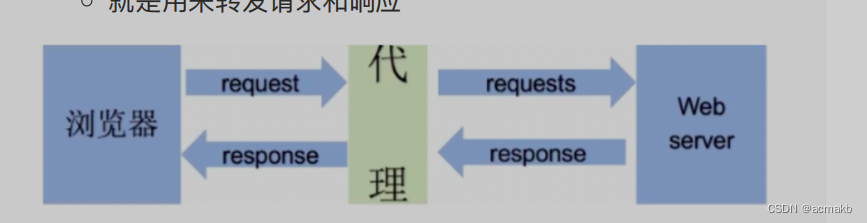

爬虫中代理的使用:

代理从哪里获得:

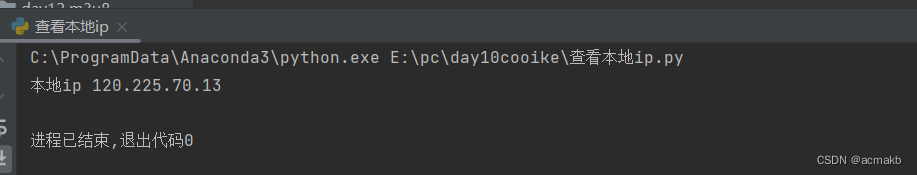

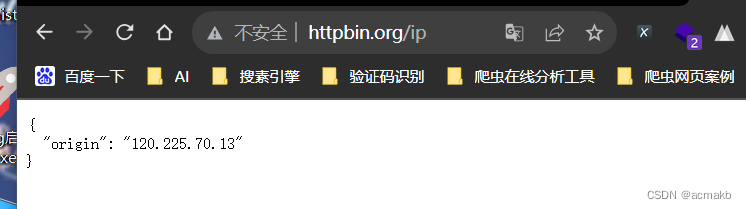

如何查询本地ip呢,网站:http://httpbin.org/ip,网页查看

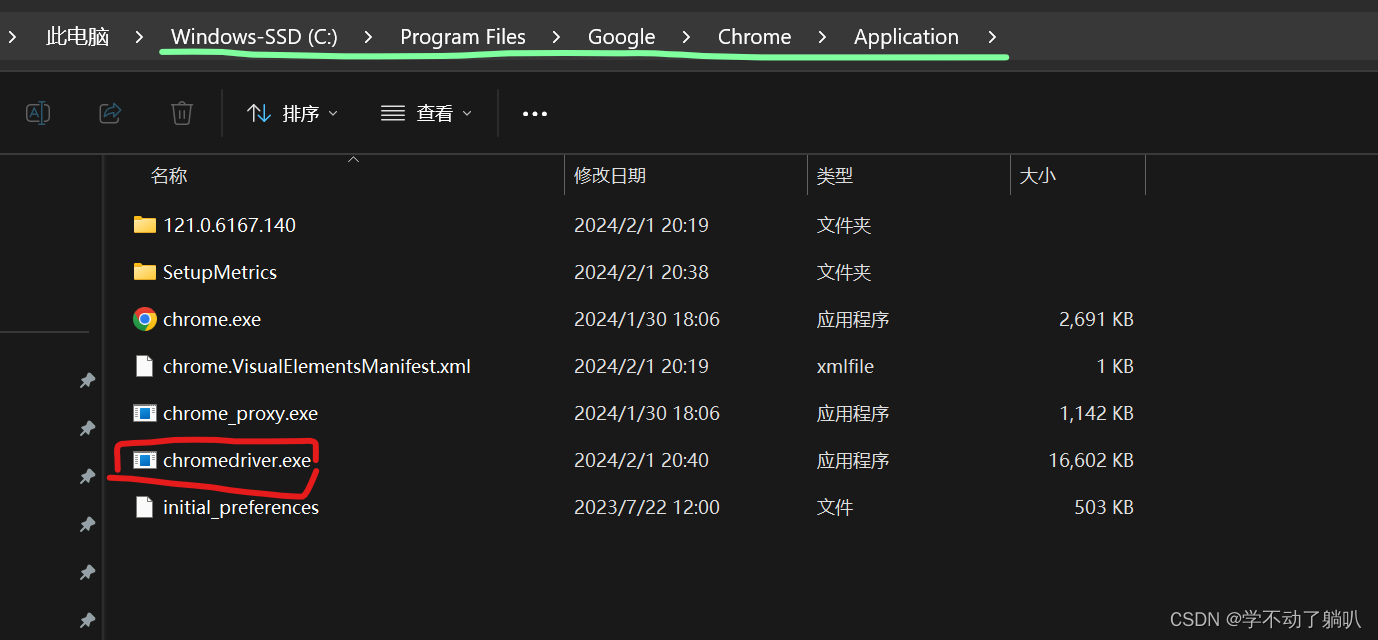

代理模板:

构建本地代理池:

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。